Sciences et Technologies

Sciences et Technologiesde l´Information et

de la Communication pour

l´Éducation et la Formation

version à télécharger (pdf)

Volume 18, 2011

Article de recherche

|

Contact : infos@sticef.org |

Le portfolio numérique : quelles évolutions des usages et des représentations chez les formateurs d’enseignants ?

1. IntroductionLa notion même de portfolio revêt des formes sensiblement différentes dans le contexte des formations professionnalisantes et des différents dispositifs internationaux qui s’y rattachent. On retrouve cette diversité des approches dans le domaine de l’éducation et de la formation (Abrami et Barett, 2005), (Baron et Bruillard, 2003), (Barrett, 2001), (Doolittle, 1994), (Barton et Collins, 1993), (Wolf, 1991). Ainsi, de nombreuses études ont été menées autour des « teaching portfolios » et de la place de l’évaluation, qu’elle soit formative, sommative ou certificative (« Teacher Portfolio Assessment »), mais également concernant le rôle de l’auto-évaluation et des interactions entre étudiants et formateurs. Mais au-delà de la formation et de l’évaluation d’un individu, des compétences qu’il a su ou pu développer dans le cadre d’un processus donné (approche dynamique), le portfolio permet le plus souvent un positionnement individuel et réflexif autour des différents acquis, un retour sur les expériences et sur les traces issues du parcours réalisé. Des initiatives et des dispositifs innovants ont ainsi vu le jour depuis plus de cinq ans dans différentes structures universitaires de formation des enseignants, en particulier dans les IUFM. C’est le cas des ePortfolios (« electronic portfolios »1) dont l’essor est à rapprocher des évolutions majeures récentes de la formation des enseignants et de la priorité donnée à l’évaluation des compétences professionnelles (Romainville, 2001), (Baillat, 2008), (Baillat et al., 2007), (Connan et Vincent, 2008 & 2010), (Emprin et Lagrange, 2007), (Emprin et Vincent, 2007). Nous pouvons souligner par ailleurs, que l’internationalisation du phénomène est clairement identifiable depuis quelques années, en particulier avec le développement important de la réflexion autour des outils et des démarches initiées en Amérique du Nord (Barrett, 2010), (Tochon 2006), (Goupil, 1998), (Bloom et Bacon, 1995), (Barton et Collins, 1993), (Bird, 1990). Ainsi, la Première Conférence Internationale Francophone sur l’ePortfolio, au Québec en 2006, a permis de rassembler et d’analyser les initiatives en la matière (diffusion du portfolio numérique) mais également de préciser les perspectives nouvelles en milieux scolaires et universitaires dans différents pays (Karsenti et al., 2006), (Cerisier, 2006). Le portfolio numérique constitue au final une opportunité originale et les différentes initiatives qui se sont développées depuis 2004/2005 dans le réseau des IUFM en France illustrent cette prise de conscience de la part des formateurs d’enseignants et l’évolution des pratiques de formation et d’évaluation. En prenant en compte les interactions qu’ils offrent, quels que soient les degrés de développement en fonction des établissements, ces ePortfolios proposent le plus souvent une approche articulant évaluation et formation. Concernant la France et les instituts universitaires de formation des maîtres (IUFM), un premier retour d’expérience concernant le dossier « portfolio numérique dans la formation » a permis, dès 20052, de dresser un état des lieux des différentes initiatives, de distinguer les apports et les limites des objets existants ainsi que les freins et les leviers permettant la mise en place d'un portfolio numérique. L’objectif final était de constituer un cahier des charges d’un ePortfolio, adapté en particulier au contexte de certification du C2i®niveau 2 "enseignant". L’IUFM de Champagne Ardenne (IUFM CA) a été pionnier en la matière en développant un dispositif technique et d’accompagnement pour l’élaboration et le suivi des différents parcours de formation, pour le C2i®2e, mais également pour l’évaluation des autres compétences définies dans le cahier des charges de la formation des enseignants et entrant dans le processus de titularisation des enseignants (arrêté du 19 décembre 2006 et les « 10 compétences professionnelles » actualisées dans le Bulletin officiel n° 29 du 22 juillet 2010). Il est évident que le développement d’infrastructures et de dispositifs au niveau local répond à un certain nombre d’injonctions et repose en premier lieu sur des cadres institutionnels communs existants : référentiels nationaux, éléments de certification, préconisations générales... Toutefois, une approche complémentaire consiste à prendre en compte rapidement les retours et requêtes des principaux utilisateurs (stagiaires et formateurs) et implique la mise en place de commissions spécialisées, mais également d’une gouvernance de l’évaluation des formations dispensées. Dans cette perspective, l’observatoire des formations de l’IUFM CA produit depuis quelques années nombre de données et de travaux de recherche qui permettent d’avoir le recul et les indicateurs nécessaires à l’analyse de l’évolution des usages et des représentations des différents acteurs locaux. Les termes « usages » et « représentations » sont utilisés ici dans leur acception courante sans référence spécifique pour le premier à la sociologie des usages et pour le second aux différents aspects des représentations : mentales, sociales.... Les usages sont donc des « observables » qui nous permettent d’accéder à certaines dimensions des pratiques professionnelles (Robert, 1999) telles que définies au paragraphe 3.1. L’enquête réalisée chaque année auprès des formateurs et des enseignants stagiaires vise à réguler la formation et s’inscrit « dans une logique de pilotage de l’établissement ». Elle porte non seulement sur le ePorfolio des étudiants-stagiaires nommé Carnet de Bord Informatisé (CBI) à l’IUFM CA, objet de cet article, mais également sur d’autres dispositifs de formation tels que l’écrit professionnel, les formations individualisées en partenariat... Si l’introduction du CBI suscite des réactions contrastées chez les formateurs, notre étude vise à mesurer les effets objectifs et quantifiés d’un tel dispositif sur les pratiques de formation. Cette étude concerne les dispositifs de formation des professeurs stagiaires antérieurs à la mise en place de la réforme dite de la masterisation. Elle contribue ainsi à un bilan des usages du ePortfolio à ce moment charnière. Nous commencerons donc par présenter les contextes de développement du portfolio au sein de la formation professionnelle des enseignants, puis le fonctionnement spécifique du CBI. Après avoir décrit le processus d’élaboration et d’incrémentation du CBI ainsi que le protocole de passation de l’enquête de l’observatoire des formations sur lesquels nous basons notre recueil de données, nous préciserons les cadres théoriques convoqués pour appréhender au mieux notre questionnement. Nous terminerons en présentant les différents types d’analyses que nous avons croisées, les conclusions que nous en tirons et les perspectives de développement à venir. 2. Des conceptions ouvertes du portfolio adaptées aux contextes locaux et internationaux2.1. Quels portfolios pour la formation professionnelle à l’enseignement ?Les démarches en France en vue de transformer l’accompagnement et la formation des enseignants résultent à la fois d’initiatives et d’expérimentations locales au sein des différents IUFM, mais également de la volonté d’une réflexion commune nationale mise en place par la CDIUFM et la SDTICE3 depuis quelques années. Plusieurs manifestations ont ainsi permis de rassembler les différents travaux et retours d’expériences, à l’exemple de la première du genre à Dijon en 2005 (voir plus haut2). Ce processus de mutualisation et de collaboration vise également à prendre en compte le contexte extrêmement évolutif de la formation dont le processus s’est emballé ces quatre dernières années : adossement aux référentiels de compétences (C2i®2e, « 10 compétences » métier...), intégration des IUFM aux universités, réforme en cours de la masterisation... Ainsi, les interlocuteurs institutionnels ont souhaité favoriser une mobilisation des directions et des personnels des IUFM en soulignant « les enjeux d’une mutualisation de leurs forces pour outiller l’évaluation et la validation des compétences » (Séminaire Montpellier, 20084) et en mettant en place les conditions d’une réflexion pédagogique partagée et approfondie : « Si la réflexion entamée depuis quelques années par rapport au C2i®2e a déjà posé quelques jalons quant à la nécessité d’accompagner les formateurs dans ces nouvelles pratiques et introduit des outils de capitalisation tels que portfolio, ePortfolio, livret de compétences,..., une réflexion plus approfondie se révèle indispensable du fait de l’entrée généralisée par compétences qu’impose le cahier des charges » (Séminaire Montpellier, 2008). Les résultats d’une enquête nationale, lancée en février 2008 (SDTICE) et centrée sur l’« accompagnement des formateurs pour l’appropriation d’outils numériques d’évaluation et de validation de compétences », montrent que la presque totalité des IUFM a mis en place un outil numérique pour la formation, l’évaluation ou la validation des compétences des enseignants-stagiaires (Bertrand et Lameul, 2008). On note que le terme d’ePortfolio n’est pas systématisé soit parce qu’il est remplacé par une dénomination adaptée aux développements spécifiques locaux (livret de compétence, dossier numérique, carnet de bord...), soit parce que le dispositif correspond principalement à l’utilisation d’espaces de mutualisation ou de travail collaboratif utilisés dans d’autres contextes, mais quelquefois également à une fonctionnalité spécifique ajoutée à une plateforme déjà en place (BSCW, Ganesha, OnlineFormatPro, Claroline, Dokeos, QuickPlace, Moodle, Tutelec...). Des dispositifs hybrides de formation et de certification peuvent également être mis en place sur la base d’un Environnement Numérique de Formation (ENF) sans que l’on évoque expressément la notion d’ePortfolio ; on peut citer, par exemple, le cas de la certification C2i® niveau 2 « enseignant » dans le cadre de la formation des enseignants des premier et second degrés de Lorraine (Charpille et Counil, 2010). Comme nous l’avons déjà souligné, les dispositifs développés dans les IUFM sont multiples et répondent le plus souvent à des attentes et à des contraintes locales, à la spécificité des plans de formation voire des outils tels que les Espace Numériques de Travail (ENT) déjà en place. Ainsi, l’IUFM de Grenoble a souhaité développer dès 2005 un outil entièrement numérique. Appelé initialement « portfolio dossier d’évaluation » et intégré au portail de l’institution, il tire parti des outils de workflow, développant également une dimension « présentation » (vitrine) proche de certaines orientations caractérisant les ePortfolios. D’autres organismes de formation ont réfléchi aux objectifs pédagogiques et de communication visés par un système de type ePortfolio et ont mis en place très tôt un cahier des charges et des systèmes numériques adaptés. C’est le cas de l’École Nationale de Formation Agronomique (ENFA) qui a développé il y a quelques années, pour des publics ciblés (formation des professeurs de technologie informatique et multimédia par exemple), un ePortfolio intégré à une plateforme de travail collaboratif (Barreau et al., 2004). En 2011, l'outil ePortfolio a été généralisé à « l'ensemble des sections de stagiaires à l'ENFA pour leur formation et pour la certification du C2i C2i®2e ». L’IUFM de Toulouse s’est également inspiré de ce portfolio numérique opensource afin de réaliser son propre dispositif. D’autres initiatives récentes ont vu le jour à l’exemple du Lorfolio, visant cette fois à valoriser la nature et le niveau des compétences des actifs dans une perspective d’employabilité et de mobilité (outil personnel de capitalisation, de réflexion) ; il s’agit plus précisément « d’une expérimentation sociale qui fait le pari d’une organisation en mode projet intégrant les résultats issus du protocole de recherche qui l’accompagne » (Cherqui-Houot et al., 2010). Au-delà de la simple prise en main et de l’appropriation des outils techniques d’accompagnement et d’évaluation, et même si la multiplicité des outils et des espaces numériques de travail constitue une difficulté pour certains formateurs (« désorientation des formateurs » et « frein à leur engagement »), l'utilisation de l’ePortfolio est présentée comme élément du processus de formation. D’autres actions visent à proposer également un « accompagnement dans la production de ressources numériques et/ou de scénarios ». Au final, ce qui différencie les démarches et actions développées au sein des institutions locales est la priorité donnée à cette appropriation des outils qui, selon les IUFM, est considérée comme un « complément ou préalable aux autres entrées » (Bertrand et Lameul, 2008). Même si le lien avec la notion de portfolio n’est pas clairement identifié dans la représentation des enseignants et des responsables interrogés, on peut souligner également que « la construction de compétences s’appuie sur un parcours d’écriture ». La construction même d’un « processfolio » au sens de Bélair (Bélair 2002), (Bélair et Lebel, 2004) au-delà d’un portefeuille de compétences, ne met-elle pas en jeu justement les processus de production et de sélection des documents, d’interprétation des traces déposées, « d’élaboration de l’écriture dans la durée », processus qui s’articulent également avec la confrontation avec les pairs, avec les formateurs ? Rappelons que la notion de portfolio n’est pas récente et tire son origine dans les domaines de l’art et de l’architecture. Dans le cadre de la formation des enseignants, la place croissante du développement et de l’analyse des compétences professionnelles ainsi que l’enrichissement des pratiques d’évaluation, en particulier celles qui associent formation et certification, ont amené à privilégier l’usage de portfolios au sein des programmes de formation. Comme le souligne le préambule d’un des symposiums d’un colloque de l’ADMEE (20055), l’outil portfolio « apparaît être un moyen privilégié pour évaluer des compétences complexes et pour promouvoir une évaluation authentique qui considère la nature contextualisée et distribuée du fonctionnement cognitif et des apprentissages (Allal et al., 1998) ». Toutefois, l’absence de standardisation (détermination des caractéristiques communes, niveau de personnalisation de l’outil, critères d’évaluation des compétences, des traces d’activités produites...) ou au contraire les limites d’un développement trop unifié et structuré constituent un sujet récurrent de la réflexion issue des travaux visant à définir les finalités et la structure d’un « portfolio de l’enseignant » (Barton et Collins, 1993), (Doolitle, 1994), (Goupil, 1998), (Baron et Bruillard, 2003), (Bruillard, 2004), (Dévé et al., 2009). Bruillard (Bruillard, 2004) souligne le risque d’uniformisation et de perte de la créativité d’expression propre aux portfolios ; il rappelle également que dans le contexte français « la fertilité́ du concept de ePortfolio tient pour une bonne part à sa malléabilité, rendant essentielle sa définition locale dans un contexte donné ». Différents objectifs liés à l’artefact sont ainsi pointés en relation avec la dimension réflexive (notion de « praticiens réflexifs » (Schön, 1994)) qui occupe une place prépondérante dans la formation des futurs professionnels de l’enseignement. Le portfolio semble pouvoir ainsi (colloque ADMEE, 2005)... : - favoriser les « prises de conscience de l’émergence de son identité et de la construction de ses compétences professionnelles », - « soutenir le développement de capacités réflexives, métacognitives, critiques et créatrices, de promouvoir un processus d’intégration des savoirs théoriques et pratiques e.g., (Doyon et Desjardins, 2004) », - « articuler les processus régulateurs de l’évaluation formative aux exigences de l’évaluation certificative e.g., (Vanhulle et Schillings, 2004) ». Afin de distinguer, les dispositifs développés ces dernières années, les travaux de Bélair (Bélair, 2002), (Bélair et Lebel, 2004) permettent de souligner diverses conceptions du portfolio (numérique ou non) en lien avec la nature du dispositif, avec son application ou bien encore avec la prise en compte des traces, des co-évaluations et des autoévaluations... Elle distingue ainsi quatre types principaux de portfolios (Baillat et al., 2007) : • le dossier d’apprentissage dont la principale caractéristique est d’apporter une vision globale des travaux réalisés par les étudiants ; • le portfolio professionnel qui témoigne d’une approche duale : présenter un cumul des travaux réalisés d’une part et montrer par des analyses réflexives la distanciation prise avec ces travaux d’autre part ; • le portefeuille de compétences qui est constitué d’un curriculum vitae, mais apporte aussi des preuves des compétences décrites sous forme de travaux ainsi que tout document dans un but d’employabilité ou de reconnaissance qualifiante (validation des acquis de l’expérience) ; • le processfolio ou dossier progressif défini par la chercheuse comme étant un portfolio où le processus d’élaboration est aussi important que l’objet lui-même. C’est avant tout un portfolio de formation et c’est essentiellement sur ce concept que repose le développement du portfolio numérique à l’IUFM de Champagne Ardenne. 2.2. Un développement adapté d’ePortfolio : le carnet de bord informatisé (CBI)L’IUFM Champagne Ardenne a été un précurseur en développant dès 2005 avec des stagiaires volontaires, dans le cadre de l’expérimentation Certificat Informatique et Internet niveau deux « enseignant » (C2i®2e), un outil spécifique pour le suivi et l’évaluation des parcours : le « Carnet de Bord Informatique » (Connan et Vincent, 2010). Il s’est agi à la fois de répondre à une demande nationale visant à garantir une évaluation et une certification adaptées au référentiel et d’articuler la construction des compétences des stagiaires (individualisation de la formation) à un collectif de formateurs contribuant au parcours de formation, à l’IUFM et sur les terrains de stages. Suite à cette première année d’expérimentation nationale, l’étude confiée au CREAD (Centre de Recherches sur l'Éducation, les Apprentissages et la Didactique) (Loisy, 2006) insiste sur l’importance du portfolio numérique qui semble particulièrement adapté à la complexité de l’évaluation des compétences C2i®2e. L’outil « permet de réfléchir sur le soi apprenant et de réguler l’apprentissage par le choix des travaux que l’apprenant y met comme représentatifs d’un apprentissage spécifique et par la possibilité qui lui est offerte de revenir sur ses apprentissages. Il peut être aussi un outil de communication en direction de personnes externes et servir de support à une évaluation externe » (Loisy, 2006). 2006-2007 a permis l’extension du dispositif à l’ensemble du plan de formation, avec une expérimentation globale pour un groupe de professeurs des écoles stagiaires d’un des sites de formation (Baillat et al., 2007), (Emprin et Lagrange, 2007). L’Institution, sur la base des propositions d’un comité de pilotage, a généralisé l’usage du CBI pour l’ensemble de la formation de l’IUFM Champagne-Ardenne à la rentrée 2007-2008 en prenant en compte le cahier des charges de la formation des enseignants. 2.3. Fonctionnement du CBILors de la première connexion au CBI, le stagiaire sélectionne son formateur référent dans la liste déroulante proposée, mais également les référentiels de compétences (C2i®2e, Métier...) ainsi que sa filière (Professeur des écoles, Professeur des lycées collèges discipline mathématiques...). 2.3.1. Dépôt d’une trace d’activitéEn complétant la fenêtre de dépôt (démarche équivalente à celle de la mutualisation indexée de documents numériques sur une plateforme spécialisée), le stagiaire doit effectuer une brève description de l’activité et cocher les autres éléments de discrimination (discipline, cycle...). Un fichier peut être joint à l’activité de manière simple à partir du bouton « Parcourir ». De nombreux formats sont acceptés, mais lorsque plusieurs fichiers sont joints, il est nécessaire de les compresser dans un dossier unique. Par défaut, le « référent » (formateur désigné pour encadrer et accompagner un parcours donné) sera informé de chacun des dépôts effectués par l’étudiant ou le stagiaire (notification automatique par courriel), même s’il n’est pas celui désigné pour l’évaluation. Une liste déroulante permet par la suite de choisir le formateur appelé à évaluer un dépôt précis. La grille « Formation PE » est associée à la filière du stagiaire (Figure 1) ; on pourrait trouver PLC, PLP, PLC documentalistes ou CPE et la réforme « Master » a modifié en 2010-11 l’ensemble de ces appellations. La grille C2i®2e est également affichée sur cette page (Figure 1). Une même activité peut donner lieu à des évaluations dans les deux référentiels de compétences, éventuellement par des formateurs différents. Il convient en effet de choisir un formateur susceptible d’évaluer l’activité décrite dans le cadre de la formation. Enfin, le stagiaire sélectionne les compétences professionnelles qu’il pense mettre en valeur dans l’activité décrite, éventuellement celles concernées par le C2i®2e.

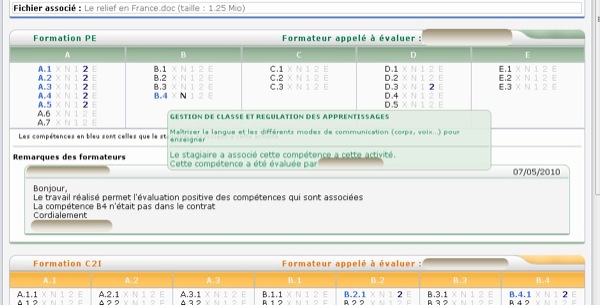

Figure 1 Compétences à évaluer

Lors de la validation de l’envoi, le fichier joint est envoyé sur le serveur et le ou les formateurs sélectionnés reçoivent un courrier électronique automatique comportant une synthèse des informations. Dans ce message est inclus un lien permettant d’aller directement sur la page CBI du stagiaire. 2.3.2. Évaluation des activités.Lorsque le formateur accède à une activité déposée dans le CBI, il ouvre une fenêtre proche de celle du stagiaire, mais où les zones modifiables ne sont pas les mêmes. Ainsi, il identifie les validations demandées par le stagiaire qui apparaissent en couleur bleue et il peut cocher les compétences qu’il considère comme acquises (qu’elles soient ou non présélectionnées par le stagiaire). Il ajoute ses remarques et peut consulter, s’il y en a, les remarques des autres formateurs. Il peut, comme le stagiaire, joindre un fichier à ses conseils. Le stagiaire reçoit alors un courriel lui indiquant qu’une remarque a été ajoutée à son CBI. Les tableaux de compétences (Figure 2) auxquels ont accès le stagiaire et les formateurs indiquent pour chaque activité les compétences qui ont été évaluées. Ces tableaux ne peuvent pas être modifiés directement, il s’agit de récapitulatifs des activités et des évaluations obtenues par le stagiaire.

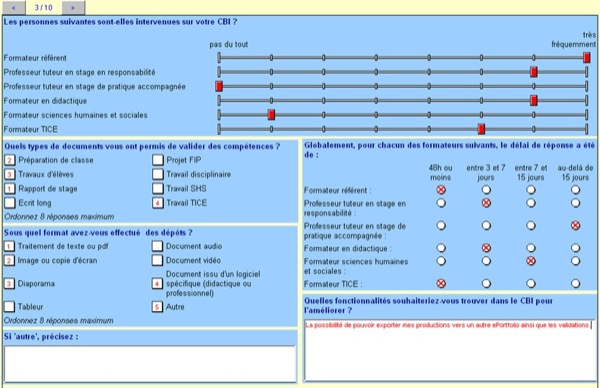

Figure 2 Tableaux de compétences Chaque tableau offre une vue synthétique pour aider le stagiaire, avec le concours de son tuteur, à orienter ses travaux vers l’acquisition de compétences présentant une faiblesse. La ligne « Proposition de l’équipe pédagogique » ne peut être complétée que par le formateur référent après consultation de l’équipe pédagogique. C’est cette ligne qui récapitule les compétences validées. 2.4. Les enquêtes de l’observatoire des formationsLes questionnaires « stagiaire » et « formateur » sont passés en ligne (Figure 3) de manière captive à l’IUFM pour les stagiaires, ce qui assure un taux de réponse de l’ordre de 95 % chaque année, et de manière libre pour les formateurs. Ils comportent des questions à choix unique, à choix multiple, des questions échelles et des réponses ouvertes. Les réponses sont collectées et traitées au moyen du logiciel Sphinx©6 puis analysées et interprétées de manière à réguler les dispositifs de formation. Ils servent également à alimenter des travaux de recherche.

Figure 3 Exemple de page du questionnaire de l’observatoire des formations Le questionnaire formateur comporte 45 questions réparties comme suit : 5 questions sociologiques. 24 questions sur le CBI ; 6 questions sur l’écrit professionnel ; 10 questions sur le formateur référent ; Le questionnaire stagiaire comporte 108 questions réparties comme suit : 11 questions sociologiques ; 34 questions sur le CBI 5 questions sur l’écrit professionnel ; 16 questions sur la formation en partenariat ; 10 questions sur le formateur référent ; 32 questions sur la formation en Science Humaines et Sociales (SHS). Nous ne détaillons pas ici les dispositifs de formation concernés par l’enquête et nous nous centrons sur le CBI. 3. Cadre théorique et problématique3.1. Cadre théorique : l’approche instrumentaleNous observons l’introduction du CBI dans la formation professionnelle à l’IUFM et son impact potentiel non seulement sur les dimensions évaluatives et formatives, mais aussi sur les usages spécifiques générés par chaque utilisateur ou groupe d’utilisateurs. L’approche instrumentale (Rabardel, 1995), (Rabardel, 1999) est un cadre théorique adapté à l’analyse de la façon dont les formateurs construisent l’instrument CBI. En effet, l’instrument est constitué d’un artefact : l’objet et des usages construits de façon personnelle ou sociale. Cette approche permet d’identifier et d’analyser le processus de genèse instrumentale au travers d’un double processus : l’instrumentalisation par laquelle l’individu s’approprie l’artefact en créant des usages (des schèmes d’utilisation et des schèmes sociaux d’utilisation (Rabardel, 1995)) et l’instrumentation, où l’utilisateur se confronte aux contraintes de l’artefact et adapte alors ses schèmes. Ce cadre a été notamment développé et spécifié dans de nombreux travaux de didactique des mathématiques (Abboud-Blanchard et Emprin, 2010), (Artigue, 2002), (Emprin, 2010), (Trouche, 2005) pour analyser l’appropriation par les élèves d’un artefact telle que la calculatrice symbolique. Ce cadre théorique mis en œuvre dans notre problématique doit tenir compte du fait que les usages liés au CBI ne peuvent être appréhendés que sur la durée d’une année scolaire. En effet, le processus de formation / certification qu’il accompagne et encadre se déroule de septembre à juin. Ce temps long nous impose, si l’on veut regarder le processus de genèse instrumentale, de travailler sur la population des formateurs qui utilisent le CBI depuis deux ou trois années complètes et non sur celle des stagiaires pour lesquels l’usage est limité à un an. Cette spécificité du CBI et la dimension collective de la construction des schèmes sociaux d’utilisation dans l’approche instrumentale nous amènent donc à regarder la construction de l’instrument CBI chez les formateurs. Cette centration sur le formateur n’exclut toutefois pas de nous intéresser à la population des stagiaires voire même à l’évolution de leurs usages, mais alors comme indicateur de l’évolution des usages des formateurs. Précisons à présent les questions spécifiques auxquelles nous nous intéressons. La double approche (Robert, 1999), (Robert et al., 2007) est un cadre théorique alliant didactique des mathématiques et ergonomie cognitive. Nous adaptons ce cadre pour définir notre objet d’étude : les pratiques enseignantes et les pratiques de formation. Notre définition des « pratiques » est empruntée à la double approche (Emprin, 2010), (Robert, 1999), (Robert et al., 2007). Dans la double approche, les pratiques sont vues comme la recomposition de plusieurs dimensions ce qui permet de mieux appréhender leurs complexités : « Nos analyses se font à partir de séances en classe en distinguant ainsi des composantes, institutionnelle, sociale, personnelle, médiative (liée aux déroulements en classe et aux improvisations), cognitive (liées aux contenus préparés et aux prévisions de gestion), étroitement liées pour un enseignant donné, et devant être recomposées : il nous faut penser les composantes ensemble, et deviner les compensations, les équilibres, les compromis pour comprendre et commencer à expliquer ce qui est en jeu. » (Robert et al., 2007). Dans cette approche, l’activité est un observable ce qui la distingue de la définition de la psychologie du travail (Folcher, 2005), (Rabardel, 2005). Ainsi notre travail d’analyse des usages du CBI tenant compte à la fois des interactions entre les utilisateurs et le dispositif (approche « ergonomie cognitive ») et les contenus de formation (approche dérivée de la didactique) nous permet d’aborder certaines composantes des pratiques de formation au sens de la double approche. 3.2. Questionnement et données recueilliesL'artefact CBI n'est pas neutre ; il est conçu sur la base des référentiels de compétences. Nous nous intéressons aux genèses instrumentales des formateurs qui interrogent et modifient leurs pratiques de formation et d'évaluation. Notre étude vise donc à analyser une partie de ces évolutions basées sur des traces de l'activité des formateurs. Dans un premier temps, nous interrogeons la culture communicationnelle mise en place autour de l'évaluation formative et certificative. Nous cherchons à identifier quels sont par ailleurs les facteurs déterminants dans la construction collective de l'instrument : la discipline enseignée, le site de formation ? Dans un second temps, nous étudierons les déclarations des formateurs sur leur perception de l’artefact. Quelle est l'évolution de cette perception au travers des enquêtes annuelles de l'observatoire des formations ? Pour répondre à ces questions, deux types de données sont à notre disposition : quantitatives et qualitatives extraites du carnet de bord lui-même et issues d’enquêtes auprès des formateurs et des stagiaires. Des extractions sont effectuées à partir du CBI, c'est-à-dire que nous récupérons des informations exhaustives sur les dépôts effectués et les compétences évaluées. Nous avons ainsi compilé toutes les remarques formatives écrites par les formateurs (cartouche « Remarques des formateurs » de la Figure 1). Cela représente 6823 remarques exploitables sur un total de 12255, en enlevant les écrits ne contenant que des formules de politesse et les remarques vides. Ces écrits peuvent être indexés en fonction de la discipline du dépôt (douze disciplines représentées) ainsi que du site de formation du stagiaire (cinq sites pour l’IUFM CA). La masse de ces données impose un traitement statistique. Nous disposons de quatre années d’extractions : 2006-2007, 2007-2008, 2008-2009 et 2009-2010. Les questionnaires de l’observatoire des formations sont une seconde source de données. En 2006-2007 nous avons réalisé un questionnaire, en parallèle à celui de l’observatoire, pour les formateurs ayant participé à l’expérimentation. Les années suivantes, l’observatoire a mené une réflexion spécifique sur l’usage du CBI tant pour les formateurs que pour les stagiaires. Nous disposons donc de deux types de données : les réponses des formateurs qui donnent leur avis sur l’utilisation du CBI et les réponses des stagiaires qui évaluent la manière dont ils ont été formés avec le CBI. Le premier questionnaire permet de détecter des évolutions de pratiques en émettant l’hypothèse que ce sont majoritairement les mêmes formateurs qui répondent aux questions chaque année. Pour le second questionnaire, celui auquel répondent les étudiants, l’analyse est moins directe dans la mesure où les stagiaires sont différents tous les ans. Notre analyse se base donc sur l’idée qu’une évolution des réponses entre deux années peut être révélatrice d’une évolution dans les usages des formateurs. Les nombres de formateurs et de stagiaires ayant complété l’enquête sont représentés dans le tableau 1 ci-dessous.

Tableau 1 • Effectifs de répondants à l’enquête de l’observatoire des formations de 2007 à 2010 Si le nombre d’étudiants ayant répondu au questionnaire est comparable sur les trois années 2008, 2009 et 2010 il n’en est pas de même pour les formateurs. Le trop faible nombre de répondants en 2007 et 2010 nous invite donc à exclure ces deux questionnaires « observatoire des formations » de notre analyse pour ne pas introduire de biais dans notre analyse. 4. Analyse des donnéesLes auteurs de cet article font à la fois partie de l’observatoire des formations et du groupe de pilotage du CBI (créé lors de l’introduction du CBI). Il nous a donc semblé important de croiser un certain nombre d’analyses basées sur des données quantitatives issues de plusieurs sources pour objectiver notre point de vue. 4.1. À partir des extractions du CBICette analyse ne porte que sur la partie du CBI utilisée pour la formation et l’évaluation des professeurs des écoles. Elle ne tient pas compte du travail fourni pour l’obtention du C2i®2e. Les premiers éléments que nous avons analysés sont les évolutions les plus flagrantes des pratiques d’évaluation et de formation induites par l’introduction du CBI. Précisons d’abord que le carnet de bord utilise un référentiel de « formation » de vingt-deux compétences construit par l’IUFM CA et non pas directement le référentiel de dix compétences « métier » national. La première de ces évolutions est apparue lors de l’expérimentation locale et s’est amplifiée lors de la généralisation : il s’agit de la nécessité de construire des contrats de validation, des critères et des indicateurs d’acquisition des compétences qui soient uniformisés. Ce travail s’est accompagné d’une autre nécessité, celle de faire le deuil de la vérification de l’acquisition de toutes les compétences dans toutes les disciplines comme c’était l’usage jusqu’alors. Cela s’est traduit concrètement par la construction d’un cadrage qui définit le nombre de fois où chaque compétence doit être évaluée positivement ainsi que les cadres dans lesquels elle doit ou peut être évaluée. Par exemple, la compétence renvoyant à la conception d’une planification des apprentissages doit être vue une fois en mathématiques ou en français, une fois dans une autre discipline et une fois au travers des rapports de visites lors des stages en responsabilité. Il n’y a néanmoins aucun automatisme dans la validation des compétences professionnelles et chaque cas est étudié individuellement ; le non-respect du contrat entraîne toutefois un examen plus approfondi du parcours du stagiaire par l’ensemble des formateurs. La mise en place d’un tel contrat est permise par le CBI qui compile l’ensemble des travaux et des évaluations du stagiaire. Elle rend en particulier visible en temps réel le parcours du stagiaire pour le formateur chargé de son suivi (« référent ») et c’est d’ailleurs cette visibilité du travail du stagiaire qui a provoqué la seconde évolution des pratiques. En effet, la question qui s’est posée est celle de la visibilité des dépôts. Lors de la première expérimentation, tous les formateurs avaient accès à tous les dépôts ainsi qu’aux commentaires de leurs collègues. Les stagiaires, quant à eux, ne voyaient que leurs documents. Cette question est apparue problématique lors de la généralisation du dispositif en 2007-2008. Plusieurs formateurs se sont élevés contre cette possibilité qu’avait tout formateur de consulter les évaluations et conseils donnés par ses collègues, éventuellement même dans d’autres disciplines. Plusieurs solutions ont été évoquées allant de la conservation d’un système entièrement ouvert à une confidentialité totale (dans la relation duale stagiaires – formateur) des travaux et de leur évaluation. Une solution satisfaisante a été trouvée en 2008-2009 par le groupe de pilotage du CBI. Il s’agit d’une visibilité sélective : les formateurs d’une filière voient tous les travaux de leur filière (par exemple les PE2 de Troyes), et tous les autres formateurs ne voient que les travaux déposés à leur intention. Là où il semble acceptable qu’un collègue que l’on croise régulièrement puisse voir nos critères d’évaluation des stagiaires, cela semble moins évident lorsqu’il s’agit d’un collègue travaillant dans un autre site ou dans une autre filière de formation. De fait, ceci nous montre l’importance du site de formation et de la filière dans la construction des pratiques collectives de formation et d’évaluation. Ainsi le CBI amène les formateurs à questionner leurs pratiques de formation au travers des modalités d’évaluation. La dimension médiative des pratiques de formation peut être observée au travers du CBI. Cette approche est d’abord quantitative : nous nous sommes demandé si la quantité de dépôts, c'est-à-dire la densité des échanges sur les CBI, évoluait au fil du temps. Le nombre moyen de dépôts par stagiaire augmente effectivement d’année en année : en 2006-2007, il y avait, en moyenne, 9,2 dépôts par stagiaire ; en 2007-2008 : 15,6 ; en 2008-2009 : 19,9 et en 2009-2010 : 20,9. Une analyse de la nature des dépôts montre que cette augmentation relève de deux facteurs : de moins en moins de dispositifs de formation échappent au CBI et il y a de plus en plus d’aller-retour entre les formateurs et les stagiaires. Dans les deux cas, l’augmentation des échanges est révélatrice d’une plus grande appropriation de l’artefact CBI par les formateurs. Nous avons cherché à analyser par ailleurs si certains facteurs étaient déterminants dans l’évolution de ces pratiques. À dessein, nous avons étudié les différences entre les sites de formation. Le tableau 2, ci-dessous, montre l’évolution du nombre de travaux moyens par stagiaire dans les différents sites :

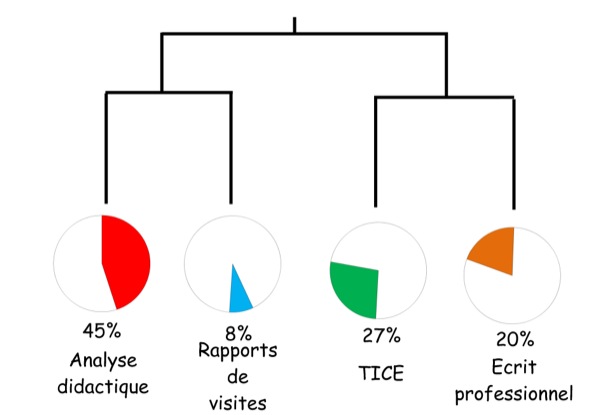

Tableau 2 • Nombre de dépôts moyen par stagiaire en fonction des sites de formation. Ce tableau montre une grande disparité entre les sites de formation tant du point de vue quantitatif (13,3 travaux par stagiaires en 2007-2008 pour le site 4 contre 19,5 pour le site 1) que sur l’évolution du nombre de travaux puisque l’on observe des stagnations en 2009-2010 pour les sites 1 et 4, une régression pour le site 5 et une augmentation pour le site 2. À noter d’une part que l’année 2006-2007 n’est pas indiquée dans la mesure où l’expérimentation ne concernait qu’un seul site et d’autre part que les effectifs des sites sont très différents, ce qui explique que le nombre de dépôts moyen par stagiaire au niveau de l’IUFM puisse augmenter alors que la plupart des sites sont en régression. Ces disparités ont fait l’objet d’entretiens avec les enseignants qui pilotent les équipes sur place et ont permis de mettre à jour des pratiques locales : les formateurs du site 2 demandaient en 2007-2008 et 2008-2009 que les dépôts se fassent par mail ou papier ; ils échangeaient avec les stagiaires et ne leur demandaient de déposer dans le CBI qu’une fois le travail abouti. Cette pratique montre des genèses instrumentales du CBI essentiellement orientées du côté de l’évaluation visant à la certification des compétences. Il semble que, lors de la dernière année d’expérimentation, cette pratique ait été abandonnée. Les pratiques se constituent-elles également en fonction des équipes disciplinaires ? Les disciplines demandant le plus de dépôts par stagiaire en moyenne sont le français et les mathématiques puis l’histoire géographie et les TICE ; ensuite viennent les Sciences de la Vie et de la Terre (SVT) et les Arts (visuels, plastiques et l’éducation musicale). Cet ordre n’a globalement pas été modifié au cours des trois années. Le nombre de dépôts par stagiaire augmente donc uniformément dans les différentes disciplines qui ne sont donc pas un facteur de construction d’usages particuliers. Le texte des échanges entre les formateurs et les stagiaires est également accessible dans les extractions. Chaque dépôt est affecté nominativement par le stagiaire au formateur qui peut évaluer les compétences visées et rédiger un commentaire. Nous avons utilisé deux niveaux de traitement de ces commentaires. Le premier est une analyse par un logiciel de traitement de données statistiques (Sphinx©) qui nous permet de repérer les données quantitatives significatives. Il apparaît d’abord qu’un nombre non négligeable de dépôts (9,2 %) ne sont pas commentés. Dans les dépôts qui sont commentés, environ ¼ reçoivent un commentaire très court, de moins de 40 caractères. Il apparaît encore une fois une différence entre les sites de formation. Les données sont significatives au niveau de deux sites : celui de l’expérimentation en 2007 présente 77 % d’écrits de plus de 100 caractères et moins de 10 % de moins de 40 caractères contre respectivement 38,5 % et 40,8 % pour le site 2 dans lequel nous avions identifié qu’une partie des échanges se passait en dehors du CBI. Ceci confirme notre première analyse sur les quantités de dépôts. Du point de vue quantitatif, les commentaires évoluent assez peu entre les deux années étudiées ; il en est de même entre les disciplines enseignées. Le deuxième traitement des données a été effectué au moyen d’un logiciel d’analyse textuelle (Alceste7©). Ce logiciel est basé sur l’argument suivant développé par Reinert (Reinert, 1993) : « Pour pouvoir énoncer, le sujet énonçant doit se représenter ce qu'il va dire dans un certain espace mental (qui lui sert de “référence”). Le choix de cet espace référentiel, de ce “lieu” — qui ne dépend pas forcément d'une opération consciente — implique le choix d'un type d'objet : il implique, par là même, un type de vocabulaire. En conséquence, l'étude statistique de la distribution du vocabulaire dans les différents énoncés d'un corpus doit permettre une discrimination de ce vocabulaire révélatrice des différents choix référentiels effectués par l'énonciateur ». Pour le traitement, les commentaires ont été expurgés des formules de politesse et des informations nominatives. Nous avons utilisé les CBI des années 2007-2008 et 2008-2009. Chaque commentaire a été indexé dans le logiciel en fonction de l’année scolaire où il a été effectué et du site de formation concerné de façon à pouvoir identifier si ces facteurs transparaissaient dans l’analyse. Le logiciel Alceste utilise une classification descendante hiérarchique, c'est-à-dire qu’il partitionne le corpus d’abord en deux entités ce qui correspond à répartir les mots dans un tableau à deux colonnes. Cette répartition est représentée par les deux premières branches de l’arborescence reproduite ci-dessous (Figure 4) : « Une fois cette partition obtenue, on peut déplacer à la gauche du tableau les mots relativement plus présents dans la classe 1 et à la droite du tableau les mots les plus présents dans la classe 2. [...] Après ce premier calcul, il est possible de recommencer le même algorithme sur le plus grand des sous-tableaux restants à traiter, après élimination des colonnes presque vides ou liées à des mots très spécifiques de l’autre classe, etc. [...] D’où le nom de la méthode : la Classification Descendante Hiérarchique » (Reinert, 2003). Le logiciel réitère donc l’opération au niveau de chacune des entités et ainsi de suite jusqu’à quinze itérations. En mettant en œuvre cette méthode une deuxième fois, en segmentant le corpus de façon légèrement différente (paramètres du logiciel à spécifier en fonction du corpus traité), le logiciel obtient une autre classification et ne conserve que la partie invariante. Nous obtenons donc une classification stable, ici en quatre classes.

Figure 4 Les classes Alceste pour les commentaires des formateurs. Les deux premières branches de ce diagramme qui séparent les classes 1 et 2 des classes 3 et 4 correspondent donc à deux univers lexicaux opposés, puis à l’intérieur de ces deux univers la classe 1 s’oppose à la classe 2 tout comme la classe 3 s’oppose à la classe 4. Nous pouvons résumer chacune de ces classes par un terme comme dans le schéma suivant (Figure 5). Nous en détaillons ensuite l’analyse.

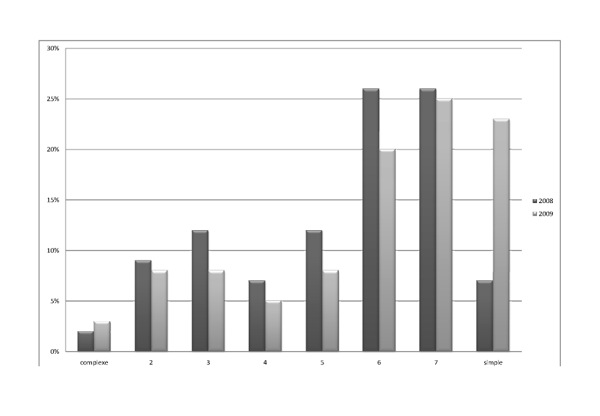

Figure 5 : Analyse et interprétation des classes Alceste, Le premier élément qui ressort par rapport à notre questionnement est que l’année correspondant au commentaire n’apparaît comme significative dans aucune des classes. Il n’y a donc pas, selon cette classification, d’évolution du contenu des commentaires des formateurs sur les deux années. L’analyse du traitement Alceste montre que les types de vocabulaire utilisé correspondent en fait aux quatre grands dispositifs de formation : la formation didactique, les visites en stage, les TICE et l’écrit professionnel. Dans la première classe se trouve le vocabulaire inhérent au conseil sur la préparation des séances et leur analyse didactique. On y retrouve les écrits didactiques en français et en mathématiques. Ce sont des commentaires longs qui renvoient à la dimension formative des travaux d’évaluation dans les différentes disciplines. La deuxième classe correspond aux échanges autour de l’évaluation des rapports de visites ; elle contient des commentaires courts et pragmatiques : « suite à ma visite en stage ». L’opposition de cette classe avec la première par l’absence de dimension formative dans les propos est logique dans la mesure où les échanges font suite à une visite, à un entretien et à un rapport détaillé comprenant déjà cette dimension de conseil et d’analyse. Le commentaire est donc essentiellement formel. La classe 3 regroupe les commentaires liés aux TICE ; on y voit apparaître des termes dédiés tels que « fichier », « FOAD », « mutualisation », « ressources » « informations » ainsi que des listes de compétences du C2i®2e (dépôts effectués à la fois dans le cadre du référentiel métier et de celui du C2i®2e). Les absences significatives sont celles des termes de la classe 1 par exemple « élève » ou « séance » ainsi que celles des adjectifs en général. Il y a donc une véritable singularité. Enfin, la dernière classe regroupe les commentaires liés principalement à l’écrit professionnel en y associant les termes : « réflexion », « théorie », « pratiques » « professionnelles », « expériences », « syntaxe », « besoins » et les compétences liées à « se former et innover ». Elle contient, par rapport aux autres classes, beaucoup d’adjectifs. Il s’agit donc plutôt d’appréciations du travail fourni avec, par exemple, un jugement sur la qualité de la bibliographie, de la syntaxe et de l’orthographe. Nous nous sommes demandé si les compétences évaluées par les formateurs évoluaient au cours des années. En effet, le cadrage des évaluations, c'est-à-dire le contrat de validation que le stagiaire doit remplir (voir § 4.1), fournit un minimum de validations de compétences à obtenir, mais n’impose pas au formateur de se limiter à ces compétences. Nous remarquons que les compétences évaluées sont relativement stables. Néanmoins, certaines disciplines s’approprient l’évaluation de compétences petit à petit comme le français, les mathématiques et les arts qui évaluent la compétence « maîtriser la langue » en 2008 alors qu’elles ne le faisaient pas en 2007. Ainsi l’introduction du CBI induit une réflexion sur les pratiques d’évaluation qui peuvent être influencées par une dimension locale. Les usages évoluent en canalisant de plus en plus les échanges entre les formateurs et les stagiaires. 4.2. Analyse des réponses des stagiaires et des formateursDans ce paragraphe, nous présentons les analyses des enquêtes de l’observatoire des formations. Nous prenons en compte les années 2008, 2009 pour les questionnaires « stagiaires » comme pour les questionnaires « formateurs ». Il y a en effet, comme nous l’avons indiqué dans le tableau 1, des effectifs trop limités de répondants formateurs pour prendre en compte les années 2007 et 2010. Ces effectifs réduits s’expliquent non seulement par l’aspect volontaire de la participation des formateurs au questionnaire (contrairement aux stagiaires), mais également par le fait que 2008 et 2009 constituent les années où le dispositif a fonctionné à plein régime : généralisation en cours en 2007 et perspective de Masterisation en 2010 ce qui incite moins les formateurs à s’impliquer dans une démarche d’analyse de l’outil. L’enquête de l’observatoire des formations nous permet d’identifier chez les formateurs une appropriation technique croissante de l'artefact. La figure 6 montre que le CBI est perçu comme de plus en plus simple à utiliser. Les formateurs répondent sur une échelle de 1 à 8 (1 : complexe ; 8 : simple). En effet, si l’on considère les deux populations suivantes : les formateurs ayant répondu entre 1 et 4 qui pensent que le CBI est plutôt complexe d’utilisation et les formateurs ayant répondu entre 5 et 8 qui pensent que l’utilisation est plutôt simple, on remarque que la première population est en baisse entre 2008 et 2009 (30% en 2008 contre 24% 2009). De plus, parmi ceux qui trouvent le CBI plutôt simple, il y a de plus en plus d’avis très tranchés qui se portent sur la réponse 8 : simple (23% en 2009 contre 7% en 2008). Il reste néanmoins un peu moins d’un quart des formateurs pour lesquels l’artefact reste plutôt complexe.

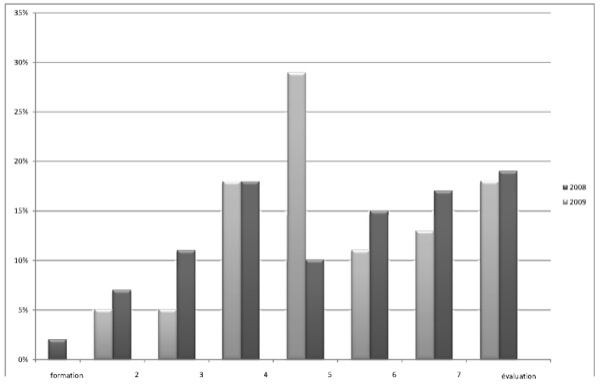

Figure 6 Le CBI est pour vous un outil simple, complexe ? Évolution 2008-2009 pour les formateurs L’introduction du CBI a été faite avec une volonté claire de développer sa dimension formative notamment en l’associant à l’approche par compétence. Développé à l’origine autour des compétences C2i®2e, son utilisation dans la formation générale des enseignants a engendré un travail autour des critères d’évaluation et une centration des échanges autour de questions liées à l’évaluation. Au sein de l’IUFM, il semblait s’être développée une opposition entre fonction évaluative et fonction formative de l’artefact d’où le choix de l’observatoire des formations de demander aux formateurs de positionner l’utilisation du CBI sur une échelle évaluation / formation. En complément de cette question, un champ de réponse libre permettait aux formateurs de préciser en quoi le CBI était un outil d’évaluation ou de formation. Les réponses libres montrent bien l’existence de ce clivage. On peut lire par exemple en quoi est-ce un outil de formation : « Il pourrait être un outil de formation s'il n'était pas utilisé dans notre IUFM comme outil d'évaluation et si les dépôts ne servaient qu'à de l'évaluation formative. », « En rien. », « En rien. Il décourage et agace et fatigue plutôt les stagiaires. », « D'autres outils existent pour la formation. ». Concernant la question en quoi l’outil est-il destiné à l’évaluation, on peut lire par exemple : « C'est sa seule fonction me semble-t-il. », « C'est bien là son problème, car pour les stagiaires il est surtout un outil d'évaluation. », « Par la preuve qu'il fournit de l'acquisition des compétences validées ». Chez les étudiants ne transparaît que très peu la dimension formative comme le montre la figure 7.

Figure 7 Le CBI est-il pour vous un outil d’évaluation ou de formation ? Évolution 2008-2009 : les étudiants En ce qui concerne les formateurs, leurs réponses traduisent sans doute plus des convictions que des usages réels, on remarque en particulier une augmentation des réponses 4 c'est-à-dire à la limite entre évaluation et formation, mais du côté de l’évaluation. Les usages sont clairement orientés vers l'évaluation (Figure 8), mais avec les années, les formateurs font de plus en plus cohabiter les fonctions d’évaluation et de formation. Quoi qu’il en soit, vouloir confronter la dimension formative et évaluative ne va pas sans poser problème. Pour Perrenoud (Perrenoud, 1997) « l’opposition entre le formatif et le certificatif s’atténue dans ce processus, car ce sont en partie les mêmes « observables », les mêmes feed-back qu’on considère, à des stades différents, en sachant qu’à un moment donné [...] l’évaluation sera plutôt certificative ».

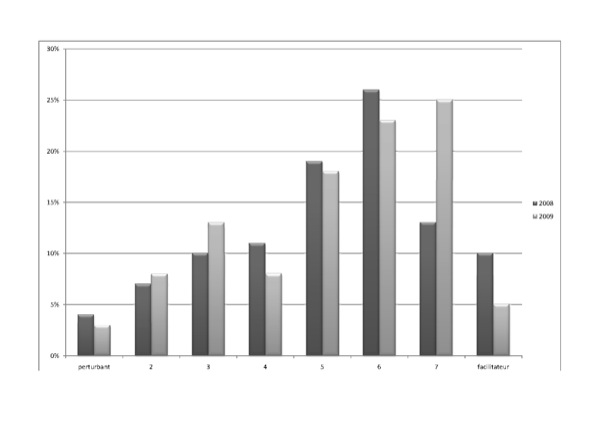

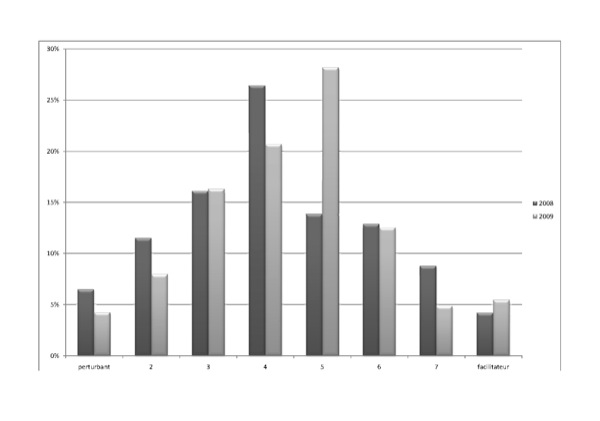

Figure 8 Le CBI est-il pour vous un outil d’évaluation ou de formation ? Évolution 2008-2009 : les formateurs Le CBI est vu comme facilitant les échanges pour 70% des formateurs (Figure 9) ; cette proportion reste stable globalement, mais entre 2008 et 2009 les réponses 7 augmentent notablement ce qui montre que cet aspect s’affirme. Pour les étudiants l’évolution est plus marquée (Figure 10) ; en effet, alors que seulement 40% des stagiaires répondent que le CBI est facilitateur d’échanges en 2008 ils sont un sur deux en 2009. Ces évolutions sont moins marquées que pour d’autres réponses mais nous semblent révélatrices d’une appropriation progressive de l’artefact par les formateurs qui rejaillit sur la perception des stagiaires.

Figure 9 Le CBI et la communication :

facilitateur-perturbant ? Évolution 2008-2009 : les

formateurs Figure 10 Le CBI et la communication : facilitateur-perturbant ? Évolution 2008-2009 : les stagiaires Une autre hypothèse qui pouvait être faite lors de l'introduction d'un artefact informatique est qu'il amènerait des évolutions quant à la nature des dépôts effectués : accroissement de l'utilisation de documents multimédias que les supports traditionnels ne permettaient pas. Dans l’enquête de l’observatoire dont la passation a eu lieu en 2008, il était demandé aux stagiaires d’indiquer le type de travaux déposé parmi les propositions suivantes : préparation de classe, travaux d'élèves, diaporama, document audio, document vidéo, photographie, autre. Les pourcentages de réponses sont reproduits dans le tableau ci-dessous.

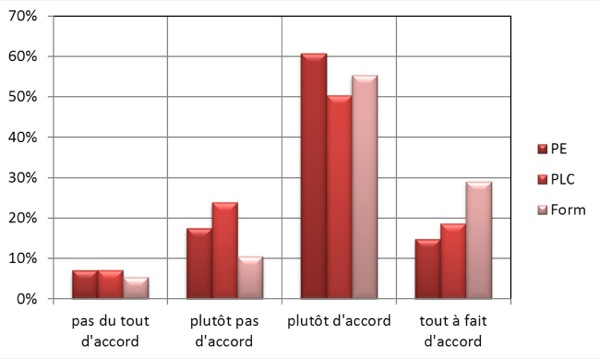

Tableau 3 : Pourcentage de stagiaires ayant déposé les différents types de fichiers en 2008 Cette question avait un défaut important : elle mélangeait les types de travaux et le support ou le format informatique utilisé. Il a donc été décidé en 2009 de découper la question en isolant la dimension multimédia. Les catégories ont été réalisées en analysant les réponses libres faites par les stagiaires de 2008 ayant répondu « autre » : en 2009, 498 stagiaires sur 500 disent avoir déposé du traitement de texte ou des fichiers pdf, 55 % des images ou copies d'écran, 30 % des diaporamas et moins de 10 % d'autres types de documents (tableur, documents audio ou vidéo, etc.). Même si les deux questions peuvent difficilement être mises en relation de par les modifications effectuées, on peut affirmer que l'introduction du CBI n’a pas modifié notablement la nature des travaux demandés malgré les nouvelles possibilités qu’il offre en terme de support multimédia notamment. Les travaux déposés en 2008 ou 2009 n’utilisent que peu les potentialités techniques de la plateforme : vidéo ou audio. Les stagiaires déposent donc essentiellement des documents traitement de texte et pour la moitié environ des images, scans ou copies d’écran (en effet en 2008 on peut considérer que les 50,51% de travaux d’élèves ont été numérisés et qu’ils correspondent en 2009 aux 55% de la catégorie image et copie d’écran). Pour recueillir les opinions des formateurs et des stagiaires sur le CBI, nous les avons laissés, en 2007-2008, formuler des réponses libres. Une analyse textuelle (au moyen du logiciel Alceste) nous a permis de dégager trois classes distinctes dont nous avons extrait les assertions les plus répandues. En 2008-2009, nous avons repris ces opinions en demandant aux formateurs de donner leur degré d'adhésion sur une échelle comportant quatre échelons. Il en ressort que le CBI permet de suivre l’évolution des stagiaires tout au long de la formation. Cet avis n'est pas partagé par les stagiaires. En revanche, c'est un outil reconnu par l'ensemble des acteurs (formateurs et stagiaires PE/PLC) comme un outil puissant permettant d'identifier les compétences professionnelles à développer (Figure 11).

Figure 11 Le CBI oblige les stagiaires à structurer leur travail en relation avec les différentes compétences professionnelles L’artefact CBI recouvre de nombreuses fonctionnalités et son usage s’étend sur une année scolaire complète ce qui induit une analyse assez générale des usages des formateurs. En ce sens, les données que nous avons utilisées, les extractions du CBI et les enquêtes de l’observatoire des formations, sont bien adaptées à la taille de l’artefact. 5. ConclusionsComme cela a été souligné dans de précédentes études, mais sur une période plus courte (Connan et Vincent, 2010), (Baillat et al., 2007), en décalage voire en contradiction avec les analyses récurrentes mettant en avant la « résistance » des enseignants aux changements et même si certaines stratégies d’évitement sont mises en avant dans nos analyses, l’investissement des équipes de formateurs (internes à l’IUFM et en partenariat sur le terrain des stages) ne s’est pas démenti au fil des années. Les dévoiements de l’outil, appelés catachrèses dans l’approche instrumentale, sont particulièrement intéressants, car ils sont révélateurs de la façon dont les formateurs s’approprient malgré tout l’artefact, en l’adaptant à leurs besoins. Les différentes analyses effectuées à partir des données extraites du CBI, des enquêtes et entretiens réalisés confirment et confortent « cette démarche qui dépasse la simple inscription dans une expérimentation d’un outil technologique, mais tend vers l’adhésion à un dispositif de formation centré sur les compétences » (Connan et Vincent, 2010), (Baillat et al., 2007). L’analyse quantitative des échanges, et les réponses des formateurs montrent qu’ils entrent pour la plupart dans une démarche collective de travail par compétences induites par l’artefact. En tant que formateurs et membres du groupe de pilotage du CBI, nous avons pu remarquer qu’il a rendu nécessaire une certaine harmonisation des pratiques d’évaluation tant au niveau des départements disciplinaires qu’au sein des sites de formation. Les cadrages de validation des stagiaires apparus lors de l’expérimentation 2007 ont été généralisés en 2008 en cadrages académiques. La possibilité initiale donnée aux formateurs d’accéder à tous les parcours des stagiaires, de consulter les évaluations de l’ensemble des collègues ainsi que d’insérer plusieurs évaluations pour un même dépôt, représentaient idéalement l’acceptation de « soumettre au regard du pair (et non au seul regard du stagiaire) sa propre compétence » (Baillat et al., 2007). Cela constitue une évolution particulièrement intéressante, même si les conditions d’intervention ont été rectifiées suite aux enquêtes. En effet, le débat sur la confidentialité de l’accès aux données ayant conduit à la réduction de la visibilité des parcours sur le CBI, cela semble limiter l’évolution des pratiques évoquées à une filière de formation. Quant à l’influence de l’introduction du CBI sur les pratiques des formateurs, en particulier sur leur dimension médiative, nous avons montré qu’il canalisait les échanges. Il induit également une augmentation de la quantité d’échanges formalisés, mais ce sont les dispositifs de formation qui induisent la nature de ces échanges. 6. PerspectivesLa masterisation des formations d’enseignants qui a commencé en septembre 2010 a eu pour effet une modification des dispositifs de formation et d’évaluation. Le CBI, tel qu’il existait en 2010, n’était plus adapté à la formation universitaire dispensée dans les Masters Mention Éducation et Formation (MEF) de l’IUFM. La validation des deux années de formation est soumise au cadre national des Diplômes de Master avec une évaluation notée et semestrialisée. Un semestre est acquis si la moyenne des unités d’enseignement le constituant (UE) est supérieure ou égale à 10 ce qui induit des systèmes de compensations entre les notes obtenues dans les différentes évaluations. Ce système d’évaluation chiffré et très contraint au niveau du temps ne va pas dans le sens d’une évaluation basée sur l’initiative de l’étudiant qui doit faire la preuve de l’acquisition de compétences en déposant des travaux dans les CBI. Pourtant la maquette du Master MEF porté par notre IUFM fait état de compétences que la réussite du diplôme permet d’attester. Ces compétences qui figurent sur le supplément au Diplôme reprennent en partie les dix compétences professionnelles attendues d’un enseignant, mais également des compétences complémentaires. Nous avons donc fait le choix de conserver notre carnet de bord informatisé en remplaçant le référentiel de compétences professionnelles des enseignants par celui du Master. Nous avons également offert la possibilité aux formateurs d’attacher à un dépôt de stagiaire une note en plus de l’évaluation des compétences. L’utilisation d’un portfolio est une obligation légale pour certifier du C2i®2e, il a donc été assez naturel de conserver l’artefact dans son intégralité, mais sans aucune obligation d’utilisation ni pour les étudiants ni pour les formateurs. À la fin de cette première année de mise en œuvre du diplôme le bilan de l’utilisation de la partie formation du CBI est assez intéressant et pour le moins révélateur : 4106 travaux ont été déposés par 526 étudiants soit en moyenne 8 travaux par étudiants. 79 formateurs soit quasiment tous les formateurs sont intervenus sur les CBI pour évaluer des travaux. La possibilité d’utiliser l’artefact pour attribuer les notes pour le contrôle des connaissances a également été exploitée : 635 notes figurent dans le CBI (soit un peu plus d’une en moyenne par étudiant). Ces données confirment que l’utilisation d’un portfolio de compétence est entrée dans les usages puisque, sans aucune contrainte, il est largement utilisé. Ainsi l’utilisation du portfolio semble compatible avec la mise en œuvre du diplôme de Master malgré les contraintes liées aux modalités de contrôle des connaissances. Il semble même apporter des solutions potentielles à certaines difficultés spécifiques aux Masters pluri-orientés que nous portons. En effet, le Master MEF doit permettre aux étudiants de passer et de réussir les concours de l’enseignement, mais aussi de s’insérer dans d’autres milieux professionnels en lien avec la formation, l’éducation ou l’enseignement. Dans le cadre de cette insertion professionnelle, le fait de présenter non seulement un diplôme, mais également des « preuves » ou des illustrations de ses compétences serait un atout. Pour cela, et au-delà de sa vocation formative et évaluative initiale (processus d’élaboration de type « processfolio »), le CBI pourrait permettre d’ajouter une dimension de présentation, sorte de CV informatique enrichi dans un but d’employabilité, validé par l’institution. On peut évoquer ici l’exemple de celui de l'Université de Wisconsin-Madison décrit par Tochon (Tochon, 2006) : « Il est par exemple possible pour des stagiaires d’apporter des preuves visuelles de leur compétence et de les rassembler dans un portfolio ou dossier électronique. On peut créer des films de leçons exemplaires et donner une rétroaction vidéo sur l’enseignement des débutants ». Le Master MEF fait également intervenir de nombreuses disciplines et pour éviter la dispersion de ces évaluations disciplinaires le CBI peut constituer de ce fait un réel outil de mutualisation des travaux. La démarche qualité associée à notre Master entraîne une réflexion sur la valeur de l’évaluation et en particulier sur la question du plagiat. Que ce soit de façon délibérée ou par manque de formation, nous sommes confrontés à des cas de plagiat qui sont détectés individuellement par les formateurs appelés à évaluer. Il a donc été décidé de relier, à titre expérimental en 2011, un logiciel anti-plagiat. Ces trois orientations : CV informatique enrichi, mutualisation des évaluations et anti plagiat peuvent inciter les formateurs à continuer à utiliser le CBI et à développer de nouveaux usages. Enfin, à partir de la rentrée 2011, est offerte à certaines universités la possibilité de proposer des parcours de Master en alternance ce qui pose le problème du suivi des étudiants et de la mise en relation entre le terrain et l’université. Le portfolio est là encore une solution comme le précise (Tochon, 2006) en prenant l’exemple du portfolio de l’université de Wisconsin-Madison : « Dans mon programme, nous proposons aux futurs enseignants d’aller enseigner un semestre à l’étranger et nous gardons contact avec les étudiants en visite en Équateur, en France et en Allemagne grâce à un blog où ils affichent leurs cartes postales et leurs commentaires d’expérience, leurs journaux électroniques et un forum de discussion en ligne. La technologie facilite le rapport théorie-pratique ». Même si les terrains de stages en alternance sont beaucoup moins exotiques que ceux décrits ci-dessus, le CBI sera un outil privilégié dans ces parcours de Master. Le CBI peut donc, à condition de continuer à évoluer, devenir un réel outil de professionnalisation et un atout pour les Masters enseignants. RemerciementLes auteurs tiennent à remercier Jean Vincent pour sa précieuse collaboration à la réflexion et à la présentation de ce travail.BIBLIOGRAPHIE - WEBOGRAPHIEABBOUD-BLANCHARD M., EMPRIN F. (2010). Pour mieux comprendre les pratiques des formateurs et de formations TICE. Recherche et Formation, INRP. ABRAMI P.C., BARRETT H. (2005). Directions for Research and Development on Electronic Portfolios, Canadian Journal of Learning and Technology, volume 31 n°3. ALLAL L., WEGMULLER E., BONAITI-DUGERDIL S. et COCHET KAESER F. (1998). Le portfolio dans la dynamique de l’entretien tripartite. Mesure et évaluation en éducation, Vol. 20, p. 5-31. ARTIGUE M. (2002). Learning mathematics in a CAS environment: the genesis of a reflection about instrumentation and the dialectics between technical and conceptual work. International Journal of Computers for Mathematics Learning, n° 7, p. 245-274. BAILLAT G. (2008). Tensions autour du ePortfolio : de la régulation au contrôle de la formation. Actes du 15e Congrès de l’AMSE-WAER. Marrakech, 2-6 juin 2008. BAILLAT G., CONNAN P.-Y. et VINCENT J. (2007). Évaluer les compétences dans le contexte des formations universitaires professionnalisantes ? Les ressources et les contraintes du portfolio numérique. Actes du Colloque CDIUFM, Arras, IUFM Nord-Pas de Calais. BARREAU L., BRANCIARD L., CAMPS P. et PUEL J.B. (2004). Du parcours individuel à la construction d’un savoir collectif : le ePortfolio intégré à une plateforme de travail collaboratif. Seconde conférence internationale sur le ePortfolio, La Rochelle, 28-29 Octobre 2004. BARRETT, H. (2010). Balancing the Two Faces of ePortfolios. Educacão, Formacão & Tecnologias, Vol. 3 n°1, p.6-14. BARRETT, H. (2001). Electronic portfolios. In A. Kovalchick & K. Dawson (Eds.), Educational technology: An encyclopedia. Santa Barbara, CA: ABC-Clic. BARON G-L, BRUILLARD É. (2003). Les technologies de l'information et de la communication en éducation aux USA : éléments d'analyse sur la diffusion d'innovations technologiques. Revue Française de Pédagogie, n° 145, p. 37-49. BARTON J. et COLLINS A. (1993). Portfolios in Teacher Education. Journal of Teacher Education, Vol. 44, n°3, p. 200-209. BELAIR L.M. (2002). L’apport du portfolio dans l’évaluation des compétences. Évaluation et Formation, Questions vives, recherches en éducation 1 (1), Université́ de Provence, Aix-Marseille, p. 17-38. BELAIR L.M. et LEBEL C. (2004). Le dossier progressif : vecteur de construction de compétences et de l'identité professionnelle en formation à l'enseignement. 7e BIENNALE de l’éducation et de la formation, INRP & APRIEF, 14-17 avril 2004, Lyon. BERTRAND C., LAMEUL G. (2008). Approche par compétences et e-portfolios : accompagnement et formation des formateurs. Séminaire Montpellier 2008, CDIUFM – SDTICE. Montpellier, 5 et 6 mai 2008. BIRD T. (1990). The School Teachers's Portfolio: An Essay on Possibilities», in J. Millman et L. Darling-Hammond, The New Handbook of Teacher Evaluation, Newbury Park, CA, Sage. p. 241-246. BLOOM L., BACON E. (1995). Using Portfolios for Individual Learning and Assessment». Teacher Education and Special Education, vol. 18, n° 1, p.1-9. BRUILLARD E. (2004). Eportofolio authorship for teachers : considerations of flexibility and productive constraints. Colloque Europortfolio, La Rochelle, 28-29 octobre 2004. CERISIER J-F. (2006). Utilisation d’un portfolio numérique dans l’enseignement universitaire pour l’évaluation de stages professionnels. 1ère Conférence Internationale Francophone sur l’ e-portfolio, Québec, 10-12 avril 2006. CHARPILLE JL., COUNIL E. (2010). C2i® niveau 2 « enseignant » : des dispositifs numériques pour former et certifier. Actes de TICE2010 - 7ème Colloque Technologies de l'Information et de la Communication pour l'Enseignement. Nancy, 6-8 décembre 2010, ISBN 2-9516740-5-8. CHERQUI-HOUOT I., LAVIELLE-GUTNIK N. et JOURNOT E. (2010). Lorfolio : Un portfolio numérique pour les lorrains. Actes de TICE2010 - 7ème Colloque Technologies de l'Information et de la Communication pour l'Enseignement. Nancy, 6-8 décembre 2010, ISBN 2-9516740-5-8. CONNAN P.-Y., VINCENT J. (2010). Pratiques innovantes et formations universitaires professionnalisantes : l’ePorfolio pour développer, accompagner et évaluer les compétences. In G. Baillat, D. Niclot & D. Ulma (eds). La formation des enseignants en Europe. Approche comparative, Bruxelles : De Boeck. CONNAN P.-Y., VINCENT J. (2008). ePortofolio et dossier de compétences dans le processus de formation des enseignants en France. Réflexion autour de l’articulation entre évaluation formative, valorisation du parcours et validation institutionnelle des compétences professionnelles. Actes du 15e Congrès de l’AMSE-WAER, Marrakech, 2-6 juin 2008. DEVE V., GAGNAYRE R. et IVERNOIS JF. (2009). Le portfolio : définitions et perspectives pédagogiques à partir d’une analyse de textes canadiens et européens. Éducation du patient et Enjeux de santé, vol. 27, n°1. DOYON A. et DESJARDINS R. (2004). Le porfolio de développement professionnel comme outil d’intégration en formation initiale en enseignement. Vie pédagogique. suppl. électronique, 9 déc. 2004. EMPRIN F. (2010). A didactic engineering for teachers education courses in Mathematics using ICT. Proceeding of the 6th CERME conference, Lyon, France, 28 janvier-1er février. EMPRIN F., LAGRANGE J-B. (2007). Dispositifs en ligne dans la formation des professeurs des écoles. Réflexions et échanges à partir de l'expérience de l'IUFM Champagne Ardenne. In actes du XXXIVème colloque copirelem expérimentation et modélisation dans l'enseignement scientifique: quelles mathématiques à l'école ?, Troyes, juin 2007. EMPRIN F. et VINCENT J. (2007). Bilan de l’expérimentation CBI 2006-2007. Centre de Châlons-en-Champagne. rapport — IUFM de Reims CA, juin 2007. FOLCHER V. (2005). De la conception pour l’usage au développement de ressources pour l’activité. In RABARDEL P. et PASTRE P. (eds). Modèles du sujet pour la conception, dialectiques activités développement. Octarès, p 189-210. GOUPIL G. (1998). Le portfolio: vers une pratique réflexive de l'enseignement. Vie pédagogique, n° 107, avril-mai 1998, p. 21-48. KARSENTI T., LEDOUX M. et GOYER S. (2006). Edu-portfolio.org : le portfolio numérique malléable pour maximiser l’intégration des TIC en contexte scolaire. 1ère Conférence Internationale Francophone sur l’e-portfolio, Québec, 10-12 avril 2006. LOISY C. (2006). C2i2e : questions autour de l’intégration des technologies dans les pratiques des formateurs. 8e Biennale de l’éducation et de la formation, APRIEF & INRP, Lyon, 11-14 avril 2006. PERRENOUD P. (1997). Construire des compétences dès l’école. Paris, ESF, chapitre 4, p. 93-110. RABARDEL P. (1995). Les hommes et les technologies : approche cognitive des instruments contemporains. Paris : Armand Colin. RABARDEL P. (1999). Éléments pour une approche instrumentale en didactique des mathématiques. Conférence, Actes de l’université d’été de didactique des mathématiques, Université de Caen. RABARDEL P. (2005). Instrument subjectif et développement du pouvoir d’agir. In : RABARDEL P.et PASTRE P. (eds.). (2005). Modèles du sujet pour la conception, dialectiques activités développement. Octarès, p. 11-31. REINERT M. (1993). Quelques problèmes méthodologiques posés par l'analyse de tableaux « Énonces x Vocabulaire ». actes du colloque journées internationales d’analyse statistique de données textuelle JADT, Montpellier. REINERT M. (2003). Le rôle de la répétition dans la représentation du sens et son approche statistique par la méthode ALCESTE, Semiotica. Vol. 2003, n°147, p.389–420, ISSN (Online) 1613-3692, ISSN (Print) 0037-1998, DOI: 10.1515/semi.2003.100, 18/11/2003 published online: 23/01/2006 ROBERT A. (1999). Recherches didactiques sur la formation professionnelle des enseignants de mathématiques du second degré et leurs pratiques en classe. DIDASKALIA, 15. ROBERT A., RODITI E. et GRUGEON B. (2007). Diversités des offres de formation et travail du formateur d’enseignants de mathématiques du secondaire. Petit x, IREM de Grenoble. ROMAINVILLE M. (2001). Les implications didactiques de l’approche par compétences, Enjeux, Vol. 51, p. 111-128. SCHöN D. (1994). Le praticien réflexif. À la recherche du savoir caché dans l’agir professionnel, Montréal, Les Éditions Logiques. TOCHON F. (2006). La formation des enseignants aux Etats-Unis : enjeux socio-économiques et professionnels actuels. Formation et pratiques d’enseignement en questions, n° 5, p. 29-41, CDHEP, Neuchâtel. TROUCHE L. (2005). Construction et conduite des instruments dans les apprentissages mathématiques : nécessité des orchestrations. Recherches en Didactique des Mathématiques, vol. 25 n°1, Grenoble : La pensée sauvage. VANHULLE S. & SCHILLINGS A. (2004). Former des enseignants compétents en lecture-écriture : interactions sociales, portfolio, et écriture réflexive. Bruxelles: Labor. WOLF K.P. (1991). Teaching Portfolios: Synthesis of Research and Annotated Bibliography, Far West Lab. for Educational Research and Development, San Francisco, CA, Office of Educational Research and Improvement, (ERIC Document Reproduction Service n° ED 343890)

| |||||||||||||||||||||||||||||||||||||||||||||||

Référence de l'article :Pierre-Yves Connan, Fabien Emprin, Le portfolio numérique : quelles évolutions des usages et des représentations chez les formateurs d’enseignants ?, Revue STICEF, Volume 18, 2011, ISSN : 1764-7223, mis en ligne le 14/02/2012, http://sticef.org |

© Revue Sciences et Techniques de l'Information et de la Communication pour l'Éducation et la Formation, 2011