Sciences et Technologies

Sciences et Technologiesde l´Information et

de la Communication pour

l´Éducation et la Formation

version à télécharger (pdf)

Volume 17, 2010

Article de recherche

|

Contact : infos@sticef.org |

Tests de compétences tableur : l’apport des discours des étudiants sur leurs activités.

1. IntroductionDes études internationales ont été menées afin d’évaluer les compétences en TIC des jeunes de culture numérique ou digital natives : PISA (Lennon et al., 2003), Eurostat (Demunter, 2006), ECAR (Kvavik et al., 2004). Parmi les différents indicateurs identifiés, figure la capacité à utiliser des progiciels. Parmi eux, les logiciels tableurs sont particulièrement intéressants. Ce sont des outils relativement techniques, qui demandent de maîtriser des représentations tabulaires de données et de savoir exploiter les traitements qu’on peut leur appliquer : représentation graphique, calculs et simulation, gestion de tables, programmation. Des enquêtes menées auprès d’étudiants d’université, (Kvavik et al., 2004) pour EDUCAUSE ou (Lim, 2004) en Australie, apportent des données sur des usages déclarés des progiciels et les niveaux de compétences auto-estimés sur ces mêmes progiciels. (Baron et Bruillard, 2008) soulignent un paradoxe concernant le tableur dans ces travaux : alors que les étudiants déclarent passer du temps à utiliser des tableurs, ils estiment en avoir un niveau de maîtrise bien inférieur à d’autres logiciels (notamment le traitement de textes). Ces études fondées sur des déclarations des étudiants ne permettent pas de regarder au plus près ce qu’ils savent et savent faire véritablement avec un tableur. Dans le cadre du projet DidaTab(1) (Bruillard et al., 2008), centré sur la didactique du tableur, nous nous sommes intéressés à l’étude des processus mis en œuvre par les élèves de collèges et lycées lors de l’utilisation du logiciel. Dans cette recherche, divers outils ont été exploités pour capturer et évaluer les compétences tableur des élèves. Des tests d’évaluation sur papier et sur machine ont été administrés à plus de 800 élèves (Blondel et Tort, 2007). L’analyse des réponses des élèves a montré que leurs connaissances étaient embryonnaires et leurs compétences très élémentaires. Cependant, des observations réalisées pendant les tests ont révélé que la façon dont les élèves procèdent était tout aussi révélatrice de leurs savoirs et savoir-faire que leur production. Afin d’étudier ces processus, des enregistrements vidéo des interactions des élèves avec le tableur ont été exploités (Tort, 2009). L'analyse qualitative de ces enregistrements révèle d'autres informations sur les processus de résolution des questions et les manières de procéder des élèves avec le logiciel, notamment des comportements consistant à explorer systématiquement l’interface du logiciel en quête d’une solution. Toutefois, l’interprétation reste limitée par le manque de données permettant d’expliquer les manières de procéder des élèves, et de remonter aux raisons qui les motivent et aux savoirs et savoir-faire véritablement mobilisés. Pourquoi les élèves procèdent-t-ils de telle ou telle manière ? Quels savoirs mobilisent-ils pour cela ? Tenter de répondre à ces questions pose, immédiatement, une question d’ordre méthodologique : quelles données permettent de répondre à ces questions, comment les recueillir et comment les exploiter ? C’est l’objet de notre étude, réalisée dans le cadre d’une initiation à la recherche(2), qui a poursuivi une double finalité : - Approfondir nos connaissances sur les compétences tableurs des jeunes ; - Construire des outils méthodologiques permettant d’expliquer les manières de procéder des utilisateurs lors de l’utilisation d’un logiciel. 2. Evaluer les compétences tableurUn des objectifs initiaux du projet DidaTab, centré sur la didactique des progiciels et du tableur en particulier, était de fournir un panorama des compétences spécifiques au tableur, de leur évaluation et des conditions de leur programmation pour les jeunes en collège et lycée. Dans le cadre du projet, des outils d’évaluation des compétences tableur ont été élaborés (Blondel et Tort, 2007) : - Un référentiel de compétences spécifiques au tableur (des capacités observables) ; - Des outils d’évaluation de ces compétences (des tests machine et des tests papier) ; - Les principes d’élaboration des tests. L’exploitation de ces outils d’évaluation nous a permis d’élaborer une approche critique des méthodes de recueil et d’analyse de données pour l’évaluation de compétences sur un progiciel, tel que le tableur. Notamment la limite de l’exploitation des seules productions des étudiants testés, nous a amenés à explorer d’autres méthodes d’investigation. 2.1. La limite de l’analyse des productionsLes tests exploités dans le projet DidaTab sont composés d’une série de tâches. Chaque tâche présente une situation initiale simple comportant le plus souvent un tableau de données et énonce un objectif à atteindre. Celui-ci nécessite la réalisation d’une transformation sur le tableau initial : modification du format d’affichage de cellules, écriture d’une formule dans une cellule (Figure 1), tri des données (Figure 2), etc., ou bien l’ajout d’un nouvel objet : création d’un graphique, etc. Nous recueillons les productions des élèves enregistrées dans les fichiers. L’analyse des productions n’a pas pour objectif de valider ou non la réalisation de la tâche, mais d’observer les solutions proposées et de les interpréter à la lumière des savoirs et savoir-faire mobilisés.

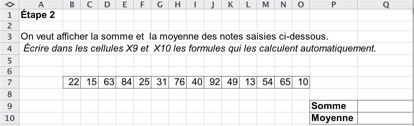

Figure 1 • une tâche nécessitant l’écriture de formules de calcul. Par exemple, la tâche de la figure 1 demande de saisir la formule de calcul de la somme des 14 valeurs saisies dans les cellules B7 à O7. Une solution évidente pour qui connaît les fonctions consiste à utiliser la fonction SOMME (=SOMME(B7:O7)). Le calcul peut aussi être effectué uniquement avec l’opérateur + (=B7+C7+D7+...). Cependant cette seconde solution nécessite une saisie fastidieuse et introduit des risques d’erreur de saisie(3). De même, deux solutions existent pour le calcul de la moyenne (opérateurs + et /, ou fonction MOYENNE), avec les mêmes inconvénients et avantages. Par ailleurs, la fonction SOMME est généralement disponible en un clic sur la barre d’outils du logiciel, alors que la fonction MOYENNE est plus indirectement accessible (nécessité de dérouler un menu). Dès lors, pour cette tâche, nous pouvons faire l’hypothèse qu’un élève n’utilisant que les opérateurs ne connaît pas les fonctions. Un élève utilisant la fonction pour le calcul de la somme, mais les opérateurs pour celui de la moyenne, ne sait peut être pas qu’il existe d’autres fonctions que SOMME. De plus, l’analyse des productions révèle des réponses erronées, imprévues, mais révélatrices de mécompréhension des élèves, qui sont toutes aussi intéressantes. Par exemple, des élèves ont une utilisation surprenante du mot SOMME, comme s’il fallait l’utiliser quelle que soit la formule de calcul à réaliser (=SOMME(A1-B1)) ou (=SOMME(A1*3)). Cela nous permet de supposer que ces élèves ont une conception erronée de la notion de fonction et méconnaissent les éléments de syntaxe d’une formule de calcul. Nous avons administré de tels tests à différentes populations d’élèves. Dans (Tort et al., 2008), nous avons montré sur quatre populations d’élèves de collèges et lycées(4), que les élèves testés réussissent tous à répondre aux questions portant sur des manipulations superficielles des objets du tableur, notamment la mise en forme des cellules. Ils réussissent moins bien les questions nécessitant plus de compréhension des objets propres au tableur, notamment, celles portant sur l’édition de graphique et le tri de table. De plus, ces questions sont plus discriminantes entre les différentes populations testées. Enfin, et surtout, les questions leur posant le plus de difficultés, et augmentant encore les écarts entre les populations testées, sont celles portant sur l’écriture de formules. Toutefois, l’analyse des productions finales des élèves testés présente des limites. En effet, ces productions ne fournissent pas d’information sur la manière dont les élèves ont procédé pour aboutir à ces résultats. Ils ne nous renseignent pas finement sur les difficultés rencontrées. Des questions restent sans réponse : Ont-ils réalisé les tâches en suivant des procédures acquises ? Ou, au contraire, ont-ils tâtonné à la recherche d’un résultat ? Ont-ils procédé tous de la même manière sur les mêmes activités ? Ou, au contraire, ont-ils des manières de procéder différentes ? Enfin, adoptent-ils des démarches que nous puissions observer et analyser plus finement ? 2.2. L’apport de l’analyse des traces d’activitésRépondre à ces questions suppose de s’intéresser au processus c'est-à-dire aux manières de procéder des élèves lors du test et donc aux traces des interactions. L’analyse des comportements d’utilisateurs d’environnement informatique a été développée dans différents domaines, notamment pour la conception d’environnements informatisés pour l’apprentissage humain (EIAH), (Grandbastien et Labat, 2006). Différentes recherches exploitent des données d’enregistrements des interactions de l’utilisateur avec un environnement informatique afin d’étudier les processus cognitifs de l’utilisateur dans sa résolution d’une tâche (Hulshof, 2004). Les méthodes utilisées dans ces travaux exploitent différentes sources de données : mouvements des yeux, raisonnement à voix haute, fichiers de log, mais aussi, en particulier pour les travaux s’intéressant à l’interaction entre plusieurs utilisateurs, enregistrements vidéo et/ou audio (Dyke et al., 2007). De manière analogue, mais dans le but de récolter des informations sur les savoirs de l’utilisateur sur le logiciel, la méthode d’analyse présentée dans (Tort, 2009) met en œuvre une démarche utilisant comme sources de données des traces re-jouables d’activités réalisées sur ordinateur, à savoir les enregistrements vidéo des écrans. Une autre solution aurait été d’exploiter les fichiers log, généré automatiquement lors de l’usage du logiciel, et mémorisant des traces d’action. Toutefois, ces fichiers ne mémorisent que les traces des actions aboutissant à une transformation sur le fichier, alors qu’il existe aussi d’autres actions non mémorisées, comme les survols de l’écran avec le pointeur de la souris. Les vidéos d’écran permettent d’observer les événements survenant sur les écrans comme des indicateurs des gestes réalisés par les élèves. L’analyse des vidéos met en évidence les types d’actions utilisées, leurs enchaînements, les temps consacrés, l’ordre de traitement des questions, les tentatives avortées n’ayant pas laissé de trace, etc. Ces informations complètent les analyses des productions et permettent de faire d’autres hypothèses sur les savoirs et savoir-faire des élèves sur le logiciel. Par exemple, pour la tâche de la figure 1, nous avons pu observer un élève sélectionner la cellule à l’extrémité de la ligne des valeurs à sommer (P7), puis, cliquer sur le bouton "" de la barre d’outils ; obtenir ainsi la formule "=SOMME(B7:O7)", puis passer du temps à recopier cette formule dans la cellule où il était demandé d’afficher ce calcul (Q9). Des observations complémentaires, nous ont permis de supposer que cet élève connaît la fonction SOMME, ne se souvient pas de la syntaxe de la formule, mais sait comment retrouver cette syntaxe.

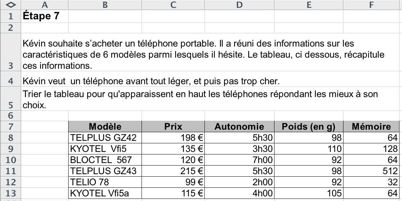

Figure 2 • une tâche nécessitant un tri sur deux critères. Un autre exemple concerne des tâches de tri de tables, telles que celle de la figure 2. Nous avons pu observer des élèves réaliser le tri à la main en copiant collant une à une chaque ligne de la table de façon à les réorganiser dans l’ordre souhaité. Ceci nous a permis de constater que ces élèves ne connaissent pas la fonctionnalité de tri automatique du logiciel, alors que la seule analyse du résultat obtenu nous faisait supposer le contraire. Plus généralement, pour différentes populations testées, l’analyse des vidéos permet de caractériser les modes d’action liés aux accès aux commandes (boutons des barres d’outil ou menus), à la saisie de formules (mode éditeur ou mode direct), à l’insertion d’une fonction (simple clic ou navigation dans la bibliothèque de fonctions) et des démarches caractéristiques de recherche de solution (exploration systématique des menus ; essais successifs de sélections ; découverte aléatoire de commande). Toutefois, ces observations ne fournissent pas d’indications sur les motivations des gestes observés. Or, comprendre pourquoi un apprenant adopte telle ou telle manière de procéder nous renseignerait sur la façon dont il articule ses savoirs et savoir-faire avec l’objectif qu’il poursuit dans la réalisation de la tâche, et donc sur ses compétences. De nouvelles interrogations apparaissent : les élèves adoptent-il de véritables stratégies de résolution ou appliquent-ils des procédures apprises par la pratique ? Pourquoi tâtonnement-ils ou hésitent-ils ? Leurs manipulations sont-elles hasardeuses ou résultent-elles de choix conscients ? La question méthodologique devient : comment recueillir des données révélant les motivations, les raisons des actions que les élèves réalisent pendant le test ? Nous avons donc décidé de compléter nos outils méthodologiques avec la perspective de les exploiter sur de nouvelles populations d’élèves. 3. Exploiter la verbalisation des activitésLes données recherchées portent sur les raisons expliquant les manières de procéder observées sur les vidéos d’écran. Pourquoi un élève testé adopte-il telle ou telle procédure ? Procède-t-il à un choix conscient ? Sur quels savoirs s’appuie-t-il pour cela ? Comment a-t-il acquis ce savoir ? Quelle conscience a-t-il de la validité de la procédure qu'il met en œuvre ? Afin de recueillir des réponses à ces questions, plusieurs méthodes sont possibles. Dans une étude similaire à la nôtre, (Parissis et Komis, 2009) ont opté pour l’observation participative. Ils combinent plusieurs sources vidéo (enregistrement écran et enregistrement de l’activité) et recueillent des explications pendant la réalisation des tests. Nous avons préféré adopter une méthode qui ne fasse pas intervenir le chercheur pendant la réalisation du test. Nous avons donc choisi de faire passer des entretiens après la réalisation du test. Productrice de données verbales, la méthode de l’entretien permet de faire apparaître les processus et les « comment » : elle est révélatrice de la logique d’une action (Blanchet et Gotman, 1992). 3.1. Une technique inspirée de l’entretien d’explicitationNotre étude étant de type exploratoire et qualitative, nous ne disposons pas de catégories objectives préconstruites pour mener un entretien directif. Au contraire, afin de favoriser le caractère naturel et la pertinence des questions et des réponses, il est nécessaire de ne pas figer la formulation et la séquence des questions à l'avance. Par ailleurs, il s’agit d’obtenir des verbalisations d’actions orientées par un but. Différentes méthodes de verbalisation d’action ont été développées dans le domaine de la sociologie (Rix et Lièvre, 2005). Parmi elles, l’entretien d’explicitation a pour but principal la verbalisation d’un vécu passé (Vermersh, 2004). C’est une technique particulière destinée à faciliter la description d’une action vécue par un acteur et plus particulièrement de son déroulement. P. Vermersch identifie deux buts à l’entretien d’explicitation : aider l’acteur à s’auto-informer (retour réflexif sur la démarche suivie pour une tâche ce qui lui permet de construire son expérience et d’en prendre conscience) ; mais, aussi, aider le chercheur à s’informer (analyse d’erreurs, expertise, recherche,...). C’est ce dernier aspect qui nous intéresse. Notre objectif est de mettre en œuvre les outils d’explicitation afin de dégager des motivations et des savoirs qui ne sont pas facilement identifiables par les étudiants eux-mêmes. La pratique de l’entretien d’explicitation abandonne l’interrogation directe du « pourquoi » (attente d’une réponse pour valider la compréhension d’une problématique) pour un questionnement a posteriori du « comment » (comprendre le fonctionnement intellectuel en situation). Les questions doivent être posées de manière à questionner : - soit le procédural, par exemple : « Comment avez-vous fait la première fois ? »; - soit l’intentionnel, par exemple : « Que visiez-vous ? »; - soit le déclaratif, par exemple : « Comment êtes vous arrivé au fait qu'il fallait figer les cellules ? ». De plus, des techniques de questionnements spécifiques sont utilisées : - des techniques d’accompagnement comme les reformulations, les acquiescements, les silences ; - des types de questions écartant les pourquoi comme « Vous avez essayé de trouver en faisant comment ? » ou « Qu'a t-elle de complexe ? » - l’exploitation de la part implicite des discours comme « Et dans la fonction Somme il n'y a pas de point-virgule ? » alors que l’étudiant fait référence au point-virgule comme élément de difficulté dans l’écriture d’une fonction. 3.2. Un dispositif combinant plusieurs sources de donnéesDans le cadre de notre étude, les entretiens ont pour objet la verbalisation des actions réalisées lors d’un test machine construit selon la méthode utilisée dans le projet DidaTab et résumée ci-dessus (section 2.1). Ils s’inscrivent donc dans un dispositif complet comportant : un test sur un logiciel tableur, un questionnaire court sur les usages en informatique des étudiants, et un entretien de verbalisation. L’entretien est réalisé juste après le test, afin que l’étudiant ait encore la situation de test en mémoire. L’entretien est centré sur les difficultés rencontrées (nature et raison), les modes opératoires adoptés en cas d’échec ou de succès, et les techniques de résolution adoptées. Pour chaque étudiant, le corpus de données recueilli comporte : - le fichier .xls, enregistrement de la production finale de l’étudiant ; - le fichier .camrec, enregistrement de la capture vidéo de l’écran (réalisé avec le logiciel Camtasia Studio©) qui fournit une trace de l’activité de l’élève ; - l’enregistrement audio de l’entretien individuel ; - le questionnaire papier rempli par l’élève. Les vidéos sont analysées en suivant la méthode présentée dans (Tort, 2009). Elle consiste à coder les événements observés en distinguant les actions élémentaires effectuées par l’utilisateur, et les réponses du logiciel, et en reportant les durées. Ce codage est complété de commentaires indiquant l’intention perçue et la précision de l’étape de la tâche réalisée. Cela permet de reconstruire une narration simplifiée des manières de procéder de l’élève. Les entretiens de verbalisation sont tout d’abord totalement retranscrits. Ensuite, ils sont traités en deux temps. Tout d’abord, on réalise un repérage des idées exprimées, qui sont ensuite regroupées selon leur proximité thématique. Dans un second temps, ces thèmes servent de grille d’analyse et d’interprétation des entretiens. Les thèmes sont donc établis a posteriori selon les idées exprimées par les étudiants interrogés. Enfin, nous verrons dans l’étude de cas suivante, que c’est la synthèse des résultats obtenus à partir des différentes sources de données qui apporte un résultat intéressant. 4. RésultatsNous avons réalisé une étude de cas auprès de 3 étudiants en parcours L2 d’une section tertiaire, en IUT. Notre objectif était de réutiliser les outils d’évaluation déjà en place : administration de tests machine, et exploitation des productions et des vidéos d’écrans, et de nous centrer sur l’apport des entretiens de verbalisation des activités. Nous présentons ici les résultats obtenus. 4.1. Caractéristique de la population et déroulementLes expériences, menées dans le cadre de DidaTab, nous ont appris qu’il est préférable de prendre des élèves dont les connaissances sont certes en construction mais néanmoins suffisamment développées pour avoir des données exploitables suffisantes. De plus, nous souhaitions élargir le spectre des recherches initiales aux populations d’étudiants de l’enseignement supérieur. Nous avons rencontré des étudiants d’un parcours supérieur professionnalisant d’une section tertiaire. Il s’agit d’étudiants en deuxième année de D.U.T. Gestion Administrative et Commerciale d’un établissement de la banlieue parisienne. Ils ont bénéficié d’une formation au tableur de 50 heures lors de leur première année de formation. Ils étaient volontaires, sans pour autant se considérer comme très bons en tableur.

Tableau 1 • Caractéristiques des étudiants testés Le test machine était composé de 9 tâches, couvrant différents types de compétences : manipulation d’entités (taille et mise en forme des cellules, format d’affichage des nombres) ; écriture de formules (notamment fonctions SOMME et MOYENNE, références de cellules relatives et absolues, recopie de formule, fonction SI) ; édition de graphique et tri de table. Ces tâches correspondent aux exigences de la formation du tableur du cursus GACO. Chaque étudiant a réalisé le test individuellement, pendant environ 20 minutes, sur le logiciel Microsoft Excel©. Le logiciel de capture vidéo d’écran a tourné en tâche de fond pendant toute la durée du test. Le remplissage du questionnaire et l’entretien individuel ont pris environ 30 min. 4.2. Résultats issus des traces d’activitéL’analyse des productions des 3 élèves nous informe sur leur niveau de réussite et de difficulté des tâches effectuées. Les questions plutôt réussies portent sur les manipulations d’entités, l’écriture de formules simples, l’utilisation de références relatives, l’édition de graphiques et la réalisation de série de dates. Les 3 étudiants les ont à peu près résolues. Ils ont rencontré des difficultés pour la tâche nécessitant de trier les données d’une table selon plusieurs critères (Voir la figure 2 au début de cet article) et l’écriture d’une formule nécessitant l’utilisation de la fonction SI. Un seul étudiant a effectué le tri et aucun n’a proposé une formule utilisant la fonction SI. Enfin l’étudiant E2 semble particulièrement en difficulté, il a réussi trois exercices sur les neuf. Ses résultats sont difficiles à caractériser : il ne répond pas à certaines questions plutôt basiques, de mise en forme de cellule, mais arrive à créer une série automatique de dates. Il écrit une formule correcte pour un calcul de somme, mais laisse une formule de moyenne inachevée, sans signe « = ». L’analyse des enregistrements vidéo des 3 étudiants a permis de nuancer les réussites et les difficultés supposées par l’analyse des productions finales. Notamment, on observe que les tâches non abouties ne correspondent pas forcément à une absence totale de savoir ou savoir-faire de l’étudiant. Par exemple, pour une tâche nécessitant la fonction SI, l’analyse des vidéos de deux étudiants (E1 et E3) révèle qu’ils ont essayé d’utiliser la fonction SI, mais ont échoué dans l’écriture des paramètres de la fonction, et ont abandonné. Plus généralement, l’observation des enregistrements vidéo révèle des divergences entre ces trois étudiants.

Tableau 2 • Comparaison des observations : divergences entre les étudiants Trois remarques découlent de ces observations : - Les trois étudiants interagissent de manière différente avec le tableur ; - Il se dégage des invariants dans les modes de fonctionnements individuels. Par exemple, on observe que E1 utilise le bouton « retour arrière » en cas d’erreur tandis que E3 explore systématiquement le menu contextuel dès qu’il ne répond pas immédiatement à une question. - Le comportement de E2 est plus difficile à caractériser : il semble parcourir l’écran comme on parcourt un lieu physique. 4.3. L’exploitation des verbalisations et leurs résultats4.3.1. Exploitation des entretiens : la grille d’analyse thématiqueLes entretiens ont été centrés sur les difficultés rencontrées (nature et raison), les modes opératoires en cas d’échec ou de succès, l’utilisation des fonctions prédéfinies, les techniques de résolution adoptées grâce à un guide d’entretien élaboré au préalable fonction des études précédentes. L’exploitation des entretiens a été réalisée en trois étapes : - Les entretiens ont été transcrits pour compléter le corpus ; - Les données ont été organisées en thèmes ; - Le contenu des discours est analysé et interprété selon ces thèmes. Pour obtenir une grille de lecture explicitable, nous avons établi des catégories objectivées à partir des discours. L’identification des thèmes s’est faite à partir de la lecture des transcriptions et en appliquant les formalisations de l’analyse thématique, (Blanchet et Gotman, 1992), bien que notre corpus soit limité en nombre. Nous avons donc combiné : - Une analyse verticale qui porte sur chaque personne : est passé en revue le discours de chacun sur les différents thèmes et une synthèse individuelle est tentée - Une analyse horizontale : elle traite chaque thème de façon transversale, relevant les différentes formes sous lesquelles il apparaît dans le discours des personnes interrogées.

Tableau 3 • Extrait du guide d'analyse thématique des discours Les principaux thèmes qui ont émergé de la catégorisation des discours sont : Appréciation sur le niveau de difficulté du test, Modes et logiques d’action mises en œuvre, Motivations des choix d’actions, Difficultés rencontrées, Méthodes de résolution, Causes des difficultés, Appréciation des résultats obtenus. Le tableau 3 reproduit un extrait de ces thèmes et des idées correspondantes exprimées par les étudiants lors des entretiens. 4.3.2. Les étudiants justifient leur choixIl apparaît que les étudiants E1 et E3 adaptent, plutôt consciemment, leur interaction au contexte rencontré. En particulier : Ils gardent à l’esprit un résultat visé et vérifient le résultat obtenu. Par exemple, E1 dit qu’il recopie une formule de calcul vers le bas, puis il décrit une technique de validation du résultat obtenu : "Ben quand je descends ça me donne d'autres chiffres donc après je vais pas forcément calculer mais ça m'a pas mis plein de petit "#" ou 0 quand il y a des chiffres ça va." [E1] Autre exemple, E3 explique à plusieurs reprises qu’il vérifie le résultat obtenu, et cherche une autre solution quand il diffère du résultat attendu : "ça m'a calculé un bon résultat pour

le premier, mais pour le deuxième, je crois qu'il y avait plein de "#"

des trucs comme ça. C'était pas le résultat donc j'ai

cherché" [E3] E1 et E3 disent reproduire des gestes appris : " On m'a appris comment faire une somme ou comment

utiliser la formule somme, ou même déplacer par exemple pour le

dernier exercice (...)" [E3] E1 choisit volontairement de ne pas utiliser les fonctions prédéfinies SOMME et MOYENNE alors qu’il les connaît : "- Avez-vous utilisé les fonctions

prédéfinies comme somme, moyenne ? E1 justifie ses choix d’actions par la volonté de ne pas se tromper, la régularité d’utilisation ou des habitudes propres. Il se dégage de l’analyse des discours que, globalement, les procédés adoptés par les étudiants E1 et E3 sont conscients et organisés, et non pas un ensemble de gestes désordonnés. Les étudiants E1 et E3 ont à l’esprit le résultat visé et s’en préoccupent en effectuant des vérifications même si, il est vrai, leur méthode de validation est plutôt superficielle. De plus, ils effectuent des choix conscients et savent les justifier. 4.3.3. Des portraits distincts : identification de stratégies personnellesEnfin, les verbalisations issues des entretiens ont été mises en relation avec les analyses des enregistrements vidéo d’écran, des productions finales et le questionnaire sur les usages. La combinaison des quatre sources de données a permis de mettre en évidence que chaque étudiant interagit de manière différente avec le logiciel, et qu’il existe une cohérence au sein de chaque démarche. L’organisation des informations issues de toutes les sources de données nous amène à proposer cinq indicateurs : la connaissance des objets du tableur, l’origine des actions de manipulation de l’interface, des caractéristiques de comportement saillantes, la régularité d’usage du tableur, et les expressions langagières. La valorisation de ces indicateurs pour les trois étudiants testés est présentée dans le tableau 4. La relecture du tableau étudiant par étudiant, fait apparaître trois portraits différents d’utilisateur du tableur éclairant le lien entre leurs attitudes et l’utilisation du logiciel. Ces trois étudiants ne présentent pas les mêmes compétences ni les mêmes comportements vis-à-vis du logiciel, bien qu’ils aient eu la même formation au tableur.

Tableau 4 • Cinq indicateurs pour les étudiants interviewés 5. Discussion et perspectivesDans un dispositif de tests de compétence sur un logiciel tableur, comportant l’analyse des traces d’activités (production finale et capture vidéo des écrans), l’introduction d’entretiens pour recueillir une verbalisation des activités a enrichi notre compréhension des savoirs et savoir-faire mobilisés. La méthode utilisée fournit des informations susceptibles de nous aider à mieux comprendre les manipulations lors des interactions des utilisateurs avec le logiciel, notamment sur les types de difficultés rencontrées, les causes attribuées aux difficultés et les motivations des gestes observés. De plus, la prise en compte des différents types de données collectées, nous a permis de dresser des portraits des étudiants, révélant leurs comportements lors de la réalisation de tâches simples nécessitant l’utilisation d’un tableur. 5.1. Discussion de la méthode utiliséeLa méthode d’analyse présentée est exigeante et coûteuse à toutes les étapes de la recherche : du fait de la diversité du corpus, du temps nécessaire pour l’analyse et l’interprétation des vidéos et des verbalisations, particulièrement comme ici, lorsqu’il s’agit de procédures mentales relatives à des connaissances et compétences car implicites et difficiles à caractériser. L’exigence concerne aussi le rôle du chercheur qui se doit d’être toujours rigoureux dans ce type d’enquête qualitatif et exploratoire basé sur des entretiens peu directifs. Si la spontanéité des verbalisations est un atout d’authenticité, elle présente le risque de ne pas être toujours productive. L’analyse de la verbalisation des interactions avec le tableur présente deux apports essentiels à l’étude des comportements des utilisateurs du tableur. Le premier apport concerne l’amélioration du processus général d’analyse des comportements. Le recueil des entretiens n’a pas été sans effet sur l’exploitation des traces des activités. Pendant cette phase, le souvenir des entretiens a permis de réduire l’incertitude et l’interprétation inhérente de gestes inexpliqués à cette étape. Par exemple à la question 2 quand la vidéo des écrans de E1 montre dans l’étape de calcul des moyennes « Curseur se déplace sur les cellules A7 à O7 », l’interprétation en « Compte le nombre de cellules » est instantanée car lors de l’entretien E1 a fourni des indications sur la manière dont il a calculé les moyennes. Le processus général gagne alors en efficacité (on se pose moins de questions) et validité (on interprète moins). Le second apport est relatif à la connaissance du mode opératoire des étudiants dans l’utilisation du tableur. La prise en compte des discours éclaire sur les motivations des actions observées dans l’analyse des vidéos d’écran et permet d’introduire des caractéristiques de nature individuelle dans l’étude des compétences tableur. Les éléments d’un mode opératoire propre à chaque étudiant sont tirés de leur discours. Les étudiants de la population testée ne présentent pas un comportement unique dans leur interaction avec le tableur bien qu’ils aient suivi la même formation au tableur. Ils sont cohérents, chacun, dans leur style. 5.2. PerspectivesPlusieurs perspectives de recherche existent pour en prolonger les résultats, dans le domaine de la recherche d’une part et dans le domaine de la formation d’autre part. Concernant le domaine de la recherche, des explorations pourraient être menées afin de : - Trouver des éléments explicatifs des styles observés ou d’autres styles ; - Examiner la possibilité d’établir une typologie de comportements des usagers ; - Caractériser encore plus finement les gestes et intentions des jeunes utilisateurs des tableurs par une analyse lexicale de leur discours qui examinerait dans quelle mesure les termes employés par les étudiants sont révélateurs d’un niveau ou d’un comportement. Concernant le domaine de la formation, nos résultats montrent que les apprenants ont des comportements et des compétences construits, ne découlant pas uniquement des formations assurées. Habitudes, apprentissages antérieurs, usages, représentations etc. ne sont pas neutres. La prise en compte des éléments de nature individuelle serait de nature à favoriser un apprentissage efficace dans l’enseignement des logiciels en général et du tableur en particulier. Les résultats de notre étude peuvent servir pour l’élaboration de curriculum de formation de formateurs.

(1) Didactique du Tableur, projet coordonné de 2004 à 2007 par une équipe de l’ENS de Cachan, l'Unité Mixte de Recherche (UMR) du laboratoire STEF. (2) Master M2 recherche Didactique des sciences et techniques mention du Master "Communication scientifique et technique : contenus, outils, pratiques" de l’École doctorale Sciences Pratiques de l'ENS de Cachan-INRP (3) Ce n’est pas là le seul inconvénient de l’opérateur + par rapport à la fonction SOMME. L’opérateur + retourne une erreur si les cellules à sommer contiennent des valeurs non numériques, alors que la fonction SOMME les ignore. Toutefois dans la tâche proposée cette propriété n’est pas véritablement un critère de choix. (4) Les populations d’élèves testées étaient composées de 22 élèves de troisième au collège, 30 élèves de seconde générale, 22 élèves de première L et 13 élèves en terminale Bac Pro. tertiaire 6. RéférencesBARON, G.L., BRUILLARD, E. (2008). Technologies de l’information et de la communication et indigènes numériques : quelle situation ?, Rubrique de la revue STICEF, Volume 15, disponible sur internet : http://sticef.org. (Consulté le 24 mars 2011). BLANCHET, A., GOTMAN, A. (1992). L’enquête et ses méthodes : l’entretien. Paris: Nathan. BLONDEL, F.-M., TORT, F. (2007). Comment évaluer les compétences des lycéens en matière de tableur ? In T. Nodenot, J. Wallet et E. Fernandes (Éds.), Actes de la conférence EIAH2007 (p. 77-82). Lyon : INRP et Paris : ATIEF. Disponible sur internet : http://hal.archives-ouvertes.fr/hal-00161396. (Consulté le 24 mars 2011). BRUILLARD, É., BLONDEL, F.-M., TORT, F. (2008). DidaTab project main results: implications for education and teacher development. In K. McFerrin, R. Weber, R. Carlsen et D.A. Willis (Eds.) Proceedings of Society for Information Technology and Teacher Education International Conference, SITE 2008 p. 2014-2021. Chesapeake, USA: AACE. ISBN: 1-880094-64-9. DEMUNTER, C. (2006). How skilled are Europeans in using computers and the Internet, Eurostat, European Communities, 17/2006. DYKE G., GIRARDOT J. J., LUND K., CORBEL A. (2007). Analysing Face to Face Computer-mediated interactions, EARLI (European Association for Research Learning and Instruction), 12th Biennal International Conference, Budapest, Hungary GRANDBASTIEN, M., LABAT, J-M., (2006). Environnements Informatiques pour l'Apprentissage Humain Hermes Lavoisier (Ed.). Disponible sur internet : http://hal.inria.fr/inria-00103288/en/ (Consulté le 24 mars 2011). HULSHOF, C. D. (2004). Log file analysis. In L.Kimberly Kempf (Ed.), Encyclopedia of Social Measurement. Elsevier, p. 577-583. KVAVIK, R.B., CARUSO, J.B. (2004). ECAR Study of Students and Information Technology, 2005: Convenience Connection, Control and Learning, Vol.6, 2005. LENNON, M., KIRSH, I., VON DAVIER, M., WAGNER, M., YAMAMOTO, K. (2003). Feasibility Study for the PISA ICT Literacy Assessment, ACER, 2003 LIM, K. (2004). A Survey of First-Year University Students’ Ability to use Spreadsheets, Spreadsheets in Education (eJSiE), Vol. 1 n°2, p 71-85. Disponible sur internet : http://epublictions.bond.edu.au/ejsie/vol1/iss2/1/. (Consulté le 24 mars 2011). PARISSIS, M., KOMIS, V. (2009). Etudier les activités des élèves concernant l’usage des tableurs à l’aide d’une analyse d’enregistrements vidéo in G.L. Baron, É. Bruillard et L.O. Pochon (Eds.), Informatique et progiciels en éducation et en formation p. 318-336. Lyon : INRP RIX, G., LIEVRE, P. (2005). Une mise en perspective de modes d’investigation de l’activité humaine. Disponible sur le site de l’ Association Française de Science des Systèmes : http://www.afscet.asso.fr/resSystemica/Paris05/rix.pdf TORT, F. (2009). Tests de compétences tableur. Ce que révèlent les enregistrements d’écran. in G.L. Baron, É. Bruillard et L.O. Pochon (Eds.), Informatique et progiciels en éducation et en formation p. 296-317. Lyon : INRP. Disponible sur internet : http://www.stef.ens-cachan.fr/annur/tort/tbb_issep_2008.pdf (consulté le 24 mars 2011) TORT, F., BLONDEL, F.-M., BRUILLARD, É. (2008). Spreadsheet Knowledge and Skills of French Secondary School Students. In R.T. Mittermeir and M.M. Syslo (Eds.): ISSEP 2008, LNCS 5090, (p. 305-316). Berlin: Springer-Verlag. VERMERSH, P. (2009). Méthodologie d’analyse des verbalisations relatives à des vécus (1). Expliciter, Vol. 81, p.1-21. disponible sur internet : http://www.expliciter.fr/IMG/pdf/81_octobre_ 2009.pdf 7. Références complémentaires non citéesSite du Projet DidaTab : http://www.stef.ens-cachan.fr/didatab/fr/ Toile : AnnexesExemple de codage d’un enregistrement vidéo.

Extrait du codage de l'enregistrement de l'étudiant E1 pour la tâche 1 Exemple d’une narration de vidéo (...) Après un moment, la souris clique sur la cellule D7 (zone de la formule à écrire) puis clique sur le bouton ‘fx’ fonction à insérer et sélectionne la fonction SI. La fenêtre "arguments de la fonction" s’ouvre. Après plusieurs saisies différentes, dans les zones "test_logique" est saisi "15", dans "valeur_si_vrai" est saisi "<C7" (C7 est obtenu par clic sur la cellule âge) puis la fenêtre est fermée par un clic dans la zone "x". Après un moment, la souris clique sur la feuille suivante. [01:45:51] Extrait de la narration de la réalisation de la tâche 1 pour l'étudiant E1 Exemple du codage d’un entretien

Extrait de l'établissement des thèmes à partir du discours de E3

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

Référence de l'article :Aurélie Chatelet Ewango, Françoise Tort, Tests de compétences tableur : l’apport des discours des étudiants sur leurs activités, Rubrique de la Revue STICEF, Volume 17, 2010, ISSN : 1764-7223, mis en ligne le 30/03/2011, http://sticef.org |

© Revue Sciences et Techniques de l'Information et de la Communication pour l'Éducation et la Formation, 2010