Sciences et Technologies

Sciences et Technologiesde l´Information et

de la Communication pour

l´Éducation et la Formation

version à télécharger (pdf)

Volume 14, 2007

Article de recherche

|

Contact : infos@sticef.org |

Stratégies d'utilisation de la direction du regard en situation de communication interpersonnelle enseignant-élève

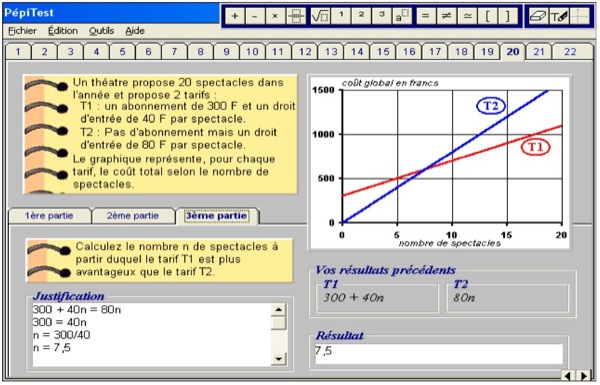

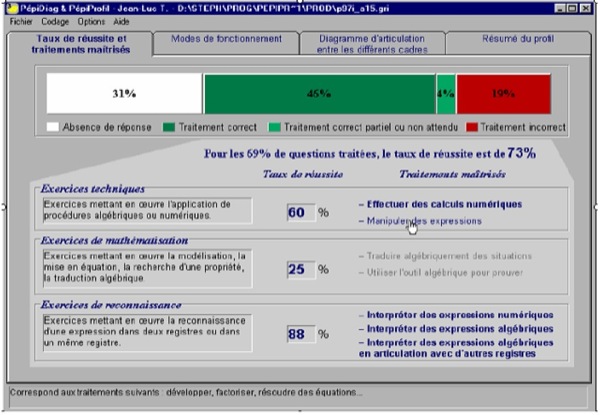

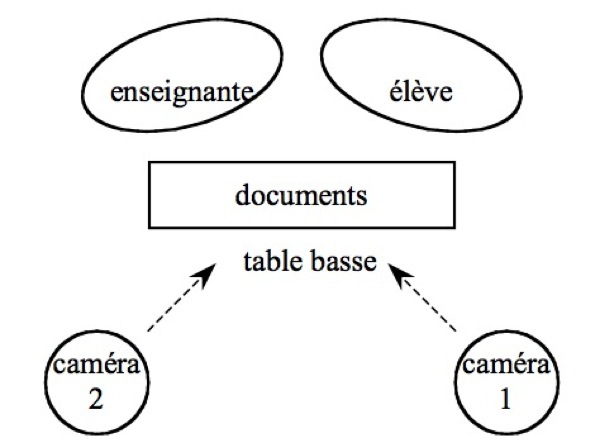

1. Contexte et objectifs de rechercheLes recherches en Sciences Humaines ont montré l’importance de la communication non verbale dans les interactions interpersonnelles enseignant - apprenant. En fonction d’un objectif pédagogique à un instant donné, un enseignant s’appuie sur un large éventail d’éléments de communication verbale et non verbale (e.g. gestes, postures, direction du regard, expressions faciales) (Richmond et Croskey, 2004). Les gestes, s’ils sont cohérents avec la parole peuvent, par exemple, faciliter et accélérer la compréhension d’un discours. De nombreuses études ont ainsi étudié la perception par les apprenants du style expressif et des comportements non verbaux des enseignants (« immediacy » ou proximité psychologique de la part de l’enseignant, enthousiasme de l’enseignant) (Babad, 2005). Dans cet article, nous présentons une étude exploratoire sur le comportement multimodal d’un enseignant dans une situation de diagnostic lors d’une interaction dyadique avec un élève. Ce travail se situe dans le contexte du projet MICAME-Pépite dont l’objectif est de mettre au point un agent pédagogique animé (APA) qui accompagne un élève dans une réflexion sur ses compétences en algèbre. En effet, dans le cadre de l’équipe projet AIDA1, deux équipes ont décidé de fédérer leurs efforts sur ce projet commun. 1.1. Le projet MICAME2Dans le projet Modélisation Informatique de la Coopération, de l'Adaptativité et de la Multimodalité dans l'Enseignement (MICAME), un des objectifs principaux est de mieux comprendre la nature et les mécanismes qui sous-tendent les interactions multimodales et coopératives afin d'envisager la spécification d'Interfaces Humains-Machines multimodales dans les EIAH (Réty et al., 2003). Les Agents Pédagogiques Animés se situent à la croisée de deux directions de recherche : les Agents Conversationnels Animés (ACA) et les EIAH. Un Agent Conversationnel Animé (Cassell et al., 2000) est une interface homme-machine utilisant un personnage animé affiché à l’écran doté de capacités communicatives inspirées de la communication humaine. On distingue généralement deux niveaux de spécifications (Poggi, 2003) : celui des fonctions communicatives (par exemple la gestion des tours de parole) et celui des signes multimodaux (par exemple le regard). Un Agent Pédagogique Animé (APA) est un ACA utilisé dans un EIAH. Le personnage est, par exemple, affiché à côté d’un support de formation ou intégré dans un environnement virtuel pédagogique en 3D. Le personnage vise à fournir des signes de communication verbale et non verbale (regard, expressions faciales, gestes de la main, postures) tout en cherchant à motiver les apprenants par des aspects communicationnels et émotionnels (Johnson et al., 2000). Chaque mouvement, chaque posture corporelle, chaque expression faciale, chaque geste de l’agent pédagogique a ainsi une fonction communicative qui est interprétée par l’apprenant. Plusieurs études expérimentales (Dehn et van Mulken, 2000), (Buisine, 2005) ont évalué l’utilisation d’agents pédagogiques en termes d’efficacité (amélioration ou non des performances, transfert d’apprentissage) et de satisfaction subjective (préférence des sujets pour une version d’un EIAH avec vs. sans agent pédagogique). Dans l’objectif de spécification et de développement d’un agent pédagogique, nous nous intéressons particulièrement à l’étude du comportement de l’apprenant et de l’enseignant en matière de communication verbale et non verbale. Le projet Pépite, et en particulier le volet qui travaille sur un dialogue réflexif entre un élève et un enseignant autour d’un diagnostic de compétences en algèbre, nous est apparu comme un contexte très pertinent pour mener un travail sur les APA. 1.2. Le projet Pépite3Le projet Pépite (Delozanne et al., 2003) a pour objet l’évaluation des connaissances en algèbre d’élèves à la fin de la scolarité obligatoire (troisième ou seconde). Un logiciel, lui aussi appelé Pépite a été réalisé (Jean-Daubias, 2002). Il est composé d’un module de test (PépiTest) qui propose à l’élève un ensemble structuré d’exercices d’algèbre et d’un module d’analyse des réponses de l’élève qui permet de construire un profil cognitif de l’élève (PépiProfil). Le profil établi par Pépite est destiné aux enseignants pour leur permettre de différencier les apprentissages. Cependant, en accord avec les chercheurs en EIAH qui proposent de créer des modèles de l’élève ouverts (Bull et Kay, 2005) ou inspectables (Kay, 2000), nous avons fait l’hypothèse que l’on peut faire progresser les élèves en les responsabilisant par une réflexion de niveau méta sur leur résultats (Katz et al., 2003) pour qu’ils se construisent une représentation de leur compétence et de la compétence attendue par l’institution. Lors d’expérimentations pilotes durant lesquelles un enseignant discutait individuellement avec des élèves de leurs résultats au test et de leur profil établi par Pépite, deux éléments nous sont très clairement apparus. Premièrement, il ne suffit pas de montrer les profils générés par Pépite mais une véritable discussion s’engage entre l’enseignant et l’apprenant pour préciser les attentes de l’institution et la position de l’élève par rapport à ces attentes. Si la notion de profil cognitif est adaptée pour aider l’enseignant à définir des stratégies d’enseignement différentiées (Vincent et al., 2005), la notion de bilan de compétence nous a semblé plus appropriée en ce qui concerne la rétroaction fournie à un élève après un test. En effet, elle sous-tend une négociation entre l’enseignant et l’élève et permet de valoriser l’élève en lui présentant ses points forts et pas seulement ses points faibles.. Deuxièmement, si nous avons constaté un très vif intérêt de la part des adolescents pour l’image complexe que le logiciel leur renvoie de leurs compétences, nous avons pu constater une forte charge émotionnelle dans les discussions. Ces expérimentations nous ont amenés à émettre l’hypothèse qu’un agent conversationnel animé pourrait favoriser la réflexion métacognitive des élèves sur leurs résultats au test diagnostic, en particulier en manifestant une empathie qui aide le sujet à se déculpabiliser de ses erreurs ou à surmonter sa peur de l’échec ou son désarroi face à des problèmes dont le sens lui échappe. Cette hypothèse de travail a amené les équipes Pépite et MICAME à collaborer. 1.3. Le projet Pépite-MICAME : objectifs et approche méthodologiqueL’objectif à moyen terme du projet est de créer un modèle permettant à un ACA d’établir un bilan de compétences avec un élève autour d’une réflexion sur les résultats de ce dernier au test de Pépite. Pour cela nous nous appuyons sur des analyses de corpus de dialogues entre humains. Même s’il est plus que probable que les élèves interagissent différemment avec un agent animé dans une application informatique et en tête-à-tête avec un enseignant humain, une étude des interactions verbales et non verbales dans des dyades enseignant – apprenant représente une source potentielle d’informations sur ces interactions pédagogiques que nous utilisons pour inspirer la spécification de cet agent animé pédagogique. D’une part, l’équipe du LINC utilise avec succès cette méthodologie pour modéliser l’expression des émotions et pour faire interpréter ces modèles par un agent virtuel (Martin et al., 2006), (Ochs et al., 2006), (Buisine et al., 2006). D’autre part, dans le projet Pépite, la méthodologie de recherche s’appuie sur des études de terrain (études de cahiers d’élèves, observation d’enseignants, suivi de cohortes d’élèves sur de longues périodes) et des études théoriques pour fonder des modélisations qui permettent la conception de systèmes informatiques. Les réalisations de ces systèmes obligent à une modélisation opérationnelle des phénomènes étudiés. Puis la mise à l’épreuve de ces systèmes dans des contextes d’utilisation réelle, permet de questionner les modélisations produites. Le positionnement méthodologique des deux équipes consiste ainsi à partir de situations de communication Humain/Humain qui sont modélisées pour spécifier, dans un premier temps, des systèmes informatiques. Dans un deuxième temps, des situations propres à la communication Humains/Machines peuvent être supportées à partir de ces premiers prototypes : par exemple, disposer de plusieurs agents (perturbateur, exigeant, conciliant, copain etc.). Dans la présente étude, notre objectif est double : 1) identifier des caractéristiques des interactions multimodales entre l’enseignant et l’élève dans cette situation de communication, en particulier concernant les manifestations d’émotions, 2) spécifier le comportement d’un agent pédagogique dans un contexte particulier. Nous cherchons à apporter des éléments de réponses aux questions suivantes : Quels sont les actes pédagogiques de l’enseignant ? Comment est-associé le verbal et le non-verbal ? Quelles sont les émotions exprimées par l’enseignant ? Comment sont-elles exprimées ? Dans cette optique nous avons utilisé l’approche méthodologique fondée sur des corpus vidéos numérisés (Bakeman et Gottman, 1997), (Montada, 2005). Le comportement multimodal est fonction du contexte et doit donc être étudié de manière située. Les approches de type corpus numériques visent à apporter des connaissances spécifiques et détaillées pour une situation donnée permettant de construire des modèles computationnels (Martin et al., 2006). La méthodologie générale consiste en la constitution d’un corpus d’interactions multimodales, la définition d’un schéma d’annotation, l’annotation du corpus, et l’analyse statistique des annotations. Les résultats de cette analyse permettent d’étudier le lien entre les expressions multimodales, les émotions des acteurs, les objectifs pédagogiques et le profil de l’élève. La section 2 de cet article présente l’environnement Pépite. La section 3 décrit la constitution du corpus vidéo d’interactions enseignants – apprenants et les choix que nous avons effectués dans nos objets d’étude pour faire face à la complexité des situations observées. La section 4 présente le schéma d’annotation que nous avons mis au point et décrit le travail d’annotation. La section 5 présente une analyse statistique du corpus annoté et discute les premières conclusions issues de ce travail en se focalisant sur les stratégies d’utilisation du regard de l’enseignant qui servent de support à la manifestation de ses sentiments. 2. L’environnement PépiteL’algèbre est un verrou d’accès à l’enseignement supérieur scientifique ; or, pour une grande majorité d’élèves, le passage de l’arithmétique à l’algèbre est un obstacle qui peut s’avérer infranchissable. De nombreuses études internationales se sont penchées sur cette question et des EIAH ont été conçus en vue de faciliter cet apprentissage −par exemple, (Nicaud et al., 2002). Dans ce cadre, le projet Pépite a pour objectif de fournir aux enseignants de mathématiques du secondaire un support logiciel pour gérer la diversité cognitive de leurs élèves relativement à l’apprentissage de l’algèbre. Ce projet s’appuie sur un travail en didactique des mathématiques (Grugeon, 1995) fondé sur une étude de cohortes d’élèves sur le long terme et une étude théorique croisant des approches didactique et épistémologique (Brousseau, 1986), (Douady, 1986), cognitive (Sfard, 1994), (Kerian, 1992), (Vergnaud, 1987), sémiotique (Duval, 1988) et anthropologique (Chevallard, 1992). La première étape de ce projet s’est intéressée à concevoir un outil de diagnostic papier-crayon (Grugeon, 1995) puis un logiciel, le logiciel Pépite, qui construit automatiquement un profil cognitif en algèbre d’un élève du secondaire à partir de ses réponses à un test spécialement conçu à cet effet (Jean-Daubias, 2002). La métaphore sous-jacente est de trouver dans les réponses de l’élève les « pépites » avec lesquelles construire des connaissances stables et valorisables (un « lingot »). L’originalité de ce système de diagnostic est de ne pas se contenter de relever les erreurs des élèves mais aussi de mettre en évidence des cohérences dans leur fonctionnement en algèbre. Certaines de ces cohérences sont intéressantes à développer, mais d’autres peuvent être de véritables obstacles pour la progression de l’élève, et il est indispensable de les repérer, puis, de les déstabiliser. Prenons un exemple : tous les enseignants constatent que de nombreux élèves se forgent des règles fausses (par exemple a + X = aX ou (a+b)² = a² + b²) ; or répéter la règle juste ne suffit pas à corriger cette erreur si l’élève n’a pas compris à quoi servent les lettres dans un calcul. Figure 1 : Réponse d’un élève à un exercice PépiTest Figure 2 : Extrait du profil d’un élève en algèbre produit par Pépite L’utilisation de Pépite comporte trois étapes. Les élèves passent d’abord un test avec le logiciel PépiTest qui recueille leurs réponses (Figure 1) Un module analyse automatiquement leurs réponses en leur associant un code sur plusieurs dimensions d’analyse. Enfin le logiciel PépiProfil effectue une analyse transversale des codes sur les différents types d’exercices et présente à l’enseignant un profil cognitif de chaque élève (Figure 2). . 3. Constitution du corpus vidéo de communication multimodale enseignant – apprenantAfin d’étudier le comportement d’un enseignant réfléchissant avec un élève sur ses résultats au test Pépite, un corpus vidéo a été collecté faisant intervenir huit élèves et deux enseignantes. Les élèves ont tout d’abord réalisé le test Pépite (qui s’effectue individuellement sur un ordinateur). Pour chaque élève, le profil cognitif produit par Pépite ainsi que l’ensemble des réponses de l’élève aux exercices ont été imprimés. Les enseignantes ont ensuite disposé de quelques jours afin de pouvoir étudier ces documents et se préparer aux entretiens individuels. Pendant le dialogue, les deux enseignantes ont soit annoté elles-mêmes, soit fait annoter par l’élève le document imprimé contenant les copies d’écran des exercices de Pépite avec les réponses de l’élève. Dans la suite nous appelons ce document « document de travail » car il est le principal objet partagé autour duquel la dyade interagit. Le profil cognitif de l’élève disponible sur écran ou sur papier constitue un second document auquel l’enseignant peut faire référence. 3.1. Dispositif d’enregistrementL’enseignant et l’élève sont assis à côté l’un de l’autre, face à une table basse sur laquelle les documents sont disposés. La hauteur de la table est un facteur important pour que les deux acteurs gardent l’entière liberté de leurs mouvements, au moins en ce qui concerne le haut du corps, ceci afin de ne pas contraindre l’utilisation de différents modes de communication. Cette situation d’entretien implique que l’enseignant et l’élève se positionnent naturellement légèrement tournés l’un vers l’autre. Deux caméras ont été utilisées, l’une positionnée dans l’axe de l’enseignant et l’autre dans l’axe de l’élève, formant un triangle à environ 60 degrés (Cf. Figure 3). Chaque caméra enregistre l’ensemble de la scène mais permet de capter efficacement les expressions faciales, le regard ainsi que les gestes et postures de la personne sur laquelle elle est axée. La hauteur des caméras a été réglée de manière à observer convenablement à la fois les expressions faciales des personnes filmées (y compris lorsque celles-ci regardent les documents imprimés posés sur la table basse), et, avec une précision suffisante, les endroits pointés sur les documents lorsqu’un geste déictique est utilisé. Le positionnement des caméras permet aussi de déterminer l’objet de focalisation du regard. Lorsqu’un acteur regarde un document posé sur la table basse, ce dispositif, bien entendu, ne permet pas de connaître l’élément scriptural précis sur lequel est focalisé le regard. Pour cela il serait nécessaire d’utiliser un dispositif d’oculométrie. Au stade exploratoire où se situe notre étude, une telle précision ne nous apparaît cependant pas nécessaire. Cette situation d’enregistrement a été préalablement mise au point au cours d’entretiens fictifs réalisés avec la participation d’étudiants de l’IUT de Montreuil. étant donné notre objectif d’analyse du comportement multimodal d’enseignants effectuant un retour individuel sur les résultats au test Pépite, ce sont les enregistrements de la caméra axée sur l’enseignant (caméra 1) qui ont été par la suite utilisés, les enregistrements de la seconde caméra ont été ponctuellement utilisés pour lever des ambiguïtés. Ces enregistrements sont aussi utilisés pour des études ultérieures sur l’interaction entre l’enseignant et l’élève, ou sur les réactions émotionnelles de l’élève aux actes pédagogiques de l’enseignant. 3.2. Sélection des donnéesUn travail préliminaire de visionnage a été effectué dans le but de repérer a priori, de manière informelle, des épisodes jugés particulièrement riches ou intéressants, d’une part en termes d’émotions et de communication multimodale et, d’autre part, en termes d’actes pédagogiques réalisés par l’enseignante. Ce travail a impliqué des chercheurs qui proviennent de plusieurs disciplines, notamment la didactique des mathématiques, l’informatique et les interfaces hommes-machines. Au niveau de l’expression d’émotions (Martin et al., 2005), le visionnage a priori a relevé des expressions de surprise, de doute, d’assentiment, mais ce qui domine est l’empathie manifestée envers l’élève par les deux enseignantes. Au niveau pédagogique, nous avons mis en évidence deux stratégies mises en œuvre par les enseignantes. La première que nous avons appelée « correction » consiste à relever une erreur et à la faire corriger par l’élève. La deuxième que nous avons appelée « bilan » consiste à prendre du recul par rapport aux réponses et à réfléchir sur les méthodes de résolution de l’élève ou sur les mathématiques ou sur l’enseignement des mathématiques. Notons que les parties correction et bilan ne sont pas nettement distinctes mais s’entrecroisent. Cette dernière stratégie qui s’appuie sur un discours méta de l’enseignant nous a donc semblé intéressante à étudier tant du point de vue didactique que du point de vue de l’expression multimodale et des émotions. En effet, c’est la partie où le visionnage a priori donne une grande impression d’empathie de l’enseignante envers l’élève, en particulier exprimée par son regard. Nous nous sommes donc, dans un premier, temps centrés sur cet aspect pour le travail présenté ici. Le regard est une modalité qui a plusieurs fonctions (Knapp et Hall, 2006) : réguler le flot de communication, contrôler le feedback, informer sur l’activité cognitive dont l’attention, exprimer des émotions, communiquer la nature de la relation interpersonnelle. Le regard fournit des informations (par exemple regard déictique vers un objet) mais sert aussi à récupérer des informations (par exemple pour vérifier l’attention de l’interlocuteur). Il est un élément essentiel de la synchronie interactionnelle (Cosnier, 1992), (Poggi et al., 2003). L’analyse de corpus étant un processus très coûteux en temps, nous nous sommes limités à l’étude de trois des huit enregistrements effectués. Nous avons écarté de notre étude la variable portant sur la différence entre les enseignantes car les effets de contexte étaient trop importants (e.g. contraintes d’emploi du temps des élèves et contrat didactique dans un cadre scolaire). Les trois vidéos retenues font intervenir une seule enseignante et trois élèves volontaires dans un contexte de soutien en dehors du cadre scolaire. Ces vidéos comprennent au total 39 parties bilan. Ces parties ont été sélectionnées par consensus au sein de l’équipe lors du visionnage a priori des différentes vidéo. La durée totale de ces parties bilan est de 54 minutes 21 secondes, comme le montre le tableau 1. Deux des élèves ont un niveau en algèbre que nous qualifions de faible. Le troisième est d’un niveau qualifié de élevé.

Tableau 1 : Parties bilan pour les vidéos sélectionnées et niveau des élèves 4. Annotation des vidéosLes unités d’observation correspondent au tour de parole de l’enseignant. 4.1. Schéma d’annotationDe nombreux schémas pour annoter manuellement des comportements observés ont été développés à différents niveaux, allant des signes physiques dans différentes modalités à des niveaux plus subjectifs liés à l’interprétation des messages, par exemple liés aux actes de dialogue ou aux émotions. Citons par exemple pour les gestes (Kipp, 2004), pour les actes de dialogue avec DAMSL (Core et Allen, 1997), pour l’expression multimodale d’émotions complexes (Martin et al., 2005) et pour les fonctions communicatives liées aux différentes phases de discours des enseignants (Paries, 2004). Poggi (Poggi, 2003) définit un comportement de communication par : - le groupe de fonctions communicatives auxquelles il appartient (par exemple gérer les tours de parole), - le sens de ce comportement dans ce groupe de fonctions communicatives (« donner le tour de parole »), - le signal ou les signaux associé(s) (regarder son interlocuteur, hausser les sourcils, arrêter de parler). Notre premier travail a consisté à mettre au point un schéma d’annotation sur plusieurs niveaux en tenant compte de nos objectifs de recherche, de l’étude de la littérature dans les domaines de la communication non verbale et de l’enseignement, ainsi que de l’analyse informelle des vidéos.. Les éléments annotés concernent en particulier : - Des intentions qui selon (Paries, 2004) visent deux objectifs : l’enrôlement que nous avons traduit par l’intention Animer, et le cognitif où nous distinguons l’apport d’information (Informer) et l’évaluation (Evaluer). Chacune de ces intentions est traduite en actes de langage généraux, par exemple, interroger ou bien résumer. Par exemple nous annotons:

- Des moyens linguistiques utilisés par l’enseignant. Nous n’analysons pas ici la signification des mots. Par exemple, la phrase « est-ce que c’est correct ? » est considérée tout simplement comme une question. - Des stratégies pédagogiques, par exemple :

- Des paramètres affectifs, par exemple :

Parallèlement, nous annotons des éléments de communication non verbale. Nous avons pour l’instant focalisé notre travail sur la direction du regard de l’enseignant. Le contexte expérimental induit quatre valeurs possibles. Dans un contexte d’entretien interpersonnel mettant en jeu des documents imprimés, les deux points principaux de focalisation du regard de l’enseignant sont, bien sûr, d’une part l’élève et, d’autre part, les documents (dans le contexte spécifique lié au logiciel Pépite, nous avons deux catégories de documents : le document de travail sur papier et le profil de l’élève sur l’écran). Il peut arriver cependant que l’enseignant ne dirige son regard ni sur l’élève ni sur les documents, mais regarde « ailleurs » ou bien « dans le vide ». Nous retenons donc pour la direction du regard de l’enseignant quatre valeurs d’annotation : élève, document de travail sur papier, profil de l’élève sur l’écran, ailleurs. 4.2. Travail d’annotationLes séquences sélectionnées (39 parties bilan pour une durée totale de 54 minutes 21 secondes) ont été annotées par le premier auteur avec le logiciel ANVIL4 (Kipp, 2004), selon le schéma d’annotation décrit dans la section précédente. Anvil est un logiciel (Figure 4) qui permet de réaliser une annotation manuelle selon un schéma structuré d’annotation. Les actes sont organisés dans des ensembles (groupes) et sous-ensembles (pistes). L’utilisateur délimite l’acte constaté sur la vidéo en précisant son début et sa fin, et il choisit l’étiquette correspondante dans le schéma d’annotation défini au préalable en XML.

Le temps de travail nécessaire pour annoter une minute de vidéo est variable selon la densité des annotations. La durée moyenne peut être estimée à une heure de travail d’annotation par minute de vidéo. Dans cette phase exploratoire, un test de qualité du codage a été effectué sur un extrait de trois minutes qui a été annoté par un autre membre de l’équipe. L’application du test statistique de l’accord interjuges Kappa proposée par (Cohen, 1960) a donné de très bons résultats. Ces derniers portent cependant sur un nombre d’annotateurs et une durée d’annotation insuffisants pour être significatifs. Dans une phase ultérieure, ces annotations pourront être validées avec plusieurs annotateurs et sur des durées d’enregistrement significatives. Dans un premier temps, elles nous servent à définir les valeurs initiales des paramètres spécifiant le comportement de l’agent. 5. Analyse des relations entre direction du regard et actes pédagogiquesDans cet article, nous nous focalisons sur l’étude du regard de l’enseignant. Le corpus annoté que nous avons constitué a fait l'objet d'une étude par analyse statistique des annotations. Les annotations sont stockées par ANVIL dans des fichiers XML. Nous avons développé en Java un programme prenant en entrée ces fichiers XML et permettant d'obtenir, d'une part des éléments statistiques de base concernant les annotations (nombres d'occurrences, durées moyennes, etc.) et, d'autre part, la probabilité de cooccurrence entre les types d’annotations et la direction du regard. Dans l'objectif de réalisation d'un agent pédagogique, ces données sont ultérieurement utilisées pour spécifier le comportement de l'agent. Ces valeurs définissent la probabilité avec laquelle l'agent dirige son regard vers l'un de ces quatre centres d'attention. Dans cette section, nous présentons les résultats obtenus et l’interprétation que nous en faisons. Nous distinguons deux grandes catégories d’annotations : d'une part, celles pour lesquelles les valeurs de cooccurrence obtenues restent stables d'un élève à un autre et, d'autre part, celles pour lesquelles ces valeurs varient de manière importante en fonction de l'élève. Les profils cognitifs des élèves produits par Pépite permettent de situer les élèves par rapport à la connaissance attendue à ce niveau scolaire en algèbre. Nous voulons étudier l’influence de ce niveau de compétence de l'élève sur ces différents comportements. L’étude de cet échantillon devra bien sûr être consolidée par une étude sur un panel d’élèves plus important. Le tableau 1 indique comment nous avons évalué ce niveau de façon grossière (faible, élevé) en fonction des profils cognitifs calculés par Pépite. 5.1. Annotations dont la corrélation avec la direction du regard est indépendante du niveau de l’élèveNous classons dans cette catégorie les annotations pour lesquelles les calculs statistiques donnent des résultats similaires pour les trois élèves étudiés. Le tableau 2 synthétise les résultats observés.

Tableau 2 : Corrélation types d’annotations – direction du regard dans les cas indépendants du niveau de l’élève Poser une question.Selon notre étude, lorsque l’enseignant pose une question, l’élève est le point de focalisation du regard avec une probabilité de seulement 0,4, contre 0,6 pour le support d’enseignement (document de travail ou profil de l’élève). D’un point de vue général, nous pourrions nous attendre à ce que, dans une situation de communication interpersonnelle, le locuteur regarde son interlocuteur lorsqu’il lui pose une question. Dans une situation de communication enseignant-élève avec support d’enseignement, il n’est cependant pas surprenant que ce dernier représente un point d’attention privilégié, spécialement en algèbre où la formulation numérique ou algébrique écrite est très présente et non ambigüe. Nous constatons que le temps d’attention visuelle portée sur les supports d’enseignement prend ici le pas sur celui où elle est portée sur l’élève. L’étude des annotations montre, de plus, que les questions posées à un élève sont souvent accompagnées de gestes déictiques par lesquels l’enseignant pointe des informations présentes sur le support d’enseignement. Un travail à venir pourra corréler ces gestes déictiques avec la direction du regard. Demander de faire.Sur cette annotation, notre étude montre une probabilité de regarder les documents supérieure à 0,8. Ces demandes ont, par exemple, pour objectif d’amener l’élève à reformuler, donner une explication, accomplir une tâche ou bien corriger une erreur. La probabilité élevée peut s’expliquer par la nécessité de bien cibler la tâche demandée et d’éviter toute incompréhension ou confusion. Ici encore, l’écriture mathématique sur le support d’enseignement joue en cela un rôle essentiel. Comme pour l’acte poser une question, cet acte de langage est souvent accompagné par un geste déictique vers le support d’enseignement. Rétablir la confiance après déstabilisation.Nos résultats statistiques montrent que l'enseignant regarde l'élève (probabilité de 0,65) plutôt que les supports (probabilité de 0,35). Lorsque ses points faibles, erreurs ou difficultés sont exposés, l’apprenant peut être déstabilisé et perdre confiance en lui. L’enseignant intervient alors pour rétablir cette confiance. Cela se fait le plus souvent en encourageant l’élève et en rappelant certains de ses points forts, réussites ou de ses qualités. La probabilité observée s'explique selon nous, par le besoin d'évaluer les réactions de l’élève et, en particulier, les émotions que celui-ci manifeste. L'enseignant oriente son discours en fonction de ce retour. Faire référence à une partie précédente.La probabilité de regarder les supports dépasse 0,8 lorsque l'enseignant fait référence à une partie précédente de la séance. L'enseignant regarde l'élève (probabilité inférieure à 0,2) dans le but de vérifier que celui-ci se rappelle bien la partie précédente en question. Cet acte de communication verbale consiste à lier entre elles deux parties de la séance et à montrer cette liaison à travers des informations recherchées sur les supports que l’enseignant feuillette (ou parcourt) pour revenir à la partie précédente (ou à l’écran précédent). Introduire une étape/envisager une étape.Ce type d’annotation intervient lorsque l’enseignant explique le déroulement de la séance (nous parlons d’étapes pour désigner des parties de la séance formant une entité du point de vue de la stratégie pédagogique suivie par l’enseignant). L'enseignant regarde les supports avec une probabilité de 0,8 dans le cas d'introduire une étape, et une probabilité légèrement inférieure à 0,7 dans le cas d'envisager une étape. L'enseignant, pour présenter à l'apprenant l'étape en question, s'appuie pour cela sur les supports ce qui explique ces probabilités élevées. Signaler un traitement incorrect/signaler un traitement correct.Il s’agit d’un résultat de validation ou bien d’invalidation d’une réponse de l’élève aux exercices. Selon notre étude, la probabilité que l’enseignant fixe son attention sur le support d’enseignement est très forte dans les deux cas. Cela peut s’expliquer par la nécessité de pointer, sur les réponses de l’élève aux exercices, la source de l’erreur ou bien l’exercice correctement traité. Nous observons cependant une nette variation : les chiffres obtenus sont, en effet, de 0,91 pour signaler un traitement incorrect et de 0,79 pour signaler un traitement correct. Nous pouvons supposer deux raisons à cela. D’une part, en cas de réussite l’enseignant encourage l’élève et, en l’encourageant, il le regarde. D’autre part, le cas d’un traitement incorrect nécessite de cerner et discuter l’origine de l’erreur, d’où un temps passé plus important sur le document de travail. Inciter à expliciter une connaissance.L'enseignant regarde les supports avec une probabilité de 0,87. Il doit en effet orienter l’apprenant en lui expliquant des connaissances connexes présentes sur les supports ou en lui montrant des mises en pratique de la connaissance à expliciter. L’enseignant regarde l’apprenant pour observer l'effet de son incitation sur l'élève. Cette interrogation visuelle peut avoir lieu au cours de l’incitation, auquel cas l'enseignant adapte son intervention en fonction du retour que ce regard lui apporte. Il se peut aussi que ce regard intervienne à la fin de l’incitation. Faire un rappel.La probabilité de regarder les supports est de 0,86. En général, l’objet du rappel est une connaissance déjà abordée, un savoir-faire pratiqué dans un exercice précédent, une information déjà citée pendant la séance. Les supports servent dans tous les cas de référence, ce qui explique la probabilité élevée de les regarder. Dans de rares cas, le regard est principalement adressé à l’élève. Il s'agit alors de rappels dont l’objet est une définition. Le regard de l’enseignant est toujours orienté vers l’apprenant en fin de rappel, afin d'évaluer le souvenir et la compréhension de l'élève sur l'élément rappelé. Comportement émotionnelNous avons mentionné que l’empathie de l’enseignant envers l’élève était omniprésente dans le corpus. Nous avons par ailleurs relevé des occurrences où l’enseignant manifeste la surprise. Nous obtenons une probabilité de 0,76 que cette émotion soit identifiable alors que l’enseignant regarde les supports. Suite à ce résultat nous pouvons formuler deux hypothèses. La première est que l’enseignant évite de se montrer dans une situation qui pourrait entraîner une certaine déstabilisation de l’apprenant. La deuxième hypothèse est que la source de ces manifestations de surprise provient des supports. Par exemple, l’enseignant peut relever une réponse incorrecte parmi les réponses de l’élève aux exercices alors qu’il considère que cette question relève de connaissances acquises par l’apprenant. 5.2. Annotations dont la corrélation avec la direction du regard dépend du niveau de l’élèveNous présentons ci-dessous des annotations pour lesquelles les calculs statistiques donnent des résultats similaires pour les deux élèves classés faibles, et différents pour l’élève classé fort. Le tableau 3 synthétise ces résultats.

Tableau 3 : Corrélation types d’annotations – direction du regard dans les cas dépendants du niveau de l’élève InformerDans le cas d'un élève faible, la probabilité pour que l’enseignant regarde l’élève est de 0,33. Au contraire, si l'élève est classé fort, cette probabilité s’élève à 0,67. Nous constatons donc qu'une partie du temps que l’enseignant passe à regarder les supports de l’élève faible est consacrée à regarder l’élève fort. Les élèves faibles ont souvent des difficultés à traduire en français des expressions mathématiques. Une interprétation possible est que l’enseignant appuie davantage son discours sur l’écrit pour donner des informations à un élève faible. RésumerLa probabilité de regarder un élève faible est de 0,46 contre 0,13 pour un élève fort. Lorsque l'enseignant résume le travail d’un élève faible, il prend soin de ne pas le démoraliser et tente au contraire de le motiver pour le travail à venir visant la mise en cause de ses erreurs. Nous constatons que, dans ce cas, l'enseignant consacre un temps presque égal aux supports sur lesquels se trouvent les informations à résumer, et à l'élève pour le motiver et pour vérifier qu’il suit bien l’intervention. ValoriserLa probabilité de regarder un élève faible est de 0,30 contre 0,49 pour un élève fort. Une interprétation possible est que les élèves plus faibles sont moins sûrs d’eux et ont plus de difficultés à soutenir le regard d’un adulte. L’enseignant peut regarder le support pour éviter de gêner l’élève. Une interprétation alternative est qu’il est difficile pour l’enseignant de trouver des arguments pour valoriser un élève faible et ne pas regarder l’élève traduit cette gêne. Dans le contexte de cette étude, ces premières analyses suggèrent que la gestion des tours de parole ne joue qu'un rôle secondaire dans la direction du regard de l'enseignant qui dépend surtout des actes pédagogiques et du niveau de l’élève. Ceci s'explique, d'une part par le fait que les parties étudiées de notre corpus (parties bilan) comportent peu d'interactions et, d'autre part, par le fait que le regard est ici utilisé pour diriger l'attention de l'apprenant vers des éléments importants des documents de travail. Cette première étude nous amène à envisager des analyses complémentaires pour suivre l’évolution temporelle du regard entre le début et la fin d’un acte (ou d’une séquence d’actes pédagogiques). 6. ConclusionCette étude exploratoire a pour objectif d’apporter des informations sur le comportement multimodal d’un enseignant dans une situation de diagnostic lors d’une interaction dyadique avec un élève en vue de spécifier le comportement d’un agent pédagogique animé. Nous avons mis en place une situation d’étude riche, qui nous a permis de recueillir un corpus vidéo conséquent. L’étude que nous présentons ici ne porte que sur trois des huit vidéos collectées et une seule des deux enseignantes filmées. Il s’agit donc d’une étude exploratoire dont l’objectif principal est de développer la méthodologie par analyse de corpus dans le contexte des agents pédagogiques animés et des EIAH. Nous utiliserons ce corpus et cette méthodologie d’une part pour affiner les premiers résultats présentés dans cet article et, d’autre part, pour des analyses complémentaires liées par exemple aux réactions émotionnelles de l’apprenant (afin d’étudier l’impact des actes pédagogiques de l’enseignant). Concernant notre première question de recherche sur les actes pédagogiques, à partir de travaux existants et du contexte particulier de notre situation, nous avons identifié les actes pédagogiques de l’enseignant dans cette situation. A partir de cette analyse et des travaux de l’équipe du LINC sur l’analyse d’expressions multimodales, nous avons mis au point un schéma d’annotation. Une partie du corpus a été annotée suivant ce schéma. Concernant la question du rapport entre le verbal et le non verbal dans une situation de diagnostic lors d’une interaction dyadique d’un enseignant avec un élève, nous nous sommes limités à l’étude des relations entre les actes pédagogiques et l’orientation du regard de l’enseignant entre l’élève et les deux documents (sur papier et sur écran) supports du diagnostic. Des calculs statistiques ont été appliqués sur les annotations. Ces premiers résultats suggèrent un lien entre la direction du regard et, d’une part, l’acte pédagogique et, d’autre part, le niveau de l’élève. De plus, ces statistiques nous permettent de définir des valeurs par défaut pour les paramètres spécifiant la direction du regard de l’APA entre l’apprenant et les documents sur lesquels repose le diagnostic. Concernant les émotions, toute l’attitude des élèves montre une charge émotionnelle très forte sur l’ensemble de la séance où l’image de l’adolescent est en jeu (au moins en tant qu’élève de mathématiques). L’enseignante que nous avons étudiée est une enseignante expérimentée qui ne manifeste ni colère, ni impatience, ni joie excessive, mais cherche à désamorcer la charge affective pour faire réfléchir l’élève sur ses forces et ses faiblesses et sur les attentes de l’institution. Notre étude ne permet donc pas de présenter un éventail large d’émotions. Cependant, elle suggère que certains comportements peuvent être des indicateurs d’émotion et que l’enseignante est très attentive à l’aspect affectif dans le rapport au savoir des élèves. Nous nous sommes ainsi centrés sur l’élément le plus frappant de notre corpus à savoir l’empathie exprimée par la direction du regard. Nous poursuivons l’étude de deux autres modalités : la déictique et le sourire en tant qu’indices pour déceler une émotion (par exemple éviter de regarder l’élève peut traduire une gêne). De plus, dans l’une des vidéos que nous avons laissée de côté une autre attitude est apparue : le jeu. L’enseignante donne des défis à un élève assez particulier et doté d’une forte personnalité. Elle le taquine lorsqu’il ne relève pas le défi et bien sûr le félicite quand il le relève. Cette attitude nous semble une perspective d’étude intéressante pour modéliser une des attitudes possibles d’un APA dans la stratégie de correction. A contrario, avec des élèves plus inhibés, la même enseignante, pressée par le temps ne réussit pas à établir le contact, et a ressenti cette séance comme un échec. Notre étude nous conforte dans l’hypothèse que la communication affective, qu'elle concerne les expressions d'émotions ou d'attitudes, est un facteur indispensable à prendre en compte dans l'enseignement. Un corpus comme celui que nous décrivons ici peut aider à terme à spécifier des agents pédagogiques animés ayant différents rôles ainsi qu'à étudier la manière dont la communication affective s'intègre à l'interaction enseignant - élève (Baylor et Ebbers, 2003). Cela nécessite la définition de schémas d’annotation adaptés à ce types de données pour représenter les états affectifs observés côté élève et côté enseignant, ainsi que l'expressivité des comportements associés (Martin, 2006). RemerciementsCe travail a été financé partiellement par l’Agence Universitaire de la Francophonie. Nous tenons à remercier Catherine Pelachaud, Marion Tellier, Mamadou Sanghare et Ibrahima Niang pour leurs précieux conseils, ainsi que les deux enseignantes et les huit élèves pour leur participation à la situation d’étude présentée ici. RéférencesBAKEMAN R., et GOTTMAN J. M., (1997). Observing Interaction. An introduction to sequential analysis. Second edition., Cambridge University Press 1997 BAYLOR, A. L. and EBBERS, S. (2003). Evidence that Multiple Agents Facilitate Greater Learning. International Artificial Intelligence in Education (AI-ED) Conference, Sydney, Australia. BROUSSEAU G (1986) : Fondements et méthodes de la didactique. Recherches en Didactique des Mathématiques, Vol 7.2, p. 33-116, Editions La Pensée Sauvage. BUISINE S. (2005). Conception et Évaluation d'Agents Conversationnels Multimodaux Bidirectionnels. http://stephanie.buisine.free.fr/, Doctorat de Psychologie Cognitive - Ergonomie, Paris V. 8 avril 2005. Direction J.-C. Martin & J.-C. Sperandio. http://stephanie.buisine.free.fr/ BUISINE S., et MARTIN J.-C. (2006). L’étude de Corpus par Analyse en Composantes Principales. In Second Workshop sur les Agents Conversationnels Animés (WACA). BUISINE S., HARTMANN B., MANCINI M., PELACHAUD C. (2006), Conception et Evaluation d'un Modèle d'Expressivité pour les Gestes des Agents Conversationnels, Revue d’Intelligence Artificielle RIA, Special Edition “Interaction Emotionnelle”, vol. 20, N. 4-5, 2006 BULL, S. et KAY J. (2005). A Framework for Designing and Analysing Open Learner Modelling, Proceedings of Workshop on Learner Modelling for Reflection,International Conference on Artificial Intelligence in Education, Amsterdam, p. 81-90. CASSELL J., SULLIVAN J., PREVOST S. and CHURCHILL E. (2000). Embodied Conversational Agents, MIT Press. CHEVALLARD Y. (1992) : Concepts fondamentaux de la didactique : perspectives apportées par une approche anthropologique. Recherches en Didactique des Mathématiques, Vol 12.1, p. 73-111, Editions La Pensée Sauvage. COHEN J., (1960). A coefficient of agreement for nominal scales”, Educ. Psychol. Meas.: 20, p. 27-46. CORE M. G. and ALLEN J. F. (1997). Coding Dialogues with the DAMSL Annotation Scheme. AAAI Fall Symposium on Communicative Action in Humans and Machines, Menlo Park, California,American Association for Artificial Intelligence. citeseer.ist.psu.edu/ core97 coding. html COSNIER J. (1992). Synchronisation et copilotage de l'interaction conversationnelle. In revue Protée, p. 33-39. DEHN D. M. and VAN MULKEN S. (2000). The impact of animated interface agents: a review of empirical research, International Journal of Human-Computer Studies, (52): p. 1-22. DELOZANNE, E., PREVIT, D., GRUGEON, B., JACOBONI, P. (2003). Supporting teachers when diagnosing their students in algebra, Workshop Advanced Technologies for Mathematics Education, supplementary Proceedings of Artificial Intelligence in Education, Sydney, IOS Press, Amsterdam, p. 461-470. DOUADY R. (1986) : Jeux de cadres et dialectique outil/objet, Recherches en Didactique des Mathématiques, Vol 7.2, p. 5-32, Editions La Pensée Sauvage. DU BOULAY B., et LUCKIN R., (2001). Modelling Human Teaching Tactics and Strategies for Tutoring Systems. International Journal of Artificial Intelligence in Education, 12, p. 235-256. DUVAL R. (1988) : Ecarts sémantiques et cohérence mathématique : introduction aux problèmes de congruence. Annales de Didactique et de Sciences Cognitives, Vol. 1, p. 7-26, IREM de Strasbourg. GRUGEON B. (1995) Etude des rapports institutionnels et des rapports personnels des élèves à l’algèbre élémentaire dans la transition entre deux cycles d’enseignement : BEP et Première G, thèse de doctorat, Université Paris VII. HARRIGAN J. A., ROSENTHAL R. and SCHERER K. (2005). The new handbook of methods in nonverbal behavior research, Oxford University Press. JEAN-DUBAIS S. (2002), Un système d'assistance au diagnostic de compétences en algèbre élémentaire, Revue Sciences et techniques éducatives, Hermès, Vol.9 - n°1-2/2002, p. 171-200. JOHNSON W. L., RICKEL J. W. and LESTER J. C. (2000). "Animated Pedagogical Agents: Face-to-Face Interaction in Interactive Learning Environments." International Journal of Artificial Intelligence in Education 11: p. 47-78. KAY J., (2000) Stereotypes, Student Models and Scrutability, Intelligent Tutoring Systems, Springer. KATZ S., ALLBRITTON D., CONNELLY J., (2003) Going Beyond the Problem Given: How Human Tutors Use Post-Solution Discussions to Support Transfer, IJAIED, vol 13, p.79-116 KIPP M. (2004). Gesture Generation by Imitation. From

Human Behavior to Computer Character Animation. Florida, Boca Raton,

Dissertation.com. KNAPP M. L. and HALL J. A. (2006). Nonverbal communication in human interaction. Sixth edition, Thomson Wadsworth. LANDIS J. R., et KOCH G. G., (1977). The measurement of observer agreement for categorical data. Biometrics 33: p.159–174. MARTIN, J. C. (2006). Multimodal Human-Computer Interfaces and Individual Differences. Annotation, perception, representation and generation of situated multimodal behaviors. Habilitation à diriger des recherches en Informatique. Université Paris XI. MARTIN J.-C., ABRILIAN S. and DEVILLIERS L. (2005). Annotating Multimodal Behaviors Occurring during Non Basic Emotions. 1st Int. Conf. Affective Computing and Intelligent Interaction (ACII'2005), Beijing, China, Spinger-Verlag Berlin. MARTIN J.-C., KUHNLEIN P., PAGGIO P., STIEFELHAGEN R. and PIANESI F. (2006). Workshop "Multimodal Corpora: from Multimodal Behaviour Theories to Usable Models ". In Association with the 5th International Conference on Language Resources and Evaluation (LREC2006), Genoa, Italy. http://www.limsi.fr/Individu/martin/tmp/LREC2006/WS-MM/final/proceedings-WS-MultimodalCorpora-v3.pdf MONTADA L. (2005). Video analysis and the interactional relevance of bodily details. Panel presentation. "Interacting Bodies", 2nd ISGS Conference, Lyon, France, ENS LSH. http://gesture-lyon2005.ens-lsh.fr/ NICAUD J.-F., DELOZANNE É., GRUGEON B. (éditeurs) (2002) numéro spécial Environnements informatiques d'apprentissage de l'algèbre , Revue Sciences et Techniques éducatives, volume 9-n°1-2/2002, Hermès. OCHS M., NIEWIADOMSKI R. R., PELACHAUD C., SADEK D.(2006) Expressions Intelligentes des Emotions, Revue d’Intelligence Artificielle RIA, Special Edition “Interaction Emotionnelle”, vol. 20, N. 4-5, 2006. PARIES C. M., (2004). Comparaison de pratiques d'enseignants de mathématiques relations entre discours des professeurs et activités potentielles des élèves. In Recherches en didactique des mathématiques : vol. 24, no2-3, p. 251-284. POGGI I. (2003). Mind Markers. Gestures. Meaning and Use. M. Rector, I. Poggi and N. Trigo. Oporto, Portugal University Fernando Pessoa Press: p.119-132. POGGI I., MEROLA G. and LIBERATI F. (2003). The teacher's gaze. ECFE'2003. RETY J.-H., MARTIN J.-C., PELACHAUD C. et BENSIMON N. (2003) Coopération entre un hypermédia adaptatif éducatif et un agent pédagogique. Proceedings of H2PTM'2003, Hermès, P aris, p. 24-26, RICHMOND V. P. et CROSKEY J. C.(2004) Non Verbal Behavior in Interpersonal relations. Fith Edition., Pearson Education Inc. SFARD A. et LINCHEVSKI L. (1994) : The gains and the pitfalls of reification -- The case of algebra, Educational Studies in Mathematics, Vol. 26, p. 191-228. VERGNAUD G., CORTES A., FAVRE-ARTIGUE P. (1987) : Introduction de l'algèbre auprès de débutants faibles. Problèmes épistémologiques et didactiques in Actes du colloque de Sèvres : Didactique et acquisition des connaissances scientifiques, p. 259-288, Editions La Pensée Sauvage. VINCENT C., DELOZANNE E., GRUGEON B., GELIS J.-M., ROGALSKI J., COULAGNE L.(2005) Des erreurs aux stéréotypes : Des modèles cognitifs de différents niveaux dans le projet Pépite, Actes de la conférence EIAH2005, Environnements Informatiques pour l'apprentissage humain, Montpellier, INRP, p. 297-308.

1 AIDA (Approche Interdisciplinaire pour les Dispositifs Informatisés d’Apprentissage) est un plan pluriannuel de formation regroupant plusieurs équipes de recherche en EIAH de la région parisienne dont le LINC, le CRIP5 et Didirem. 2 http://www.iut.univ-paris8.fr//Accueil/Recherche/TechnoCom/MICAME 3 http://pepite.univ-lemans.fr/ 4 http://www.dfki.de/~kipp/anvil/

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

Référence de l'article :Mohamedade FAROUK, Jean-Hugues RETY, Elisabeth DELOZANNE, Brigitte GRUGEON, Nelly BENSIMON, Jean-Claude MARTIN, Stratégies d'utilisation de la direction du regard en situation de communication interpersonnelle enseignant-élève, Revue STICEF, Volume 14, 2007, ISSN : 1764-7223, mis en ligne le 27/02/2008, http://sticef.org |

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||