Sciences et Technologies

Sciences et Technologiesde l´Information et

de la Communication pour

l´Éducation et la Formation

version à télécharger (pdf)

Volume 14, 2007

Article de recherche

|

Contact : infos@sticef.org |

Recueil de traces pour le suivi de l'activité d'apprenants en travaux pratiques dans un environnement de réalité virtuelle.

Agnès LE

PALLEC**

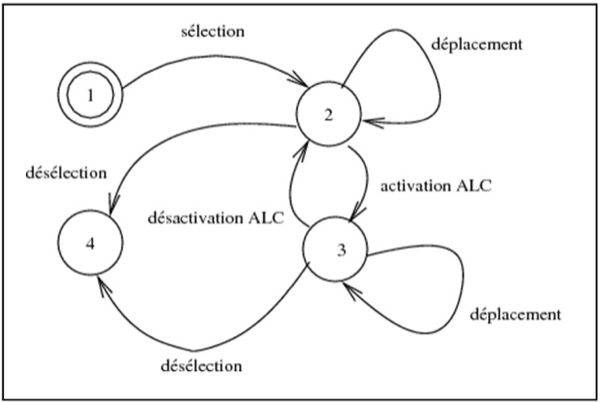

1. IntroductionLe travail présenté dans cet article s’inscrit dans un projet de création d’une paillasse virtuelle destinée à mettre en place des travaux pratiques scientifiques. Cette paillasse a pour vocation d’être utilisée dans le contexte classique des travaux pratiques. L’objectif du projet est de favoriser les apprentissages en utilisant les potentialités de la réalité virtuelle et des systèmes tutoriels autonomes (Buche et al., 2004b), tout en conservant la nature manipulatoire et expérimentale d’un travail guidé. L’étudiant est immergé dans un monde virtuel ; il peut manipuler des objets dans un contexte proche de la réalité en utilisant des interfaces motrices adaptées. La conception d’un tel Environnement Virtuel d’Apprentissage Humain (EVAH) nécessite de prendre en compte les spécificités des activités de travaux pratiques et de la réalité virtuelle. L’objectif de cet article est, d’une part de définir la nature des traces d’interaction dans un environnement virtuel afin de les recueillir de manière contrôlée et automatique, et d’autre part d’évaluer en quoi elles fournissent des éléments pertinents d’analyse de l’activité des apprenants. La problématique du recueil des traces est double : des traces pour qui ? et pour faire quoi ? Si les traces sont destinées à un enseignant, celui-ci cherche à savoir si l’activité proposée est réussie, ou bien à repérer où sont les difficultés des apprenants (Héraud et al., 2005). Si ces traces sont destinées à l’apprenant, c’est pour qu’il puisse visualiser son activité (Katz et al., 1992) et détecter des informations signifiantes pour lui (Ollagnier–Beldame, 2006). Si ces traces sont utilisées par un chercheur en didactique, c’est pour analyser l’activité des apprenants afin de la modéliser et d’améliorer l’efficacité de l’apprentissage. C’est ce point de vue du chercheur en didactique qui nous intéresse ici. La formalisation des traces d’utilisation repose sur deux composantes de l’EVAH MASCARET : les modèles d’environnement (VEHA) et d’activités (HAVE). Ces modèles permettent de formaliser la nature des observables qui constituent ces traces, leur production étant assurée par un agent artificiel. Les traces recueillies doivent décrire les activités effectives des apprenants, que ce soit en termes de procédures opératoires ou bien de recherches d’information (Tricot, 2003). Grâce à ces traces, le chercheur en didactique peut suivre et analyser l’utilisation de ressources spécifiques dans l’environnement virtuel. Il peut également chercher à reconnaître la réalisation de plans d’actions, à identifier des situations prototypiques. Dans la partie 2 de l’article nous faisons un état des lieux des questions posées par les chercheurs en didactique concernant les travaux pratiques et nous précisions les caractéristiques des TP classiques qui nous concernent ici. Nous identifions également les particularités des interactions en réalité virtuelle et la nature des traces dans ce double contexte. En partie 3, nous définissons les différents types de données observables dans MASCARET. Afin d’évaluer la pertinence de nos traces, nous avons mené une expérimentation dont les résultats sont présentés et analysés en partie 4. Elle a porté sur l’analyse de l’activité d’apprenants, manipulant seuls, dans l’environnement. 2. Description des activités de travaux pratiques en réalité virtuelle2.1. Les travaux pratiques en scienceClassiquement, les apprenants manipulent debout, le matériel est déjà installé sur une paillasse et les apprenants peuvent se déplacer face au matériel (rarement derrière). Ils disposent d’un protocole expérimental écrit, ont à faire des mesures et à tirer des conclusions à partir des valeurs des mesures obtenues. Les mesures sont à faire en temps limité. Un enseignant vérifie l’activité des apprenants et répond à leurs questions. Les étudiants apprennent des méthodes, des procédures de mesures et des démarches en prenant comme situation de référence, celle du laboratoire. Cet apprentissage se fait par l'action et par l'exemple, en suivant des consignes opératoires. Ce type de situation d'apprentissage classique favorise l’utilisation de connaissances prototypiques construites en référence aux activités antérieures (Beney et Séré, 2001). 2.2. Les traces d’activité en travaux pratiquesIl y a plusieurs problématiques concernant le recueil des traces pour des activités expérimentales en sciences. Le chercheur peut vouloir se servir de traces pour tester l’efficacité du guidage proposé en terme d'apprentissage (Beney et Guinard, 2004), étudier les activités d'apprentissage (Séjourné et Tiberghien, 2001), mettre en évidence le type de raisonnement des apprenants (Bécu-Robinault, 1997), (Reyde et Leach, 1999) ou pour caractériser les connaissances spécifiques qu’ils se construisent (Pateyron, 1997). Il peut vouloir décrire les activités des apprenants afin de les caractériser (difficultés, modes de raisonnement) soit dans un environnement naturel, soit en mettant en place des situations ad hoc (Vince, 2000). Pour toutes ces situations, les traces recueillies sont de nature différente. Elles ne prennent sens que mises en perspective avec les tâches à accomplir, les apprentissages visés et les difficultés des apprenants. Les traces que le chercheur utilise sont issues d’observations en temps réel sous forme d’enregistrements vidéo ou audio, ou d’observations en différé par rapport à l’activité, sous forme d’entretiens d’explicitation de l’activité ou de réponses à des questionnaires (Dimitracopoulou et al., 2005). Une première difficulté réside dans l’analyse des enregistrements, souvent fastidieuse (allers-retours fréquents sur les enregistrements). Une seconde difficulté concerne la comparaison des actions des nombreux sujets à partir d'observables variés et pas toujours pertinents. Par ailleurs l’analyse reste subjective et repose sur une interprétation des données d’observation par le chercheur. Dans l’observation des manipulations qu’effectue l’apprenant, le chercheur s’attache à repérer des associations de deux ou plusieurs actions qui deviennent significatives de son point de vue, car indicatrices d’une solution en germe. Il ne tient donc pas compte d’hésitations dans les déplacements d’objets, il ne s’arrête pas aux paramètres gestuels, mais infère un sens aux manipulations qu’il observe. 2.3. Les interactions en réalité virtuelleLa réalité virtuelle offre un grand nombre de possibilités pour réaliser l’interfaçage comportemental d’un utilisateur avec un monde virtuel (Fuchs, 1996). En conséquence, les traces d’utilisation peuvent être de nature très diverse. Potentiellement, l’utilisateur peut exercer une commande motrice en utilisant différents types de périphériques auxquels sont associés un grand nombre de variables. Outre les classiques claviers et souris, il existe divers systèmes de pointage, de déplacement et de manipulation. Un dispositif tel qu’une souris 3D (spacemouse) offre 6 degrés de liberté pour les déplacements : elle fournit une information de localisation (en 3 dimensions) et d’orientation (selon 3 axes). Les dispositifs haptiques fournissent en plus, une information sur la force exercée par l’utilisateur. Un gant de données permet d’obtenir des informations sur la préhension d’objets. Des périphériques dotés d’accéléromètres (tel que la Nintendo Wiimote) peuvent donner des informations sur le mouvement dans l’espace. Dans les environnements immersifs où l’utilisateur est représenté sous forme d’un mannequin, celui-ci peut être équipé d’un système de suivi de mouvement qui permet de connaître la position et l’orientation de sa tête et de certains segments de son corps (membres, épaules, bassin...). En règle générale, lorsque l’on conçoit un environnement virtuel, on cherche à offrir à l’utilisateur une interface sensori-motrice aussi naturelle que possible, de façon à ce qu’il utilise des schèmes comportementaux importés du monde réel. Ceci parce que la boucle sensori-motrice est souvent biaisée par les limites technologiques des dispositifs d’interface. Cependant, pour différentes raisons, il est parfois impossible de mettre en œuvre ces schèmes et il faut donc introduire des artifices pour réaliser l’interfaçage comportemental. Une première catégorie d’artifices est celle des métaphores d’interaction qui consistent à proposer une représentation symbolique de l’action. Par exemple, l’utilisateur pourra simplement cliquer sur un robinet pour remplir un récipient placé sous celui-ci ; pour vider le récipient, il devra le faire pivoter au-dessus d’un objet évier. Dans un EVAH, il est intéressant de pouvoir faire varier les modalités de réalisation d’une manipulation : lorsque l’apprenant est peu familiarisé avec l’environnement (ou lorsque l’apprentissage n’est pas concerné par ces modalités), il est possible de simplifier la manipulation en recourant à des Aides Logicielles Comportementales, ALC (Fuchs, 2006). L’aide peut être de nature sensori-motrice ou cognitive. Les ALC sensori-motrices ont pour objectif de pallier les défauts des dispositifs technologiques d’interface. Par exemple, le signal issu d’un dispositif de navigation avec capteurs d’orientation doit être filtré afin de ne pas provoquer de déplacement lorsqu’il est au voisinage de la position neutre. Les Aides Logicielles Comportementales cognitives les plus utilisées concernent la navigation dans l’environnement et le placement d’objets. Dans le premier cas, les trajectoires possibles (ou des points de passage) sont prédéfinies et contraignent le déplacement de l’utilisateur. Dans le second cas, on simule une sorte de "magnétisme" entre les objets qui fait que, lorsqu’un objet est placé à proximité d’un autre, il est automatiquement placé et orienté comme il se doit. La définition des aides cognitives repose donc sur une hypothèse de l’intention de l’utilisateur. 2.4. Les traces de l’activité dans un EVAHLes choix sur l’interfaçage comportemental conditionnent, bien entendu, la nature des traces d’utilisation en réalité virtuelle. Leur interprétation doit se faire en connaissance des choix de conception de l’environnement de réalité virtuelle. L’information portée par une trace doit donc exprimer la nature de l’interaction. Il y a, à la fois des données sur la commande motrice, par exemple sur l’utilisation d’un dispositif de pointage avec ses coordonnées, et des données sur la fonction qui lui a été allouée lors de la conception du mode d’interaction avec le monde virtuel. En définissant une trace d’utilisation comme toute information permettant de suivre et comprendre l’activité d’un apprenant, on regroupe sous ce terme une grande variété d’informations spécifiques à la réalité virtuelle : commandes motrices des utilisateurs (associées aux informations sur l’interaction), retours sensoriels et conséquences – directes ou indirectes – des actions des utilisateurs. Les traces que l’on peut enregistrer automatiquement dans un système de réalité virtuelle se présentent donc sous deux formes. Il s’agit, soit d’enregistrement d’évènements informés, soit de vidéogrammes correspondant au rendu visuel et sonore dans l’environnement. Les vidéogrammes peuvent être enregistrés selon divers points de vue comme par exemple ce que perçoit l’apprenant, ce que voit le formateur ou une vue globale de l’environnement. 3. MASCARETMASCARET (Multi-Agent System for Collaborative, Adaptive and Realistic Environment for Training) est un environnement virtuel pour l’apprentissage humain développé au CERV, Centre Européen de Réalité Virtuelle, (Buche et al., 2004b). Il s’agit d’une plate-forme logicielle permettant à plusieurs utilisateurs, apprenants et formateurs, d’agir ensemble dans un environnement virtuel. Cette plate-forme offre les fonctions d’un système tuteur intelligent. Toute entité active dans l’environnement est considérée comme un agent, c’est-à-dire une entité capable de percevoir son environnement local, de choisir une action adaptée, éventuellement guidée par un but explicite (principe de rationalité) et d’agir en conséquence par le biais d’interactions avec l’environnement ou d’autres agents. Les agents sont donc de diverses natures. Il s’agit tout d’abord des entités représentées dans le monde virtuel et exhibant un comportement autonome (non commandé par une autre entité). Les utilisateurs sont eux-mêmes considérés comme des agents ; ils exercent une activité orientée vers un but et interagissent entre eux, via l’environnement virtuel. Leur activité peut éventuellement être de nature collaborative, ainsi que la stratégie pédagogique. Enfin la fonction de tuteur est assurée par des agents pédagogiques. Dans cet article, nous n’exploitons que partiellement la plate-forme Mascaret puisque nous n’utilisons pas ses potentialités adaptatives et que nous ne nous intéressons pas à la collaboration entre utilisateurs. MASCARET dispose d’une fonction de suivi de l’activité des utilisateurs, apprenants et formateurs, et plus généralement de tout agent de l’environnement. Elle est assurée par des agents pédagogiques particuliers jouant le rôle d’"observateurs". L’analyse de l’activité peut être conduite en ligne (par le biais d’un agent pédagogique) ou hors ligne (fichier de log en XML). Ce mécanisme de suivi a été conçu de façon à être indépendant du domaine d’apprentissage et de la stratégie pédagogique. L’interprétation des traces, qui dépend nécessairement du contexte pédagogique, n’est pas assurée, pour l’instant, par un agent artificiel. L’intérêt de MASCARET est qu’il repose sur un méta-modèle formel de l’environnement et des activités, et que tous les objets, actions et évènements du monde virtuel sont réifiés. Deux sous-systèmes de MASCARET servent de support à la détection des traces d’utilisation : VEHA et HAVE ; ils sont décrits dans la suite. VEHA (pour Virtual Environment supporting Human Activities) est un méta-modèle d’environnement virtuel informé et structuré ; il sert à la description du monde virtuel dans lequel l’apprenant réalise sa tâche. HAVE (pour Human Activities in a Virtual Environment) est le pendant de VEHA qui décrit les activités réalisées, ou potentiellement réalisables, par un humain dans un monde virtuel décrit avec VEHA. Ces méta-modèles sont des extensions du méta-modèle UML 2 (Unified Modelling Language) dont la vocation première est la modélisation de logiciels (Booch et al., 2005) mais qui a aussi été utilisé comme langage de description d’ontologies (Cranefield et Purvis, 1999). Le choix d’UML est motivé par ses propriétés de langage de description de données, support à la description de connaissances, et sa sémantique opérationnelle qui permet de décrire une exécution du modèle. Dans MASCARET, le monde virtuel est donc entièrement décrit selon le méta-modèle VEHA ; il s’agit d’un environnement informé en ce sens qu’il est sa propre description sémantique. L’environnement est géométriquement et logiquement structuré. Il s’agit d’un monde tridimensionnel composé d’objets identifiables sur lequel il est possible de définir des relations topologiques. Le comportement des entités qui composent ce monde, ainsi que le résultat des actions des agents artificiels et humains qui agissent dans ce monde, sont aussi décrits en utilisant VEHA. La réalisation des actions et leur organisation en activités sont définies avec HAVE. Les sections qui suivent décrivent les éléments de VEHA et HAVE qui sont utilisés pour l’observation et l’analyse des traces d’utilisation dans MASCARET. 3.1. Le modèle d’environnement virtuel structuré et informé VEHALe modèle VEHA de MASCARET permet de modéliser les objets qui constituent l’environnement physique de l’apprenant. Ce modèle fournit une description de la composition de cet environnement ainsi que des comportements. Il offre donc à la fois une vue statique et dynamique de l’environnement d’apprentissage. Ce monde est considéré comme discret : il est composé d’objets identifiables et leur évolution se fait par des changements instantanés d’état. 3.1.1. La vue statique de l’environnementUn monde VEHA est composé d’entités spatialement localisées et éventuellement interconnectées. Les entités peuvent être typées : on utilise pour cela la notion de classe d’UML. Une classe définit les propriétés communes à toutes les entités qui en sont des instances. Les propriétés des entités sont, soit de nature statique, soit de nature comportementale. Les propriétés statiques sont des attributs ayant des valeurs numériques ou symboliques, des états ou des associations possibles vers d’autres types d’entités. L’existence de relations entre entités permet de propager l’effet d’une action sur un objet à d’autres objets. Cela permet aussi de définir des entités composées de différentes parties et donc d’obtenir des informations à la fois sur les parties et sur le tout. La manipulation d’un objet VEHA peut se faire par l’intermédiaire d’une "poignée virtuelle" à l’instar des "smart objects" (Kallmann et Thalmann, 1998). Une poignée est un médiateur d’interaction (on lui associe une méthode pour interagir avec l’objet). L’existence de ces poignées permet de savoir comment un objet à été manipulé : a-t-il été pris par le dessus ou poussé par un de ses côtés ? Une poignée peut également contraindre les modalités de l’interaction avec l’objet, en particulier en définissant des niveaux de détail dans le geste à réaliser pour manipuler l’objet. Elle fournit donc une information sémantique sur une manipulation comme ouvrir une porte avec une poignée, complétée éventuellement sur un mode opératoire (utilisation ou non d’une aide logicielle comportementale) : positionnement approximatif de la "main" de l’utilisateur à proximité ou réalisation d’un geste de préhension puis d’une rotation. Les entités sont géographiquement référencées, selon deux systèmes qui se complètent sémantiquement. Le premier associe à chaque objet une position et une orientation dans un repère global ; la position d’une entité est un point de l’espace et son orientation est une base de trois vecteurs. Cette information est utilisée pour observer des déplacements d’objet (translations et rotations). La notion de localisation est complétée par la notion de zone de l’espace : il est ainsi possible d’exprimer qu’une entité est située dans une zone donnée, ce qui permet de contrôler qu’un objet a été placé au "bon endroit", même si ce positionnement est approximatif (par exemple. "sur la table"). Enfin les entités ont une forme géométrique tridimensionnelle ce qui permet de raisonner sur la proximité de deux objets, sur l’occurrence d’éventuelles collisions ou l’inclusion d’objets (par exemple "un cube dans une boîte"). 3.1.2. La vue dynamique de l’environnementClassiquement un environnement est composé d’entités inertes et d’entités pouvant exhiber un comportement. Ce comportement peut être lié à une évolution interne, autonome, de l’entité, mais le plus souvent, il est provoqué par l’occurrence d’une perturbation de l’environnement à laquelle réagit l’entité. Le comportement est alors réactif, de type stimulus - réponse. Ceci est modélisé dans VEHA en utilisant un sous-ensemble des machines à états d’UML et la notion de signal. Il est possible que le comportement d’une entité influence celui d’autres entités. Ceci est simulé par la synchronisation des machines à états des différentes entités réactives (Chevaillier et al., 1999). Avec VEHA, tous les changements d’état sont donc observables ; si un tel changement d’état est la conséquence – indirecte – de l’action d’un apprenant, il est intéressant de pouvoir l’enregistrer. Certaines actions de l’apprenant se traduisent par le déclenchement d’une opération sur un objet, spécialement lorsque l’on a recours à des métaphores d’interaction. L’exécution d’une opération est un type d’évènement observable en VEHA. L’information qui lui est associée est le déclencheur de l’opération, l’objet sur lequel elle porte et les paramètres de son exécution. 3.2. Le modèle des activités HAVELe modèle HAVE de MASCARET décrit les activités d’un collectif d’agents. Ces agents représentent des acteurs humains ou des personnages artificiels (humains virtuels). Le modèle des activités est supporté par une modélisation de la structure organisationnelle de ce collectif. Le modèle organisationnel permet de définir le rôle des agents au sein du collectif. Comme dans MOISE (Hübner et al., 2002), la description abstraite du collectif est nommée "structure organisationnelle" et une réalisation concrète "entité organisationnelle". Cette notion est fondamentale dans un EVAH collaboratif car il est essentiel dans l’analyse des traces de savoir quel rôle est alloué à l’utilisateur ayant produit un observable. Dans HAVE, les activités sont décrites comme un ensemble d’actions à réaliser par une structure organisationnelle afin d’atteindre un objectif. Par exemple, une séance pédagogique est structurée en exercices dont la réalisation est décrite sous forme d’un modèle des activités qui précise les actions de chacun des agents en fonction de leur rôle. Ceci permet de spécifier la tâche que doit réaliser l’apprenant au cours de chaque exercice. Les activités sont décrites sous forme d’enchaînements possibles d’actions ; on parle alors de description procédurale. La prise de rôle et, symétriquement, son abandon est un évènement observable, de même que le démarrage et la fin d’une activité. Une action est définie par des conditions de faisabilité et des effets attendus ; ces conditions sont formalisées sous forme d’expressions logiques sur les entités VEHA qui composent l’environnement des agents. La réalisation d’une action peut à son tour être décrite comme une séquence d’opérations à réaliser. Ces dernières correspondent à l’atome de la description d’une activité. Aucune information n’est donc directement observable sur leur déroulement. Il est cependant possible d’observer le résultat de l’exécution d’une opération. Comme cela a été évoqué en 2.3, l’identification des actions de l’utilisateur est complexe en réalité virtuelle. Tout d’abord, il faut formaliser la manière dont sont supportées les interactions. Ensuite, il faut tenir compte du fait qu’une action est réalisée par une série de commandes motrices et qu’elle est éventuellement assistée d’une aide logicielle comportementale. La reconnaissance d’une action nécessite donc d’identifier ces séquences qui sont formalisables sous forme d’automates (cf. Figure 1). Les actions peuvent ensuite être catégorisées en utilisant le concept de "Primitive Comportementale Virtuelle" (PCV) introduit par Fuchs. Les actions des utilisateurs peuvent ainsi être class&ea(Burkhardt et al., 2003)es (Burkhardt et al., 2003) : (i) observation, (ii) déplacement, (iii) manipulation d’objet et (iv) communication (avec le système ou un autre agent).

3.3. Les agentsLes traces de l’activité des agents qui sont toujours identifiables, sont leurs interactions avec l’environnement et les autres agents. Leur processus interne de décision est par essence non observable. L’interaction avec les objets du monde a été envisagée précédemment. Les actions de communication liées à l’activité de l’apprenant correspondent à leurs échanges avec les autres utilisateurs (apprenant et formateur), avec des personnages de l’environnement virtuel ou avec des agents pédagogiques. Dans MASCARET, toutes les communications avec le système sont réalisées par des échanges de messages entre agents et sont donc potentiellement observables. Prenons l’exemple de la situation dans laquelle l’apprenant pose une question au formateur. Cette question est formulée sous forme linguistique dont le medium peut être la voix ou le texte. Dans MASCARET, cette communication est supportée par un échange de messages entre les agents qui représentent l’apprenant et le formateur dans le système. Cela permet d’avoir un mécanisme unique de suivi des interactions entre agents, qu’ils soient artificiels ou humains. Ceci est nécessaire, car une situation identique pourrait se produire entre un apprenant et un agent pédagogique artificiel. Un échange de message entre agents est une action de communication qui se décompose en une opération de production d’un acte et sa consommation par un ou plusieurs agents. Dans MASCARET, les différents types d’action de communication correspondent aux performatifs de KQML (Labrou, 1996). 3.4. Enregistrement des traces élémentairesLa responsabilité de la construction des traces à partir des évènements présentés dans les sections précédentes et de leur enregistrement revient à un agent observateur. Les éléments à tracer sont définis sous forme de filtres sur les propriétés des évènements potentiellement produits par les entités de MASCARET. Le comportement de l’agent observateur est d’interpréter les filtres de sélection d’évènements de façon à déterminer, à partir du modèle de l’environnement, quelles entités devront lui notifier les occurrences d’évènement. Ceci est possible dans MASCARET car tous les éléments du modèle, et le modèle lui-même, sont réifiés. Les principaux termes utilisés dans cet article sont présentés dans le tableau.

Tableau 1 : Glossaire des termes À tout évènement, on peut associer des informations sur la source de l’évènement ou sur les objets concernés (leurs propriétés, leur localisation). Pour faciliter l’identification du contexte de son occurrence il est possible d’ajouter des informations telles que : l’état d’un sous-ensemble des objets du monde, l'activité d'un agent artificiel, les déplacements d'entités dans une zone ou des évènements extérieurs à l'environnement virtuel. La figure 2 présente les différents types de traces, chacun étant lié à un type d’observable de Mascaret.

3.5. Outils pour l’analyse des tracesLes traces issues de MASCARET étant enregistrées dans un format standard (XML), leur analyse n’est pas dépendante d’un outil particulier. Elles peuvent être consultées par l’intermédiaire d’un simple éditeur de texte ou d’un navigateur web et altérées grâce à des outils de manipulation de texte (par exemple GNU sed). Pour une analyse plus aisée, nous utilisons des outils spécifiques à l’analyse des traces. MASCARET propose un outil intégré de visualisation des traces sous forme de chronogrammes. Il est possible, grâce à une transformation de modèle (XSLT) d’adapter le format et la sémantique de nos traces pour les exploiter dans un outil tel que TATIANA qui utilise lui aussi un format XML (Dyke et al., 2007) ou tel que CoLAT (Avouris et al., 2005) qui permet la fusion de traces issues de plusieurs sources. Néanmoins, chaque élément de la trace étant lié à un ou plusieurs éléments du monde réifié grâce au modèle VEHA, l’analyse est facilitée lorsque l’outil permet de manipuler explicitement ces observables (ce que permet l’outil de visualisation intégré à MASCARET). Par exemple, on veut pouvoir filtrer les traces pour ne refléter que l’occurrence des actions d’un certain utilisateur (ici, le formateur ou l’apprenant) ou l’utilisation d’un objet particulier. On peut aussi vouloir fabriquer des indicateurs spécifiques pour mettre en évidence certaines tendances, comme par exemple, pour évaluer la fréquence d’utilisation d’un périphérique ou comparer l’utilisation de deux ressources en ligne (Bratitsis et Dimitracopoulou, 2006). 4. Expérimentation sur des travaux pratiques de physique dans une paillasse virtuelleComme première utilisation de notre paillasse virtuelle, nous avons choisi de reproduire un TP de physique qui a fait l’objet d’une étude précédente (Beney et Guinard, 2004). La tâche à réaliser est la mesure par différence de la vitesse de la lumière dans l’air, dans un cube de résine, puis dans l’eau. Nous avons mené une expérimentation afin de vérifier si les traces de l’activité recueillies, permettaient de repérer des actions, telles que l'utilisation d'aides virtuelles (Baudouin et al., 2007), des plans d’actions, des situations prototypiques et de comparer ce que les apprenants font par rapport à ce qu’ils disent avoir fait. Ce dernier point n’est pas abordé dans cet article. 4.1. Méthodologie4.1.1. Les sujetsQuatorze étudiants d’une école d’ingénieurs (ENIB), en première année après le baccalauréat, participent librement à l’expérimentation. Tous les sujets sont de sexe masculin et ont un parcours scolaire équivalent en ce qui concerne l'apprentissage de la physique. En échange de leur acceptation, une visite du CERV et des démonstrations en réalité virtuelle leur sont proposées. Les conditions matérielles sont proches de celles qui pourraient être mises en place dans un cadre scolaire classique ; mais l'expérience est présentée aux étudiants comme une expérience de recherche et les personnes présentes sont des chercheurs. 4.1.2. La paillasse virtuelleUne paillasse virtuelle spécifique a été conçue pour cette expérience en utilisant MASCARET (Figure3). L'affichage de la scène 3D utilise un vidéoprojecteur classique, non-stéréoscopique. Elle permet de réaliser l'expérience debout, à environ 1,30m de l'écran, avec un angle de vue assez large. La paillasse virtuelle apparaît dans une taille et une orientation proche d'une paillasse réelle. L'interface motrice, posée sur un pupitre, utilise un clavier (15 touches utiles), une souris et une souris 3D à 6 degrés de liberté. Les consignes opératoires sont fournies sous forme d’un texte écrit sur une feuille que l’élève a en permanence à sa disposition. Durant la séance, l'apprenant doit mesurer la vitesse de la lumière dans l'air, dans la résine (le cube jaune) et dans l'eau (le tube noir). La règle permet de repérer les positions des objets posés sur le socle. L'oscilloscope affiche deux signaux correspondants à l'émission et à la réception de la lumière. Le temps mis par la lumière pour parcourir le chemin peut être déduit de la mesure du décalage entre les deux signaux (déphasage). La difficulté de ce TP réside dans l'impossibilité de mesurer précisément certains paramètres comme la distance entre les miroirs et la position exacte de l'émetteur / récepteur de lumière. Pour obtenir la vitesse précise, l'apprenant doit obligatoirement réaliser une mesure de référence. La navigation dans l'environnement passe par des points de vue fixes prédéfinis. L'apprenant peut passer d'un point de vue à un autre en utilisant les touches flèches du clavier. Les flèches gauche et droite permettent de déplacer le point de vue latéralement, tandis que les flèches haut et bas permettent respectivement d’avancer ou de reculer le point de vue. Ce mode de navigation évite à l’apprenant de se perdre dans l’environnement et lui permet d’effectuer des déplacements rapides. La manipulation des objets s'effectue avec la souris classique et la souris 3D dont nous n’utilisons que la rotation selon l’axe des z. Il est possible de déplacer les objets dans le plan de la table et de les orienter sans les soulever. Pour manipuler un objet, l'apprenant doit le "saisir" en le sélectionnant avec la souris. Pour cela, il place le pointeur sur l'objet et clique avec le bouton gauche. Une fois l'objet saisi, le pointeur disparaît et la position de l'objet sur la table est liée à la position de la souris (axes x et y). L'apprenant peut donc déplacer l'objet sur le plan de la table en déplaçant la souris. Lorsqu'il veut poser l'objet, il clique à nouveau pour lâcher l'objet. Pour tourner les objets, nous utilisons l’axe de rotation selon z de la souris 3D. Ceci permet d’orienter les objets et de tourner le bouton de l’oscilloscope. Ces deux interfaces motrices, assez classiques, permettent de conserver la nature du geste du bras et de la main. Le TP nécessite une manipulation précise des objets traversés par la lumière. Ces derniers doivent avoir une orientation exacte pour limiter la réfraction qui compliquerait la simulation du trajet du rayon lumineux. Afin de faciliter ces manipulations, deux Aides Logicielles Comportementales sont mises en place : un guide de positionnement et un guide en translation. Lorsqu'un objet subit une rotation et que l’orientation finale est proche d'un angle plat (0,π) ou d'un angle droit (π/2, 3π/2) par rapport au rayon lumineux, l'angle est ajusté exactement à ces valeurs, de façon automatique. Quand l'utilisateur approche un objet suffisamment près du socle, il est "magnétisé" sur le socle et guidé en translation. Pour enlever l'objet du socle, l'apprenant doit le saisir et "tirer" ou "pousser" l'objet. Cette manipulation assistée d’une ALC est donc conforme à l’automate de la figure1. 4.1.3. ProcéduresChaque apprenant manipule seul en présence d’un didacticien de la physique. Ce dernier intervient pour annoncer le début et la fin des étapes et pour donner une information évaluative à l’apprenant, portant sur sa méthode et sur son résultat. Chaque étape correspond à une activité au sens du modèle HAVE de MASCARET (c.f. 3.2). Le déroulement de l'expérience est le suivant : - Description de l’interface par l’expérimentateur, puis manipulation par l’apprenant d’un environnement simplifié (tutoriel 1 : 5 min). - Présentation de la paillasse virtuelle par l’expérimentateur. Description et manipulations des objets (tutoriel 2 : 5 min). - Apprentissage dans la paillasse virtuelle : réalisation des trois mesures de la vitesse de la lumière (30 ~ 45 min). - Entretien d'explicitation, mené dès la fin de l'expérimentation, de type semi directif (10 min). - Questionnaire à questions fermées en trois parties sur le profil de l'apprenant en rapport avec la réalité virtuelle (simulateur, jeux 3D), l’utilisabilité de l'EVAH et l’auto-évaluation des performances de l'apprenant. L’apprentissage est découpé en trois étapes évolutives, au cours desquelles l'apprenant mesure la vitesse de la lumière dans l'air, dans le cube de résine puis dans l'eau. Chaque étape est constituée de plusieurs phases. L'apprenant a un temps alloué pour résoudre seul le problème. À l’issue de ce temps, l’expérimentateur donne à l’apprenant un retour informatif sur sa prestation. Pour les deux premières étapes, en cas de blocage ou d'échec, l’apprenant bénéficie d’un temps supplémentaire au cours duquel il peut utiliser des aides virtuelles. Puis, en cas de nouvel échec, l’expérimentateur lui montre la bonne procédure de manipulation et lui demande de refaire cette manipulation. 4.2. Recueil et mise en forme des traces4.2.1. Les observations directes sur l’activitéNous recueillons pendant l’expérimentation, des enregistrements informatiques, des enregistrements audiovisuels et des notes de passation. Les enregistrements audiovisuels sont collectés par un caméscope fixe filmant l’apprenant et la scène virtuelle projetée. Les notes de passation fournissent des indications des performances communiquées aux apprenants (méthode et résultat). Les enregistrements informatiques sont produits par MASCARET. Le modèle d’activité HAVE permet de spécifier les éléments que nous souhaitons retrouver dans ces traces informatiques. Nous enregistrons toutes les interactions de l'apprenant avec l’environnement virtuel et nous obtenons des traces reflétant son activité.

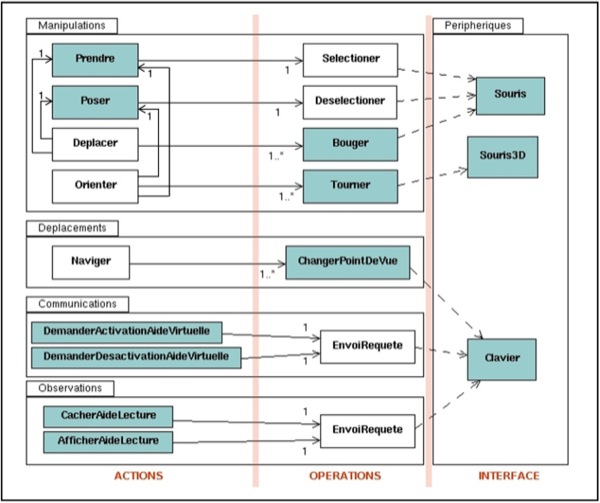

Les actions des utilisateurs peuvent être classées selon le type de PCV auquel elles correspondent (Figure 4) : manipulation, déplacement, communication et observation. Les traces enregistrées durant l’expérience sont les éléments directement détectables, mis en couleur sur la figure. Elles reflètent soit la réalisation d’une opération ou d’une action, soit l’utilisation d’une interface motrice. 4.2.2. Génération de frises chronologiquesIl est possible d'exploiter les traces informatiques sans modification ou ajouts sémantiques, en réalisant des comptages statistiques ou en utilisant des représentations graphiques spécifiques. Nous utilisons l’un des outils de MASCARET pour générer des frises chronologiques qui permettent de visualiser l’enchaînement des traces à différentes échelles. Ces frises peuvent être confrontées à l’enregistrement vidéo et aider à l’analyse des traces textuelles. Elles permettent d’effectuer des premiers repérages et de sélectionner des épisodes intéressants. L’information élémentaire est un évènement observé, figuré par une barre verticale grise. Chaque ligne regroupe les évènements liés à un agent (par exemple l’apprenant), une entité (par exemple les miroirs) ou à l’utilisation d’une interface motrice.

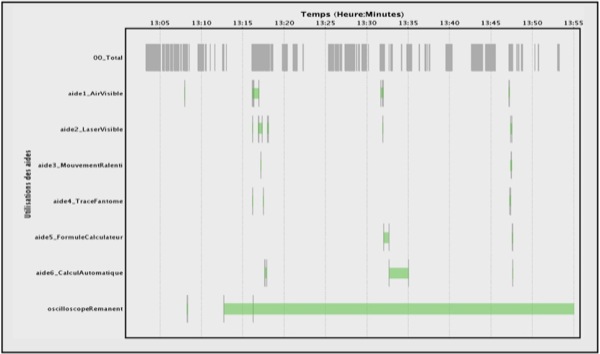

Par exemple, bien que le nombre d'évènements soit très élevé, une représentation sous forme de frise donne une vue d'ensemble de l’utilisation des aides (Figure 5). La première ligne correspond à tous les évènements déclenchés par l’apprenant. Elle fait clairement apparaître les temps d’inactivité de l’apprenant. Les autres lignes montrent les activations et désactivations des aides. Les bandes colorées correspondent aux repérages dans les traces textuelles des périodes d’affichage des aides (intervalle temporel entre l’activation et la désactivation d’une aide). Ce diagramme permet de distinguer clairement les différentes étapes et phases de l’apprentissage et permet de visualiser quelles aides ont été déclenchées, dans quel ordre et pendant combien de temps (Baudouin et al., 2007). 4.2.3. Les observations indirectes de l’activitéL’étude de ces observations indirectes est mentionnée sans être présentée en détail dans cet article. Elle participe à l’affinement et à l’évaluation du dispositif d’apprentissage (Tchounikine, 2002). L’expérience terminée, l’entretien avec le sujet permet de recueillir ses impressions, constats et réflexions à la fois sur sa prestation, les aides utilisées et son appréciation sur l’environnement virtuel. Le questionnaire à questions fermées montre que tous les apprenants sont familiers des applications informatiques et ont déjà été en contact avec des environnements virtuels, tels que des simulateurs ou des jeux. Les utilisateurs ne sont donc pas novices vis-à-vis de la réalité virtuelle. 4.3. Analyse et interprétation des observations directesHulshof caractérise quatre formes d’analyse de fichiers de trace : l’analyse fréquentielle centrée sur les opérations réalisées et leur fréquence, l’analyse séquentielle centrée sur l’ordonnancement des opérations, l’analyse des transitions centrée sur les raisonnements, l’analyse du protocole centrée sur la verbalisation des processus à voix haute (Hulshof, 2005). Les deux premiers types d’analyse produisent des résultats qui concernent l’activité observable tandis que les deux derniers s’intéressent davantage au raisonnement et à l’état cognitif de l’utilisateur. L’analyse de l’activité des apprenants porte ici sur le repérage de l’utilisation d’aides virtuelles (analyse fréquentielle), la reconnaissance des procédures manipulatoires des apprenants (analyse séquentielle et analyse du protocole) et l’identification de situations prototypiques (analyse séquentielle). Nous en donnons quelques exemples dans les sections qui suivent. 4.3.1. Identification des actions à partir des tracesDans certains cas, une action est clairement définie comme une suite ou un assemblage d'opérations (cf. Figure 4) : de simples règles permettent alors de mettre en valeur avec certitude les actions de l'utilisateur (exemple : une touche = une action). De la même façon, certaines activités peuvent être déduites directement de la trace des actions. Ces règles sont connues de l'agent observateur de Mascaret ; il est alors capable de générer directement des traces de plus haut niveau faisant apparaître des actions, voire des activités. Mais, en général, les actions ne peuvent pas être définies clairement ou indépendamment les unes des autres. La déduction des actions à partir des traces nécessite la formalisation de l'action, c'est-à-dire l’expression de l’action sous la forme d’un ensemble d’opérations, liées par des contraintes de contexte. Selon le type de l’action (PCV), l’identification ne repose pas sur les mêmes éléments. Pour les déplacements, nous identifions une seule action, naviguer, qui se traduit par un déplacement de la caméra virtuelle dans l’environnement, vers l’un des points de vue atteignables. Cette action est réalisée par l’exécution d’une suite d’opérations ChangerPointDeVue, qui correspondent chacune, au passage d’un point de vue à un autre parmi les points de vue adjacents (devant, derrière, à droite et à gauche). Le pavé directionnel du clavier permet donc de s’approcher, de s’éloigner, de regarder à droite et de regarder à gauche. Les actions de communication sont limitées dans notre environnement à l’appel des aides virtuelles. Les autres actes de communication importants de l’expérience sont les retours évaluatifs qui se déroulent entre l’apprenant et l’expérimentateur, sans passer par l’environnement. Ils n’apparaissent donc pas dans la trace informatique. Les manipulations d’objets apparaissent dans les traces, mais ces actions ne sont pas directement déductibles des opérations. Nous considérons qu’un déplacement consiste à prendre un objet, puis l’amener d’une position A à une position B, en effectuant autant de micro-déplacements que nécessaire et enfin, à le poser (cf. automate de la figure1). Dans le cas général, une action déplacer est donc bornée par les actions prendre et poser. Néanmoins, il arrive parfois que l’apprenant réalise plusieurs actions de déplacement avant de désélectionner l’objet (il lâche réellement la souris, sans cliquer). Dans ce cas, l’environnement ne peut pas détecter la fin du déplacement réel. Il faut donc modifier l’automate pour considérer ce cas. Nous considérons alors que l’apprenant a terminé son déplacement, s’il marque une pause suffisante entre deux opérations bouger ou s’il réalise une autre action. Les prises d’information, comme la lecture d’une position sur la règle ou de la phase entre les deux courbes de l’oscilloscope, ne sont que partiellement médiées par l’environnement. En effet, il est possible de savoir quand l’information est visible par l’apprenant, mais on ne peut que supposer que ce dernier lise bien la valeur. La seule action d’observation directement disponible est l’appel de l’aide de lecture qui permet d’afficher une copie de l’écran de l’oscilloscope en surimpression dans le coin de l’écran. Néanmoins, pour pouvoir effectuer une mesure précise, l’apprenant est obligé de naviguer jusqu’à l’un des points de vue, au plus près de l’oscilloscope sur la table. Pour lire précisément les positions des objets, il doit aussi se rapprocher de la règle. De ce fait, il est possible de faire des hypothèses sur les prises d’informations à partir de ses opérations de déplacements. L’identification des actions d’observation est donc réalisée grâce à un automate tel que celui de la figure 1. 4.3.2. Repérage de la bonne procédure de manipulationPour réussir l’exercice, l’apprenant doit réaliser une procédure de mesure correcte puis effectuer un calcul à partir des mesures effectuées. Bien que plusieurs procédures différentes soient possibles pour trouver un résultat bon ou approché, le chercheur en didactique de la physique estime que certains éléments sont indispensables à la réussite. Nous privilégions une méthode de manipulation efficace sans approximation. Dans le contexte de notre TP, plusieurs distances ne sont pas connues et ne sont pas mesurables. Par ailleurs le déphasage des courbes qui permet la mesure des temps peut être fixé arbitrairement. Pour faire des mesures de distance et de temps, l’apprenant doit mettre en place une situation de référence. Chaque exercice nécessite une procédure spécifique de mesure. Nous présentons ici le repérage de la bonne procédure pour réussir la mesure de la vitesse de la lumière dans l’air qui pose le plus de problèmes, car peu d’objets sont manipulés. Cette procédure est définie comme suit : 1. L’apprenant place les miroirs à une position quelconque A sur le socle. Il note la position des miroirs par rapport à la règle. 2. L’apprenant note le déphasage entre les deux courbes sur l’oscilloscope ou met les courbes en phase grâce au bouton déphaseur. 3. L’apprenant place les miroirs à une autre position quelconque B. Il note la position des miroirs. 4. L’apprenant note le déphasage entre les deux courbes. Durant toute la procédure, le cube de résine et le tube d’eau ne doivent pas se trouver sur le socle entre les miroirs et l’émetteur/récepteur. L’apprenant peut réaliser d’autres actions comme déplacer les objets pendant la procédure sans nuire aux mesures. Par contre, l’apprenant ne doit pas modifier le déphasage à l’aide du bouton après la partie deux de la procédure. Grâce aux prises d’information, l’apprenant dispose à la suite de cette manipulation, des données nécessaires et suffisantes pour calculer la vitesse de la lumière, c’est-à-dire la distance parcourue par la lumière et le temps correspondant.

La frise de la figure6 montre un extrait des traces d’utilisation sur lequel nous avons mis en évidence une bonne procédure de manipulation. Les quatre premières lignes correspondent aux opérations de déplacement dans l’environnement. Les lignes Souris et Souris3D reflètent l’utilisation de ces périphériques. Miroirs et BoutonDephasage regroupent toutes les opérations de manipulation sur ces entités. Nous avons repéré manuellement cette procédure à partir de la frise de manipulation complète. Les bandes colorées et les ellipses vertes ont été ajoutées manuellement pour faciliter la lecture de la frise. Chaque ellipse correspond à l’une des parties attendues de la bonne procédure, nous les avons numérotées ici de 1 à 4. Les quatre étapes sont facilement repérables : positionnement des miroirs (1), mise à zéro du déphasage des courbes (2), deuxième positionnement des miroirs (3), lecture du déphasage des courbes à l’écran de l’oscilloscope (4). On peut remarquer que dans l’étape 2, l’apprenant se rapproche le plus près possible de l’oscilloscope pour plus de précision. La frise ne nous permet pas de savoir si l’apprenant met effectivement les courbes en phase, mais nous pouvons le vérifier dans le fichier de traces XML (évènement de type PropertyChange, figure2). Le fait que l’apprenant déplace les miroirs en plusieurs fois (pour l’étape 1 et 3) s’explique en regardant le fichier XML. Dans le cas 1, l’apprenant place grossièrement les miroirs puis effectue un placement de précision. Dans le cas 3, l’apprenant n’a pas un point de vue assez large pour voir, à la fois, les positions initiale et finale des miroirs. Il est trop près de la règle, et doit donc s’éloigner pour déplacer les miroirs sur la distance voulue puis se rapprocher pour les positionner précisément. Les données qui nous manquent le plus ici concernent les prises d’information. Lors des placements précis des miroirs et de la mise en phase des courbes, les positions A et B sont choisies par l’apprenant. Nous faisons l’hypothèse qu’il a bien noté ces deux valeurs. Le repérage de la partie 4 de la procédure est plus problématique. L’apprenant ne se déplace pas dans l’environnement pour se rapprocher de l’oscilloscope. Les traces nous ont permis de savoir qu’à cet instant, l’aide de lecture permettant de voir l’oscilloscope en permanence était active. L’apprenant a donc eu la possibilité de faire une mesure quand il le désirait. Nous sommes obligés ici de faire l’hypothèse que la non-activité de l’apprenant regroupe une prise d’information puis un calcul. Les notes de passation de l’expérimentateur nous ont permis ensuite de vérifier que cet apprenant avait bien réalisé une bonne procédure. 4.3.3. Identification de situations prototypiquesIl est possible d’identifier l’occurrence d’autres procédures ou situations intéressantes. Certaines erreurs typiques sont identifiables car elles entraînent une procédure de manipulation caractéristique. Nous donnons quatre exemples. L’apprenant tente d’annuler le problème de la mesure des longueurs inconnues en rapprochant le plus près possible les éléments les uns des autres. L’agent observateur détecte alors des collisions entre les objets sur le socle (évènements de type Collision entre objets de type lentille, cube et miroirs, cf. figure2). Ce type de procédure peut être formalisé et est donc détectable dans la trace. L’apprenant oublie ou ne se rend pas compte que la lumière n’effectue pas un aller-retour dans le tube d’eau. La procédure de manipulation, qui est proche de la mesure dans le cube, est alors presque correcte. Seuls les miroirs sont mal positionnés, car l’apprenant les déplace d’une distance égale à la longueur du tube d’eau au lieu de la moitié. L’apprenant n’a qu’une représentation partielle du problème et considère que toutes les mesures de distance doivent partir de l’origine de la règle. Il positionne alors les miroirs ou le cube à la position zéro de la règle pour faire une mesure absolue. Néanmoins, certains apprenants positionnent le cube à l’origine pour en mesurer la longueur. L’absence d’action de la part de l’apprenant peut s’interpréter comme une phase de réflexion ou de calcul ou comme une situation de blocage. C’est l’analyse de l’activité précédente qui permettra d’identifier la situation. Si, par exemple, les actions que l’apprenant vient de réaliser permettent d’identifier une procédure proche de celle attendue, on peut supposer que l’absence d’activité dans les traces correspond à la phase de calcul, qui se déroule en dehors de l’environnement. Si, au contraire, l’activité ne correspond à rien de prévu, on peut faire l’hypothèse que l’apprenant est dans une situation de blocage. Nous avons également noté que certains apprenants tentent des opérations interdites ou impossibles dans l’environnement comme par exemple aller plus loin que les points de vue définis. Même si elles n’ont pas de conséquences sur le monde virtuel, ces actions reflètent un comportement de l’utilisateur qui peut être intéressant. L’agent observateur enregistre ces opérations et elles sont donc disponibles dans les traces. 5. Conclusion et perspectivesDans ce bilan, nous reviendrons sur la spécificité des traces en réalité virtuelle, l’apport de MASCARET et notre modèle de description des traces. Nous dégagerons ensuite quelques perspectives à moyen terme et identifierons certains problèmes qui restent à résoudre. Les EVAH sont riches en interactions de différentes natures et les activités y sont multiples. L’activité en travaux pratiques est fortement manipulatoire et nécessite par ailleurs l’observation attentive du dispositif, la prise de mesures et la réalisation de calculs. L’utilisation de la réalité virtuelle modifie inévitablement la réalisation de ces activités par rapport à un environnement réel ; elle permet aussi d’autres actions, comme l’ajout d’informations non textuelles dans l’environnement ou des changements d’échelle. Les spécificités sont liées à l’interfaçage comportemental, à la prise en compte du champ visuel de l’apprenant et au réalisme de la simulation du monde manipulé (modèles géométriques et comportementaux). Cependant, l’analyse de l’activité de l’apprenant dans de tels environnements partage un certain nombre de questionnements avec d’autres études sur les EIAH comme l’utilisation de ressources ou la durée de réalisation d’exercices, (Dimitracopoulou et Bruillard, 2006). La nature des informations à traiter est conditionnée par ces spécificités et par les questions abordées. L’intérêt d’un EVAH comme MASCARET est de définir formellement les observables à partir d’un modèle de l’environnement et de l’activité et d’assurer automatiquement leur recueil. L’expérimentation conduite sur la paillasse virtuelle montre qu’il est possible d’identifier certaines activités de l’apprenant et de répondre, en partie, aux questions posées : repérage d’actions, identification de plans partiels, identification de situations prototypiques. Les frises chronologiques générées à partir des traces informatiques offrent une vue d’ensemble qui permet un repérage rapide des actions. Les traces des fichiers de log permettent une analyse très précise mais requièrent la manipulation d’un gros volume de données. L’étude a mis en évidence la difficulté de repérage des prises d’information. La reconnaissance de ces actions pourrait être partiellement résolue en utilisant un dispositif de suivi du regard : mouvement de tête et mouvement oculaire (Duchowsky, 2003). Une autre difficulté réside dans la reconnaissance exacte des actions de déplacement d’objet. Pour limiter l’incertitude sur les déplacements, nous envisageons d’utiliser un bras à retour d’effort et de simuler la gravité. En plus d’augmenter le réalisme de la scène, le poids des objets obligera l’apprenant à soulever les objets virtuels et l’incitera à réellement les poser avant d’exécuter une nouvelle action, levant ainsi l’ambiguïté de la reconnaissance des actions de type déplacer. Nous disposons à l’issue de l’expérience, d’un gros volume de traces informatiques. Dans les conditions d’exploitation didactique de ces traces, le traitement reste semi automatisé et difficile. La possibilité de traiter en partie ces données par des frises montre que l'on peut utiliser cet outil pour alléger le travail d'un chercheur qui veut caractériser l'activité des apprenants : reconnaissance d'actions et de phase d’inactivité, nombre d'objets manipulés avec leur ordre d'utilisation et le type de relation avec les autres objets, fréquence d'utilisation des objets, recherche d'information... Ceci lui permet d'afficher les actions qui l'intéressent. Cependant l'’analyse a nécessité d’utiliser les autres observations directes (vidéo et notes de passation) pour lever certaines ambiguïtés. Pour permettre un traitement plus rapide et plus précis, nous pensons qu’il faudra transformer ces observations en traces informatiques pour pouvoir les fusionner avec les traces d’utilisation (Avouris et al., 2005). Il faut alors formaliser les notes manuelles et annoter les vidéos. Au-delà du repérage de la réalisation d’actions dans l’environnement, il est nécessaire d’aller plus loin dans la reconnaissance des plans d’actions de l’apprenant ou de situations non souhaitables. Nous pouvons identifier trois voies d’amélioration. Tout d’abord, le volume important des données nécessite de recourir à des méthodes d’identification de patterns récurrents dans le corpus de traces (Betbeder et al., 2007). Ensuite, il faut être en mesure de reconnaître le plan d’action de l’apprenant afin de disposer d’une indication sur ses intentions (El-Kechaï et Desprès, 2006), (Robinet et al., 2007). Nous avons montré une variabilité de l’activité manipulatoire des apprenants dans un article précédent (Baudouin et al., 2007). Cette variabilité doit être prise en compte pour individualiser le guidage. Il serait donc intéressant de définir des indicateurs spécifiques aux activités manipulatoires en réalité virtuelle. La définition des indicateurs étant très liée à leur utilisation (Dimitracopoulou et Bruillard, 2006), nous envisageons de définir un langage permettant de les construire et de les calculer directement à partir des traces issues de MASCARET. Dans cette étude, nous nous sommes centrés sur l’analyse de l’activité d’un apprenant dans un environnement virtuel. L’objectif du projet de paillasse virtuelle est de disposer d’un environnement qui reproduise plus complètement la situation réelle d’une séance de travaux pratiques. Deux axes se dégagent de cette perspective. Le premier concerne la dimension collaborative du travail en binôme, ce que permet MASCARET. L’analyse de l’activité collaborative nécessitera d’intégrer des indicateurs de la qualité de cette collaboration (Barros et Verdejo, 2000). Le deuxième axe est de renforcer l’immersion des apprenants dans l’environnement virtuel. Nous travaillons à la construction d’un nouveau prototype de la paillasse virtuelle avec un rendu visuel stéréoscopique, un suivi de mouvement de tête et l’utilisation d’interfaces motrices comme des bras à retour d’effort et des dispositifs sans fil munis d’accéléromètres. Cette paillasse permettra à deux apprenants de collaborer dans le même monde en étant en face à face. Ce nouvel environnement ouvre des pistes intéressantes pour l’analyse de l’activité des apprenants en réalité virtuelle et le développement d’outils d’analyse adaptés. 6. RéférencesAVOURIS N., KOMIS V., FIOTAKIS G., MARGARITIS M., VOYIATZAKI E., (2005). Logging of fingertip actions is not enough for analysis of learning activities, In Usage analysis in learning system AIED’05 Workshop, p. 1-8. BARROS B., VERDEJO F. M. (2000). Analyzing student interaction processes in order to improve collaboration. The DEGREE approach, International Journal of Artificial Intelligence in Education, 11, p. 221-241. BAUDOIN C., BENEY M., CHEVAILLIER P., LE PALLEC A. (2007). Analysis of virtual helps usage in a virtual environment for learning, Proceedings of the 4th International INTUITION Conference, Athens (Greece), p. 52-60. BECU-ROBINAULT K. (1997). Rôle de l’expérience en classe de physique dans l’acquisition des connaissances sur les phénomènes énergétiques. Thèse de doctorat en didactique de la physique, Université Claude Bernard, Lyon 1. BETBEDER M.-L., TISSOT R., REFFAY C. (2007). Recherche de patterns dans un corpus d'actions multimodales, Actes du congrès EIAH 2007, p. 533-544. BENEY M., GUINARD J.-Y. (2004). L'évaluation de l'efficacité du guidage dans les Travaux Pratiques de Deug : Un problème méthodologique complexe. Didaskalia, n° 24, p. 29-64. BENEY M., SERE M.-G. (2001). Entre réussir et comprendre ou de l’effet des consignes opératoires sur la compréhension des procédures de mesurage en TP de physique de 1er cycle universitaire. Didaskalia n° 19, p. 9-37. BUCHE C., QUERREC R., CHEVAILLIER P., KERMARREC G. (2004). Apports des systèmes tutoriaux intelligents et de la réalité virtuelle à l'apprentissage de compétences, Cahiers Romans de Sciences Cognitives, In Cognito, Association de recherche en sciences cognitives, n°2.2, p. 51-83. BUCHE C., QUERREC R., DE LOOR P., CHEVAILLIER P. (2004). Mascaret: A Pedagogical Multi-Agent System for Virtual Environment for Training. Journal of Distance Education Technologies, Vol. 2 n°4, p. 41-61. BURKHARDT J.-M., BARDY B. et LOURDEAUX D. (2003). Immersion, réalisme et présence dans la conception et l’évaluation des environnements virtuels. Psychologie Française, Tome 48, n°2. BOOCH G., RUMBAUGH J., JACOBSON I. (2005). The Unified Modeling Language User Guide (2nd Edition). Addison-Wesley, Object technology Series. BRATITSIS T., DIMITRACOPOULOU A. (2006). Indicators for measuring quality in asynchronous discussion forums. International Conference on Cognition and Exploratory Learning in Digital Era (CELDA2006), IADIS (International Association for Development of the Information Society) 8-10 December, 2006, Barcelona, Spain. CHEVAILLIER P., HARROUET F., DE LOOR P. (1999). Application des réseaux de Petri à la modélisation des systèmes multi-agents de contrôle, Journal Européen des Systèmes Automatisés, Vol 33 n°4, p. 413-437. CRANEFIELD S., PURVIS M. (1999). UML as an Ontology Modelling Language, Workshop on Ontologies and Problem-Solving Methods: Lessons Learned and Future Trends, in conjunction with the 16th International Joint Conference on Artificial Intelligence (IJCAI). Stockholm, Sweden. DIMITRACOPOULOU A. et al. (2005). State of the art of interaction analysis for Metacognitive Support & Diagnosis. Interaction Analysis (IA) JEIRP.Tech. report of Kaleidoscope NoE, (IST, e-learning). DIMITRACOPOULOU A, BRUILLARD E. (2006). Enrichir les interfaces de forums par la visualisation d’analyses automatiques des interactions et du contenu, Sciences et Technologies de l´Information et de la Communication pour l´Éducation et la Formation, Vol 13. DUCHOWSKY A.T. (2003), Eye tracking methodology: theory and practice, Springer-Verlag. DYKE G., GIRARDOT J.J., CORBEL A., COLLINS S., PAUZE A. (2007) Tatiana - a Trace analysis tool. http://lead.emse.fr/Presentation/index.html EL-KECHAÏ N., DESPRÉS C. (2006), A Plan Recognition Process, Based on a Task Model, for Detecting Learner's Erroneous Actions, Intelligent Tutoring Systems ITS 2006, IKEDA M., ASHLEY K., CHAN T-W. (Eds), LNCS, Vol. 4053. p. 329-338. FUCHS P. (1996), Les interfaces de la réalité virtuelle, Les presses de l’Ecole des Mines de Paris. FUCHS, P. (2006), Le traité de la réalité virtuelle (3e édition), volume 2 : l’interfaçage, l’immersion et l’interaction en environnement virtuel, Les presses de l’Ecole des Mines de Paris. HERAUD J.M., MARTY J.C., FRANCE L., CARRON T. (2005). Une aide à l’interprétation de traces : application à l’amélioration de scénarios pédagogiques. Conférence EIAH 2005, INRP, France, p. 237-248. HUBNER J. F. , SICHMAN J. S. , BOISSIER O. (2002). Moise+: Towards a structural, functional, and deontic model for MAS organization. Castelfranchi C., Johnson W. L., (Eds), First International Joint Conference on Autonomous Agents and Multi-Agent Systems (AAMAS’2002), p. 501–502. HULSHOF C. D., (2005) Log file analysis, Encyclopedia of Social Measurement. KALLMANN M., THALMANN D. (1998). Modeling Objects for Interaction Tasks, Computer Animation and Simulation'98, p. 73-86 KATZ S., LESGOLD A., EGGAN G., GORDIN, M. (1992). Modelling the student in Sherlock II. Artificial Intelligence in Education, vol 3 n°4, p. 495-518. LABROU Y. (1996), Semantics for an agent communication language, PhD thesis, University of Maryland. OLLAGNIER-BELDAME M. (2006). Traces d’interactions et processus cognitifs en activité conjointe : Le cas d’une co-rédaction médiée par un artefact informatique. Thèse de doctorat en sciences cognitives. Université Louis Lumière, Lyon 2. PATEYRON B. (1997). Modélisation des savoirs dans la formation professionnelle, cas du brevet de technicien supérieur en contrôle industriel et régulation automatique. Thèse de doctorat, Université Claude Bernard, Lyon 1. REYDE J. LEACH J. (1999). Enseigner les pratiques effectives de la science : expériences d’étudiants en projet de recherche en licence. Didaskalia n° 12, p. 39-61. ROBINET V., BISSON G., LEMAIRE B., GORDON M., (2007) Searching For Student Intermediate Mental Steps, Workshop on Data Mining for User Modeling, at the 11th International Conference on User Modeling (UM 2007), p. 101-105. SEJOURNE A., TIBERGHIEN A. (2001). Conception d’un hypermédia en physique et étude des activités des élèves du point de vue de l’apprentissage. In E. De Vries, J.- P Perrin, J.-P Peyrin (Eds), 5ème colloque hypermédia et apprentissages. Paris , INRP et IHSA, p. 103-118. TCHOUNIKINE P. (2002). Pour une ingénierie des Environnements Informatiques pour l’Apprentissage Humain. I3, vol 2 n°1, p. 59-95. TRICOT A. (2003). Apprentissage et recherche d’information avec des documents électroniques. Mémoire pour l’habilitation à diriger des recherches, Université Toulouse le Mirail. VINCE J. (2000). Approches phénoménologique et linguistique des connaissances des élèves de 2nde sur le son. Thèse de doctorat, Université Lyon 2.

| ||||||||||||||||||||||||||

Référence de l'article :Cyrille BAUDOUIN, Michel BENEY , Pierre CHEVAILLIER, Agnès LE PALLEC, Recueil de traces pour le suivi de l'activité d'apprenants en travaux pratiques dans un environnement de réalité virtuelle. , Revue STICEF, Volume 14, 2007, ISSN : 1764-7223, mis en ligne le 08/01/2008, http://sticef.org |