Sciences et Technologies

Sciences et Technologiesde l´Information et

de la Communication pour

l´Éducation et la Formation

version à télécharger (pdf)

Volume 13, 2006

Article de recherche

|

Contact : infos@sticef.org |

Musique Lab Maquette : approche interactive des processus compositionnels pour la pédagogie musicale

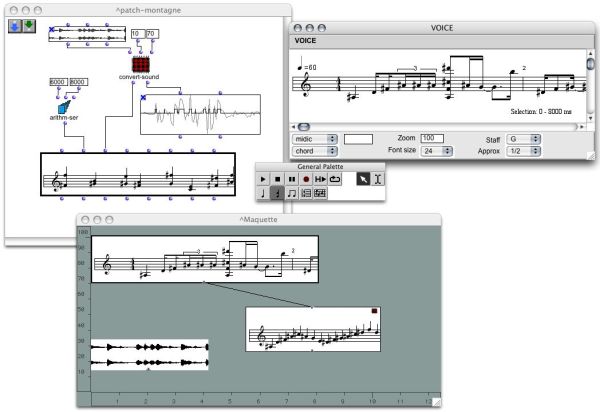

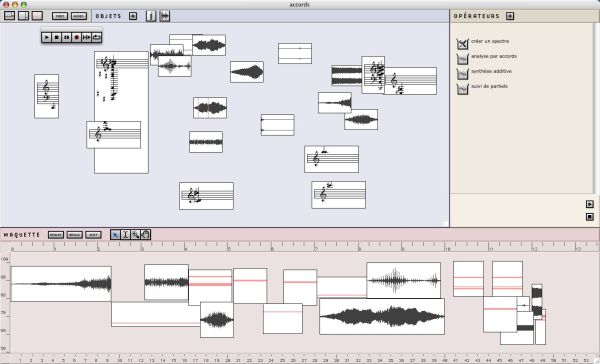

1. IntroductionMusique Lab est un projet mené par l'IRCAM en collaboration avec le Ministère de l'Éducation Nationale et le Ministère de la Culture et de la Communication, dans le cadre du dispositif de soutien aux ressources multimédia piloté par la Direction de la Technologie du Ministère de l'Education Nationale. L'objectif de cette initiative est d'imaginer et de mettre en place des outils destinés aux classes de musique des établissements d'enseignement secondaire et des conservatoires, permettant le développement de nouvelles situations pédagogiques en adéquation avec les outils et méthodes d'analyse et de création actuels. Musique Lab Maquette (ou ML Maquette) est une application développée dans le cadre de ce projet. Il s'agit d'une extension, adaptée au cas d'utilisation pédagogique, de l'environnement de composition assistée par ordinateur OpenMusic, un langage de programmation visuelle dédié à la composition musicale. Cet article présente les bases théoriques et l'implémentation de ce travail. Après une présentation du projet (partie 2), nous retracerons le chemin conduisant d'un environnement de composition à la création d'un outil pédagogique (partie 3). Les parties suivantes de ce texte se voudront plus descriptives de l'application (partie 4), et détailleront ses différentes facettes et directions conceptuelles (parties 5, 6, et 7). Finalement nous essaierons de tirer des premières conclusions sur son utilisation (partie 8). 2. À la croisée de la musique, de la pédagogie, et de l'informatique2.1. ContexteLes recherches dans le domaine des outils informatiques dédiés à la pédagogie et à l'apprentissage se sont très tôt intéressées aux environnements programmables, avec des réalisations comme le langage Logo. Celui-ci fait partie d'un ensemble de travaux regroupés sous l'appellation de « micromondes », environnements informatiques élémentaires, programmables par une syntaxe simple, permettant l'exploration autonome de domaines spécifiquement ciblés et réduits à leurs principaux éléments. Avec Logo, il s'agissait ainsi de fournir à un utilisateur en situation d'apprentissage les outils pour réaliser des programmes à l'aide d'un support graphique (une tortue évoluant sur une surface en traçant des dessins). Ce type d'environnement a été décliné dans différentes applications, parmi lesquelles certaines sont aujourd'hui encore utilisées pour l'enseignement – par exemple l'environnement Cabri (Capponi et Laborde, 1998), pour la géométrie. Dans le domaine de la musique, l'application des micromondes pour traiter des problématiques liées à la composition et au traitement de l'information musicale a également été considérée notamment par (Desain et Honing, 1988) (Honing, 1993). Cependant, les outils informatiques utilisés actuellement pour l'enseignement musical tirent plus majoritairement parti des avancées technologiques du point de vue de l'accès à l'information (par exemple avec l'enseignement interactif « en ligne », ou e-learning) ou de l'intégration multimédia (modalités audiovisuelles, en particulier). Aujourd'hui, les nouvelles technologies utilisées à des fins pédagogiques prennent une importance grandissante dans l'enseignement musical, comme dans d'autres domaines d'enseignement, mais surtout à l'image des pratiques musicales contemporaines. L'informatique musicale tend ainsi à intégrer de plus en plus des notions pédagogiques dans les axes d'investigation actuels ; à titre d'exemple, les journées d'informatique musicales organisées par l'association française d'informatique musicale en 2007 auront pour thème principal « les pédagogies de la musique au 21ème siècle » (JIM, 2007). Différents projets, soutenus par les institutions nationales et européennes, sont ainsi consacrés à ce problème visant à rapprocher les recherches en informatique musicale des considérations pédagogiques. Parmi ces initiatives, et hormis le projet Musique Lab dont il est question ici, on pourra citer par exemple le projet IMUTUS (Schoonderwaldt et al., 2004), ou le projet i-Maestro (iMaestro, 2006). Tous deux sont orientés principalement vers l'apprentissage de la pratique instrumentale. Initié en 1999, Musique Lab suit une approche privilégiant la création plutôt que l'interprétation. Dans sa première version (Musique Lab 1) ce projet a été ciblé sur des notions et enseignements généralistes, particulièrement ceux du niveau de collège. Il a donné lieu à une suite logicielle constituée de six applications interactives organisées autour de la génération et du contrôle de séquences musicales (Musique Lab, 2002), permettant la familiarisation des élèves avec les concepts musicaux et acoustiques fondamentaux (hauteurs, échelles, rythme, dynamique). Depuis 2002, Musique Lab est distribué et utilisé dans les classes de musique de nombreux établissements. 2.2. Le projet Musique Lab 2Musique Lab 2 constitue une nouvelle phase engagée dans ce projet (Puig et al., 2005), visant de nouveaux objectifs élaborés en collaboration avec des représentants des corps enseignants de lycées et de conservatoires. Parmi ces objectifs se dégagent par exemple la représentation de structures et d'objets musicaux de haut niveau, les relations entre composition, traitement du signal et acoustique, les relations entre la musique et les sciences (physiques, mathématiques), ou encore la représentation des structures et notions tonales et harmoniques. L'insertion des enseignements spécialisés dans les contraintes définies par les prescripteurs a ainsi conduit à l'élaboration d'une architecture pédagogique capable de s'adapter à des situations d'enseignement très différentes. Les ambitions de ce projet dépassent donc l'exploration interactive des paramètres musicaux visée avec Musique Lab 1, et nécessitent une réflexion approfondie sur les liens possibles entre musique, pédagogie, et technologie afin de tirer parti des techniques de calcul et de représentation existantes et/ou rendues possibles par l'informatique musicale. Différentes positions complémentaires, communément observées dans le domaine de la pédagogie musicale, constituent la base de l'approche adoptée pour la réalisation du projet Musique Lab 2 : l'observation, l'analyse, la construction, et l'interaction (Guédy, 2006). Celles-ci font l'objet de développements spécifiques, répartis en trois applications. Musique Lab Annotation est une application dédiée à l'écoute et au suivi de partitions annotées (observation, analyse) ; Musique Lab Maquette, dont il sera question dans cet article, est orientée vers la composition et l'expérimentation sur les formalismes musicaux (analyse, construction) ; et Musique Lab Audio concerne le traitement du signal et l'interaction en temps réel. Les situations pédagogiques imaginées par les enseignants pourront donc être développées dans l'une ou l'autre de ces applications, ou les faire intervenir et interagir en complémentarité. Chacune d'entre elles correspond à un domaine de compétence théorique et technique spécifique devant être confronté au cas d'utilisation pédagogique. 3. De la composition assistée par ordinateur à la pédagogie musicaleMusique Lab Maquette repose sur une base de compétences et de technologies dans le domaine de la composition assistée par ordinateur (CAO), constituée à l'IRCAM depuis le milieu des années quatre-vingt. L'étude conjointe des structures musicales et des modèles informatiques et calculatoires (Assayag, 1993) a permis à l'époque de développer l'idée d'un traitement symbolique de l'information musicale, ce qui constituait alors une approche originale en informatique musicale, proche des concepts compositionnels. Celle-ci occupe aujourd'hui encore une position centrale dans la CAO (Assayag et al., 1999). Suivant ces principes, et suite à plusieurs générations de systèmes de CAO, l'environnement OpenMusic (Agon, 1998) (Bresson et al., 2005) est conçu et développé sous la forme d'une plate-forme ouverte dans laquelle peuvent être construites des situations expérimentales relevant de la formalisation musicale. OpenMusic est en réalité un environnement de programmation visuelle permettant le développement de processus (musicaux en particulier) suivant divers types de programmation (Agon et al., 1998) (Agon, 2004). Des structures de données et fonctions spécialisées permettent d'orienter cette programmation dans le sens d'applications musicales (voir figure 1). À travers une interface de programmation appelée « maquette », OpenMusic introduit également une nouvelle approche formelle des structures temporelles permettant une confrontation des objets de composition assistée par ordinateur (structures de données et processus) avec un référent temporel (Assayag et al., 1997), (Bresson et Agon, 2006).

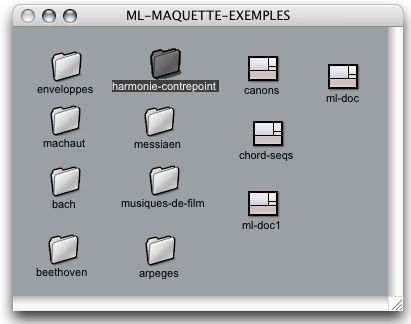

Figure 1 • L'environnement de composition assistée par ordinateur OpenMusic : programmes visuels (en haut à gauche), éditeurs musicaux (en haut à droite), maquette (en bas). Au point de rencontre de l'informatique et de la musique, les travaux menés dans cet environnement traitent de problématiques variées liées à la programmabilité, à la codification de la musique, à la dialectique entre objets et processus musicaux, etc. – voir par exemple (Assayag et al., 2001), (Andreatta, 2004). À travers de nombreuses années d'utilisation par une importante communauté de compositeurs, de théoriciens et de chercheurs, OpenMusic s'est ainsi doté d'une base considérable d'outils et de connaissances, aujourd'hui encore en continuelle expansion. Avec Musique Lab Maquette, il s'agit d'intégrer cette expérience dans un environnement pédagogique. Cette approche particulière de la composition musicale et de la musique, conçue et analysée par le calcul, constitue en effet un potentiel pédagogique, régi par les différents niveaux de conception des structures musicales permis dans OpenMusic : - Des structures de données adaptées aux représentations musicales (visuelles) et au traitement symbolique; - Des méthodes pour l'inspection, la manipulation, la génération de ces mêmes structures; - Des protocoles pour l'intégration de ces structures dans un contexte musical. Ces trois niveaux se verront reflétés dans la structure conceptuelle de l'application, et seront traités respectivement dans les parties 5, 6 et 7 de cet article. 4. Musique Lab Maquette4.1. Bases technologiquesMusique Lab Maquette est développée sur le noyau fonctionnel et graphique de OpenMusic, ce système lui-même étant basé sur le langage de programmation Common Lisp / CLOS (Common Lisp Object System) (Steele, 1998). L'aspect dynamique de ce langage, particulièrement adapté aux systèmes de composition musicale (Dannenberg et al., 1997), ainsi que les possibilités offertes par la programmation par objets dans CLOS (héritage, programmation par méta objets, etc.) ont permis le développement de cette extension de manière à le faire bénéficier des différents objets et fonctionnalités proposées ou à venir dans l'environnement de CAO. Ces fonctionnalités sont par ailleurs adaptées sous différentes formes qui seront détaillées par la suite : interfaces graphiques, éditeurs, et protocoles ont été créés afin de se prêter à une utilisation dans un cadre pédagogique. 4.2. Plan de travail et documentsLe plan de travail de Musique Lab Maquette est similaire au bureau d'un système d'exploitation, sur lequel des documents sont représentés par des icônes, et organisés graphiquement dans des dossiers (voir figure 2). Un document est associé à un fichier sur le disque dur : il est susceptible d'être exporté, importé, échangé, etc.

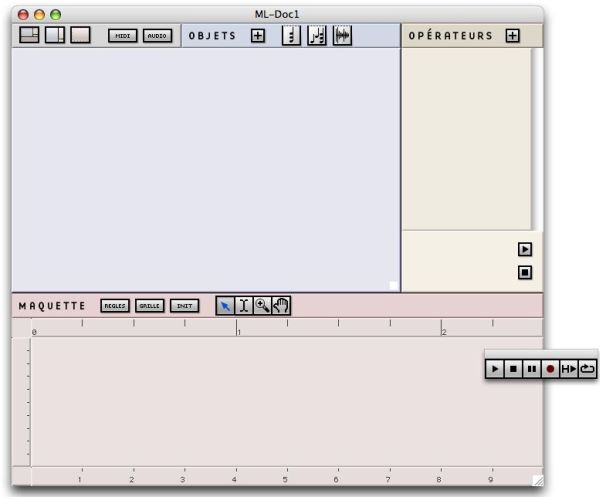

Figure 2 • Le plan de travail dans ML Maquette. Lorsqu'un document est ouvert, il est représenté dans la fenêtre principale de Musique Lab Maquette (illustrée sur la figure 3).

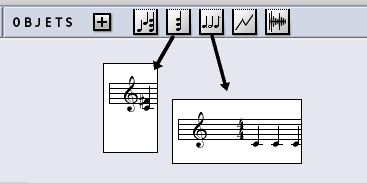

Figure 3 • Un document ML Maquette vierge. 4.3. Base formelle de l'applicationTrois zones peuvent être distinguées sur la fenêtre de la figure 3, appelées respectivement « OBJETS », « OPÉRATEURS » et « MAQUETTE ». La formalisation de l'espace d'un document correspond en effet à des moments de cours, ou à des attitudes mentales spécifiques : agrégation de matériau musical (sans ordre ni métrique particulière), création ou transformation de ce matériau à l'aide d'opérateurs, et organisation de ce matériau. Les trois niveaux d'approche des structures musicales mentionnées précédemment se retrouveront également dans cette partition, avec celui des structures de données (objets et matériau), celui du calcul (transformation et création des objets), et celui l'organisation globale (temporelle). 4.4. Protocole opératoireDans Musique Lab Maquette, les différentes étapes du cycle de vie des structures musicales (instanciation, construction, transformation, organisation) sont réalisées par des opérations de drag and drop (ou glissé/déposé), qui sont la base de l'interaction dans l'environnement. La partie supérieure gauche de la fenêtre est appelée la zone objets. Différentes classes d'objets musicaux (qui seront détaillées dans la partie 5) sont représentées par des icônes dans la barre supérieure de cette zone. Ces classes peuvent être instanciées en glissant l'icône correspondante dans la zone objets (voir figure 4). Un objet est alors représenté par une boîte rectangulaire, mobile sur cet espace, sur laquelle est dessiné un aperçu de son contenu, qui pourra lui-même être édité et écouté.

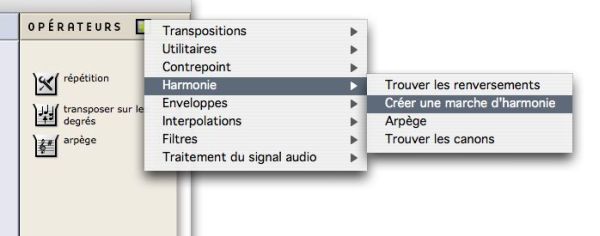

Figure 4 • Instanciation d'objets musicaux en glissant les icônes de classes dans la zone objets. La partie droite de la fenêtre est appelée zone opérateurs. Elle contient une liste d'opérateurs qui pourront être appliqués aux objets provenant de la zone objets. Cette liste est construite par l'utilisateur en choisissant parmi une bibliothèque d'opérateurs disponibles (voir figure 5).

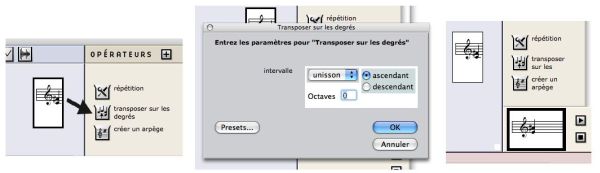

Figure 5 • Sélection des opérateurs dans le menu. Pour appliquer une opération sur un objet, la boîte de l'objet doit être glissée depuis la zone objets sur l'icône correspondant dans la liste d'opérateurs (voir figure 6). Une fenêtre de dialogue apparaît alors, permettant à l'utilisateur de fixer les éventuels paramètres de l'opération. Une fois ces paramètres entrés et confirmés, un nouvel objet est calculé et une nouvelle boîte apparaît dans la zone opérateurs.

Figure 6 • Application d'une transformation sur un objet musical : 1) l'objet (un accord) est glissé sur l'opérateur (une transposition); 2) une fenêtre de dialogue permet d'entrer les paramètres de la transformation (l'intervalle de transposition); 3) un nouvel objet est créé. Cette nouvelle boîte peut alors être glissée dans la zone objets : elle pourra ensuite subir à son tour des transformations. Un cycle de transformation et d'opérations entre les objets peut ainsi être établi, permettant la construction de matériau musical de plus en plus élaboré. Enfin, la zone inférieure de la fenêtre est appelée maquette. Il s'agit d'un séquenceur dans lequel les objets de la zone supérieure peuvent être déposés et assemblés dans le temps, permettant d'effectuer un montage global à partir des structures créés dans les phases précédentes. Des possibilités plus avancées de la maquette seront présentées dans la partie 7. 5. Structures musicales5.1. ObjetsCinq classes d'objets dans Musique Lab Maquette peuvent constituer la « palette » des objets disponibles dans un contexte pédagogique donné (i.e. dans un document) : accord, séquence d'accords, séquence rythmique, enveloppe, et audio (voir figure 7).

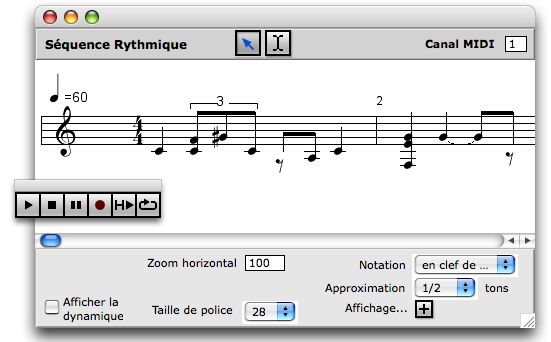

Figure 7 • Objets musicaux. - Un accord représente un ensemble de (une ou plusieurs) notes. Chacune est définie par une hauteur (déterminée suivant une échelle chromatique traditionnelle, ou suivant une échelle en quarts ou huitièmes de tons), par une durée, et une amplitude. - Les séquences et séquences rythmiques représentent des séries d'accords en notation temporelle linéaire ou musicale, respectivement. - Une enveloppe est une courbe par segments représentant l'évolution d'une valeur. - Un objet audio représente un son (fichier audio). Ces différents objets, représentés sur le document par des boîtes, peuvent êtres visualisés et modifiés à l'aide d'éditeurs graphiques dédiés. Les objets musicaux en particulier (accords et séquences) disposent d'éditeurs de type partition (voir figure 8) permettant l'ajout et la suppression de notes, la construction de rythmes (le cas échéant), le contrôle et la visualisation des différents paramètres musicaux (durées, dynamique, etc.)

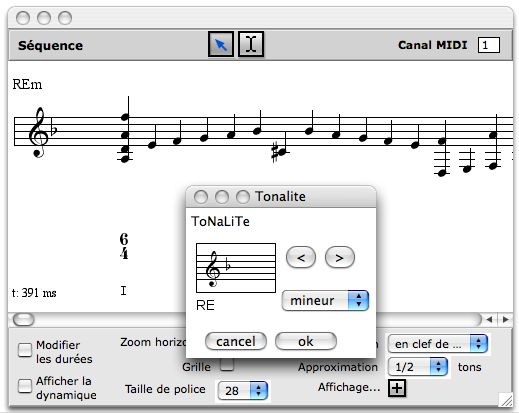

Figure 8 • Éditeur d'un objet de type séquence rythmique. Un objet peut également prendre forme par l'importation de données externes (c'est le cas général pour les fichiers audio). Une séquence d'accord peut par exemple être importée à partir d'un fichier au format MIDI ou d'un fichier d'analyse sonore de type « suivi de partiels » (Hannape et Assayag, 1998). 5.2. Modèle tonalLa majeure partie du répertoire étudié dans les conservatoires se situe dans la période tonale de l’histoire de la musique ; de la même façon, le programme d’étude de l’enseignement général en collège s’appuie sur un socle de notions incluant la tonalité. Afin de se prêter aux manipulations dans ce contexte, les objets musicaux sont dotés d'un modèle de tonalité hiérarchique : une séquence possède une tonalité, et chaque accord à l'intérieur de cette séquence peut avoir sa propre tonalité (ce qui correspond à une modulation), ou ne pas en avoir et hériter ainsi de la séquence qui le contient. Les notions relatives à la tonalité peuvent ainsi être appréhendées à la fois au niveau de la représentation graphique (dans les éditeurs) et au niveau de la structure interne (lors des calculs sur les objets).

Figure 9 • Affectation d'une tonalité dans un éditeur musical. Les éditeurs musicaux permettent ainsi d'assigner une tonalité aux séquences, accords, ou groupes d'accords (voir figure 9). Au plan hiérarchique le plus élevé (celui de l'éditeur), cette tonalité déterminera l'armure de la portée. Dans un contexte tonal donné (tonalité générale ou modulation tonale), les éventuels degrés et chiffrages des accords peuvent alors être déduits et affichés (voir par exemple le premier accord de la séquence musicale représentée sur la figure 9). 6. TransformationsLa seconde partie de la base formelle de Musique Lab Maquette est celle du calcul et des transformations des structures musicales. Celle-ci repose principalement sur une bibliothèque d'opérateurs applicables aux objets musicaux selon le protocole décrit dans la partie 4.4. Les opérateurs de cette bibliothèque sont regroupés en différentes catégories. Dans la partie qui suit, nous donnons un aperçu de ces catégories, illustrées par quelques exemples. Les illustrations y sont simplifiées et montreront les objets initiaux, le dialogue de paramétrage, et l'objet résultant, suivant dans chacun des cas le schéma logique objet – paramètres – résultat. Une partie des opérateurs constituant cette bibliothèque sont dérivés d'outils existants ayant été développés dans OpenMusic par le passé dans un objectif compositionnel ou analytique. D'autres, cependant, ont été créés spécialement pour Musique Lab Maquette. La partie 6.2 traitera du système mis en place pour l'incorporation de fonctions dans la librairie d'opérateurs. 6.1. Opérations musicalesUn premier groupe d'opérateurs est appelé utilitaires et contient diverses fonctions pour les manipulations courantes sur les structures musicales. Les principaux opérateurs existant à l'heure actuelle dans ce groupe sont la concaténation, la répétition (par exemple, créer une séquence à partir d'une autre séquence répétée n fois), l'application d'un motif rythmique sur une mélodie, ou, à l'inverse, d'une ligne mélodique sur un rythme, la conversion d'une séquence en notation linéaire vers une notation rythmique – ou quantification rythmique (Agon, 1994). Ce dernier cas est illustré sur la figure 10.

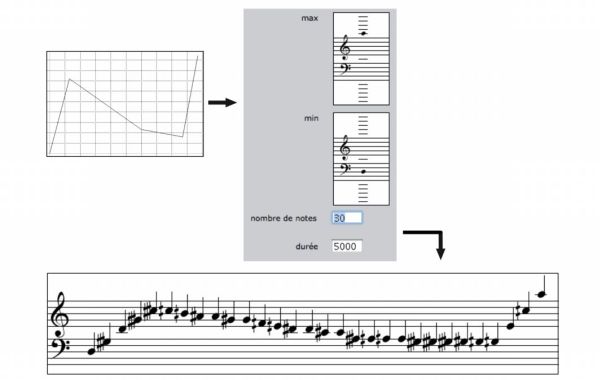

Figure 10 • Conversion d'une séquence d'accords en notation linéaire en une notation rythmique (quantification rythmique). Un second groupe d'opérateurs est dédié au traitement des enveloppes. Une enveloppe représente la courbe d'évolution (pseudo) continue d'une valeur, d'un paramètre abstrait. Les opérateurs correspondants permettent de manipuler cette courbe (lissage, échantillonnage), et/ou de la mettre en correspondance avec divers paramètres musicaux (hauteur, dynamique, etc.) Une ligne mélodique peut par exemple être extraite d'une séquence musicale sous la forme d'une enveloppe, qui pourra être ré-échantillonnée, et utilisée de façon abstraite comme paramètre dans une autre opération, ou simplement appliquée à une autre séquence. Les figures 11 et 12 sont des exemples d'utilisation d'enveloppes pour la génération de profils mélodiques.

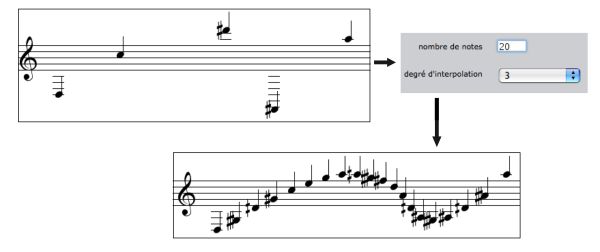

Figure 11 • Création d'une séquence de notes par échantillonnage d'une enveloppe. L'exemple de la figure 12 illustre en particulier la possibilité d'introduire des concepts mathématiques dans le calcul des objets musicaux : une séquence de notes y est créée suivant un algorithme d'interpolation polynomiale (B-spline) à deux dimensions.

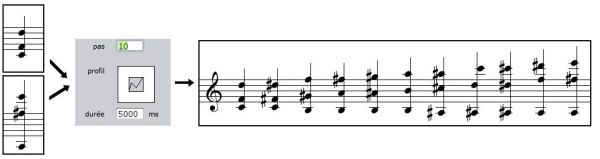

Figure 12 • Création d'une séquence de notes par interpolation polynomiale sur un ensemble de notes initiales. On notera que cette conception continue des paramètres musicaux est permise dans le domaine des hauteurs par les structures de données sous-jacentes : les échelles micro-intervalliques permettent la visualisation et le rendu des séquences musicales avec une précision allant jusqu'au huitième de ton. Les enveloppes entreront également en jeu dans les opérations d'interpolation entre objets musicaux (voir figure 13). Celles-ci permettent de réaliser des interpolations entre des accords (passer de manière pseudo continue d'un groupe de notes à un autre), ou entre des profils mélodiques, de façon linéaire ou suivant un profil d'interpolation donné. Ces interpolations peuvent par ailleurs inclure une correction harmonique (i.e. le respect d'une échelle de hauteurs donnée dans les objets interpolés).

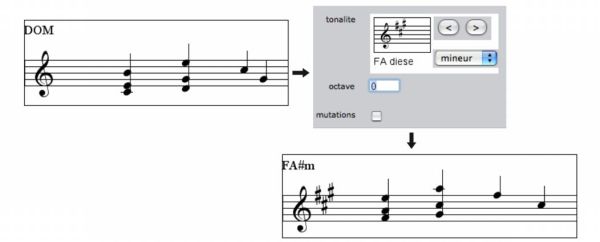

Figure 13 • Interpolation entre deux accords. Divers groupes d'opérateurs évoluent spécifiquement dans le domaine tonal. Le groupe de transpositions est constitué d'un ensemble d'opérateurs permettant de transposer accords ou séquences suivant des intervalles chromatiques fixes (exprimés en demi-tons), suivant des enveloppes, des intervalles musicaux (seconde, tierce, etc.), ou encore d'une tonalité vers une autre (voir figure 14).

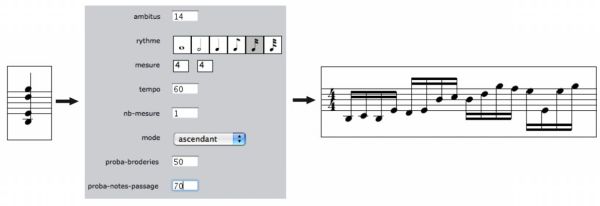

Figure 14 • Exemple de transposition : d'une tonalité (Do Majeur) vers une autre (Fa# mineur). Cette opération est complémentaire à celle illustrée en figure 6, dans laquelle la transposition était spécifiée par un intervalle dans une tonalité unique (le présent exemple s'approchant plutôt de la notion de modulation tonale). L'opérateur d'arpège est une fonction permettant la création d'une arpégiation à partir d'un accord et suivant des spécifications rythmiques et harmoniques telles l'ambitus des hauteurs, ou les probabilités d'apparition de broderies ou de notes de passage (voir figure 15). Différentes configurations de ces paramètres permettent de recréer des styles particuliers, tout en maintenant une diversité dans les résultats grâce aux aspects probabilistes du calcul.

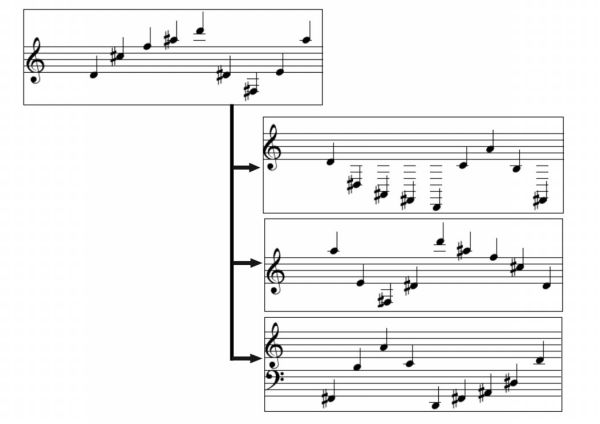

Figure 15 • L'opérateur arpège. D'autres opérateurs harmoniques permettent la recherche de renversements d'accords, ou encore de canons rythmiques. Les opérateurs de contrepoint permettent de réaliser des mouvements contraires et/ou rétrogrades selon le modèle tonal ou sériel (voir figure 16).

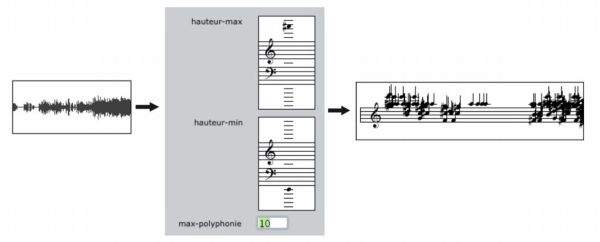

Figure 16 • Trois opérateurs de contrepoint : mouvement contraire, mouvement rétrograde, et mouvement contraire et rétrograde. Dans ces cas, il n'y a pas de dialogue de paramétrage, étant donné que ces opérateurs ne nécessitent aucun paramètre additionnel pour effectuer le calcul. Enfin, une série d'opérateurs est dédiée au traitement du signal sonore. Ceux-ci permettent l'extraction de données de description à partir d'objets audio, ou encore la création de sons à partir de données musicales. Ces outils sont basés sur le programme pm2, développé à l'IRCAM par l'équipe Analyse/Synthèse, et adaptés de travaux menés dans OpenMusic concernant l'intégration de cet outil dans les processus compositionnels (Bresson, 2006). Les principales fonctions disponibles à l'heure actuelle concernent : - l'estimation et le suivi de la fréquence fondamentale (Doval et Rodet, 1991), qui produit une courbe temps/fréquence correspondant à l'évolution supposée de la fréquence fondamentale d'un son harmonique; - le suivi de partiels (MacAulay et Quatieri, 1986), qui détecte et suit l'évolution des principaux composants sinusoïdaux du spectre sonore, et dont le résultat est converti en séquence d'accords (voir figure 17); - la synthèse additive, qui permet de créer un fichier audio en additionnant les composantes sinusoïdales correspondant aux différentes notes d'une séquence musicale.

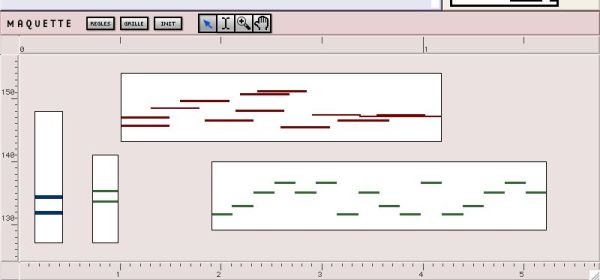

Figure 17 • Suivi de partiels d'un son. L'analyse retourne une séquence d'accords correspondant aux principaux partiels détectés. L'utilisation du son et des descriptions sonores dans l'environnement de travail et leur mise en relation avec les objets et processus compositionnels font partie des pratiques courantes des compositeurs contemporains. La reproduction de ces opérations par des méthodes d'interaction élémentaires permet ainsi une expérimentation sur leur signification technique et musicale. 6.2. Aspects dynamiques de la bibliothèqueChaque élément de la bibliothèque d'opérateurs se réfère à une fonction générique écrite en Lisp, et est représenté sur le document par une icône. Les différentes transformations sur les objets musicaux présentées dans les parties et exemples précédents sont appliquées en glissant l'objet sur cette icône, suite à quoi une fenêtre présente un « formulaire » de paramétrage à l'utilisateur. Ce formulaire est créé dynamiquement selon l'objet de la transformation et la méthode correspondant à celui-ci. Cette procédure est réalisée à l'aide de fonctionnalités offertes par le protocole de méta objets – ou MOP, Meta-Object Protocol – de CLOS (Kiczales et al., 1991). Le MOP permet la réflexivité du langage orienté objet, c'est-à-dire que les éléments qui constituent ce langage peuvent devenir les objets de traitement du programme. En d'autres termes, les classes, fonctions, méthodes qui constituent un programme peuvent être créées, inspectées et manipulées dynamiquement pendant que ce programme s'exécute. Le formulaire de paramétrage est donc créé en inspectant la méthode désignée par l'opération et spécialisée par l'objet, ainsi que ses différents arguments, afin d'en déterminer les types, les valeurs par défaut, etc. Les composants graphiques de l'interface sont alors générés automatiquement et disposés sur la fenêtre de dialogue. Des types spécifiques ont ainsi été créés, et se sont vus assigner des composants graphiques adaptés : types simples comme un entier, une liste à choix multiples, un booléen, mais également structures plus complexes, spécifiquement musicales, comme un monnayage rythmique (voir figure 15, par exemple), une tonalité (figure 14), un intervalle (figure 6), etc. Ce protocole facilite donc l'extensibilité de l'application, étant donné que l'ajout de nouveaux opérateurs nécessite uniquement l'enregistrement d'une ou plusieurs méthodes Lisp dans la bibliothèque d'opérateurs, pourvu que celles-ci soient spécialisées en leur premier argument par l'un des objets supportés dans Musique Lab Maquette (accord, séquence, etc.) et par les types mentionnés ci-dessus pour leurs arguments additionnels. Le protocole d'appel fonctionnel et l'interface du formulaire se mettent alors en place naturellement. Enfin, ce protocole a permis d'implanter un système de préréglages pour l'enregistrement et le rappel d'ensemble de paramètres correspondant aux différents opérateurs. Cet aspect dynamique et extensible de la bibliothèque d'opérateurs nous semble être un aspect fondamental du projet dans lequel s'inscrit cette application. Les développements et évolutions à venir permettront en effet d'enrichir et de compléter cette bibliothèque afin d'aborder des champs d'application, des formalismes et des esthétiques variées. 7. Déploiement des objets musicauxLa partie inférieure du document est appelée maquette, en référence à l'interface de programmation du logiciel OpenMusic qui porte le même nom et dont elle hérite une grande partie des fonctionnalités. Elle correspond en outre à la troisième des approches du matériau musical mentionnées dans la partie 3, consistant en l'organisation et le déploiement des objets dans un contexte temporel global. La séparation de ce concept et de celui de la création du matériau musical (hors des structures temporelles) reflète une position compositionnelle relativement répandue – voir par exemple les notions « en temps » et « hors temps » chez Xenakis (Xenakis, 1981) – et permet de se focaliser indépendamment sur ces deux différents aspects. Les objets musicaux provenant de la zone objets (issus du calcul ou créés manuellement dans les éditeurs) peuvent donc être glissés dans la zone maquette. Ils sont alors représentés par un autre type de boîte rectangulaire, dont les attributs graphiques (position, taille) revêtent une nouvelle signification temporelle et fonctionnelle. 7.1. Organisation du matériau musicalL'axe horizontal de la zone maquette représente le temps, selon le modèle des séquenceurs musicaux classiques. Le premier et principal usage de la maquette consiste donc en la réalisation du montage et de l'ordonnancement d'objets musicaux. La position des boîtes sur cet axe horizontal représente la date d'entrée des objets dans le référentiel temporel global, et leur extension détermine leur durée (les objets musicaux peuvent ainsi être étirés ou compressés dans le temps en déformant les boîtes.) L'échelle de temps est spécifiée soit en temps « absolu » (i. e. en millisecondes), soit à l'aide d'une métrique et d'un tempo. Dans les deux cas, une unité minimale peut être spécifiée, permettant de placer précisément les objets. La maquette peut finalement être « jouée », à la manière d'un séquenceur, à l'aide de contrôles classiques (play, pause, etc.) La figure 18 montre des objets disposés sur la zone maquette d'un document.

Figure 18 • La zone maquette. Afin de proposer une représentation conjointe cohérente des différents objets musicaux, la notation musicale utilisée pour représenter le contenu des boîtes est substituée par une représentation linéaire de type piano roll. Cependant, les objets contenus dans les boîtes restent éditables à l'aide des éditeurs musicaux. Les différents attributs visuels des boîtes (intitulé, couleur, attachement d'une image) sont modifiables par l'utilisateur, lui permettant d'organiser et de singulariser ses objets. Enfin, un système de pistes MIDI et audio permet le contrôle interactif des paramètres d'exécution (volume, panoramique) par l'intermédiaire de consoles de mixage (voir figure 19). Sur la console MIDI, le choix de timbres instrumentaux (programmes MIDI) pour les différents canaux permet de réaliser des simulations d'instrumentations.

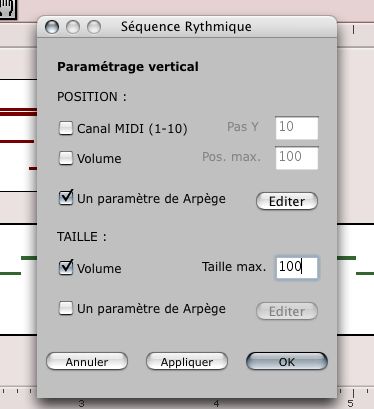

Figure 19 • Console de mixage MIDI. Sur la figure 19, le canal de droite (intitulé « microplayer ») est un canal virtuel vers lequel sont redirigés les objets spécifiés dans des échelles micro-tonales (quarts ou huitièmes de tons), et permettant un rendu micro-intervallique de ces objets. 7.2. Objets potentielsComplémentairement à leur rôle structurant dans la dimension temporelle, les attributs graphiques des boîtes disposées dans la zone maquette peuvent également avoir une signification « fonctionnelle ». La position des boîtes sur l'axe vertical, et leur taille selon ce même axe, peuvent être utilisés pour définir ce que nous appellerons des « objets potentiels ». Ces paramètres peuvent en effet avoir une influence sur le contenu même de la boîte. À un premier niveau, ils pourront être utilisés pour contrôler le volume de l'objet (par exemple, plus l'objet est disposé en hauteur, plus son niveau est élevé) ou le canal MIDI (afin de changer dynamiquement le timbre instrumental). Ainsi, à chaque fois que la boîte est redimensionnée ou déplacée, l'objet musical qu'elle renferme est modifié, selon une correspondance fixée entre les attributs de cet objet et les unités de l'axe vertical de la maquette. Ces propriétés comportementales sont spécifiées à l'aide de la fenêtre de paramétrage visible sur la figure 20.

Figure 20 • Paramétrage des propriétés des boîtes. Dans certains cas, l'utilisation de ces attributs graphiques pour la spécification de paramètres fonctionnels peut également faire sens : un objet glissé dans la zone maquette garde une mémoire de l'opérateur qui l'a créé (s'il a été créé par un opérateur), ainsi que de l'objet à partir duquel il a été créé et des paramètres de cette opération. Cet objet dispose donc de toute l'information requise pour se recalculer si nécessaire, éventuellement en modifiant certains de ces paramètres. Les attributs graphiques de la boîte (position et taille) peuvent donc intervenir à ce niveau, et revêtir une dimension nouvelle. Pour ce faire, l'utilisateur doit également spécifier une correspondance entre la plage de variation de l'un des paramètres de l'opérateur et les unités graphiques de la maquette. A chaque redimensionnement ou déplacement de la boîte, cette fois, l'objet est recalculé et prend une nouvelle forme. Différentes instances d'un même « objet potentiel » (les copies d'une boîte initiale unique paramétrée de la sorte) pourront ainsi avoir des valeurs différentes selon leur position et/ou leur taille. Ce système se montre utile et pertinent dans des situations d'enseignement : un tel objet, considéré à l'aide d'une fonction et d'un ensemble de données, comme un potentiel de réalisations musicales plutôt que comme une structure constante, permet en effet d'apprécier dynamiquement l'influence des différents paramètres musicaux. Parmi les opérateurs évoqués précédemment, on pourra par exemple utiliser ce principe avec la génération d'arpèges – par exemple, plus un objet est disposé en hauteur sur la maquette, plus grande est la probabilité d'apparition de notes de passage ; plus la boîte est grosse, plus l'arpège s'étend en ambitus – ou sur les intervalles de transposition d'objets mélodiques – par exemple pour la construction de canons. La figure 21 est une illustration de l'exemple de la construction d'arpèges : une séquence créée avec cet opérateur (à partir d'un accord) a été glissée dans la maquette. Les paramètres de la boîte correspondante ont alors été réglés de sorte que l'ambitus de l'arpège soit fonction de la position verticale de cette boîte. Cette boîte est ensuite dupliquée dans le temps, avec des positions verticales différentes, produisant les arpèges correspondants : les arpèges sont de plus en plus « étendus » en fonction de ces positions.

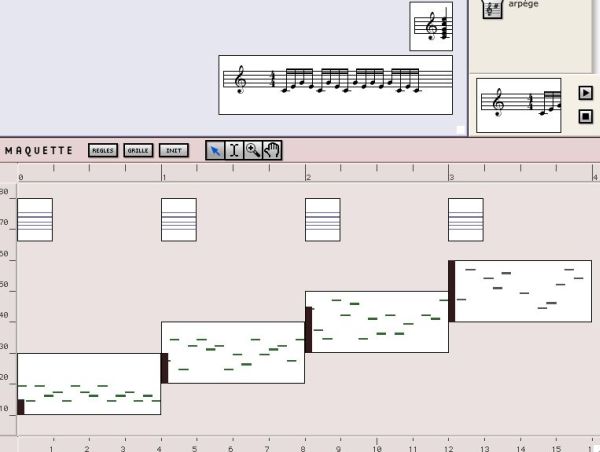

Figure 21 • Utilisation du calcul dynamique des objets dans la maquette. 8. Enjeux pédagogiques et éléments d'évaluationMusique Lab Maquette et les autres applications du projet (Musique Lab Annotation et Musique Lab Audio) ne sont pas diffusées à grande échelle à l'heure actuelle ; ainsi est-il encore difficile d'obtenir des éléments formellement fondés et objectifs sur leur évaluation. Des expériences ont cependant été mises en place par l'équipe pédagogique de l'IRCAM ainsi que par des professeurs de collège et de conservatoires dans des classes ou ateliers de musique, et permettent d'ores et déjà de tirer des premières conclusions sur l'utilisation de ces outils en situation de cours. Ces expériences ont mis en évidence différents cas d’utilisation concernant les enseignements généralistes et les enseignements spécialisés. De manière générale, elles consistent en une phase de démonstration, dans laquelle le professeur utilise les applications projetées sur un écran, et en une phase d'utilisation par les élèves, sur des postes informatiques individuels, et sur la base de documents préparés par le professeur ou construits en interaction avec celui-ci. 8.1. Utilisation dans le cadre d'enseignements généralistesLe programme d’enseignement musical du collège est articulé autour de deux grands axes : l’acquisition d’une culture musicale (histoire de la musique, connaissance des instruments de l’orchestre, analyse – sans faire appel au solfège), et l’acquisition de compétences musicales (développement de l’oreille, reconnaissance de thèmes, d’instruments, pratique musicale minimale – flûte à bec dans certains cas, mais aussi percussions, ou informatique musicale lorsque l’établissement est équipé.) Dans ce contexte, les acteurs sont d’une part l’enseignant, qui accède à l’ensemble des équipements (piano, chaîne hi fi, tableau) pour soutenir son cours, et d'autre part l’ensemble des élèves (entre 24 et 35) dont l’accès aux ressources sonores est contrôlé par l’enseignant. Le premier cas d'utilisation de Musique Lab Maquette est celui du tableau « réactif », réalisé en projetant l'ordinateur de l'enseignant sur un écran. Il ne s’agit pas alors de pédagogie novatrice, mais d’un auxiliaire du cours. Il n’est pas rare en effet qu’un enseignant se déplace constamment entre un tableau, pour écrire, un piano, pour jouer un thème, une chaîne stéréo, pour faire entendre un enregistrement. Musique Lab Maquette apporte à cette situation une facilité d’emploi qui permet d’agréger dans un document le matériau permettant d’alimenter une argumentation, soit en « jouant » les objets préalablement calculés, soit en les construisant sous les yeux des élèves. Un deuxième cas rencontré est celui de l’analyse ou la reconstruction d’une œuvre. Des documents ont été élaborés à cet effet dans Musique Lab Maquette, afin de permettre la reconstruction de processus musicaux (par exemple avec La Rousserolle Effarvatte, ou la Liturgie de Cristal de Messiaen), voire parfois d'œuvres entières (l'Offrande Musicale, ou les Variations Goldberg de Bach.) Les documents se déclinent alors en deux parties, que l'on pourrait appeler, pour reprendre une image venant de l’édition scolaire, le « livre du professeur » et le « livre de l’élève ». Le document de l’élève est souvent formulé sous la forme d’une question surmontant des éléments constituant un matériau de base d'une œuvre étudiée, et accompagnée des opérateurs nécessaires à sa reconstruction. Dans ce scénario pédagogique, chaque élève dispose d’une machine et doit reproduire l’œuvre de la façon qui lui semble la plus simple. La figure 22 présente un document de ce type pouvant être proposé à un élève.

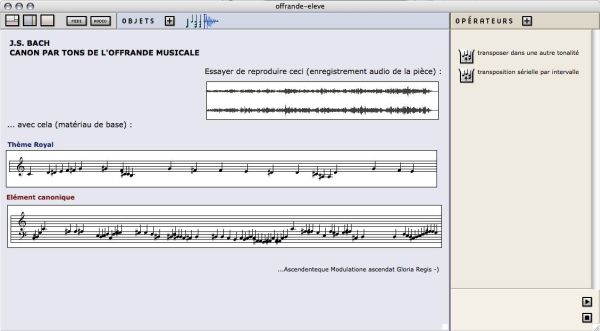

Figure 22 • Le « livre de l'élève » proposé pour la reconstruction du canon par tons de l'Offrande Musicale (J. S. Bach.) Enfin, le troisième cas d'utilisation concerne les projets de création. Il arrive en effet que certains enseignants bénéficient d’un contexte favorable à l’élaboration de projets de ce type, généralement étendus sur une année. Il peut alors s'agir, par exemple, d'un projet singulier de concert, d’installation, ou d'un projet associant plusieurs enseignants de disciplines complémentaires. Musique Lab Maquette est alors utilisé pour l'élaboration de matériau musical, et éventuellement associé à Musique Lab Audio afin de réaliser des traitements contrôlés par le geste sur ce matériau. La figure 23 montre des élèves travaillant avec Musique Lab Maquette dans le cadre d'un tel projet.

Figure 23. Elèves du collège Lavoisier à Paris travaillant sur un projet de création avec Musique Lab Maquette. 8.2. Utilisation dans le cadre d'enseignements spécialisésMalgré des programmes établis par les textes officiels, les enseignements spécialisés, par leur nature, créent une profusion de situations hétérogènes. Dans un cours de formation musicale, Musique Lab Maquette peut être utilisée pour des exercices d’oreille, augmentant la « dictée » traditionnelle d’une dimension nouvelle, comme par exemple celui de reconnaître et d'apparier des structures musicales créées et ajustées dynamiquement. La figure 24 est un exemple d'exercice de ce type.

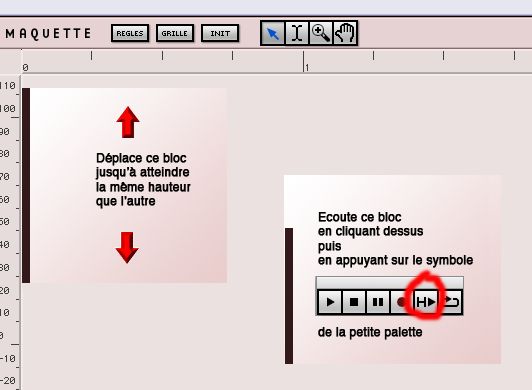

Figure 24. Un exercice d'oreille dans la maquette : utiliser les déplacement d'un objet pour atteindre un état (sonore) donné, en référence à un autre objet. Dans un cours d'analyse, Musique Lab Maquette permettra de décliner une analyse formelle sous la forme de documents pédagogiques adaptés à des situations de cours ou de niveaux différents (le modèle tonal mis en place dans les structures musicales permet notamment de représenter aisément des analyses harmoniques). Enfin, dans un cours d’harmonie ou de contrepoint, on pourra générer du matériau musical correspondant à une formule d'écriture étudiée en association avec un geste, selon le procédé que nous avons détaillé dans la partie 7.2 (marches d’harmonies recalculées en fonction de la position verticale des objets, arpèges dont on fait varier les notes étrangères, etc.) Musique Lab Maquette est également utilisée dans des ateliers pédagogiques réalisés à l'IRCAM, notamment ceux liés à la musique spectrale. Ces ateliers s'adressent à des élèves partant de la classe de 4ème jusqu'à des étudiants en musique d'universités ou de conservatoires. Après avoir écouté un son et visualisé les partiels dont il est constitué, la relation entre le son (acoustique) et sa représentation symbolique en hauteurs (qui est un fondement de la musique spectrale) est comprise directement par les élèves, et peut être intuitivement expérimentée grâce aux opérateurs simples et puissants d'analyse ou de synthèse sonore proposés. En faisant glisser une note sur un opérateur comme construire un spectre, et en écoutant le résultat en huitièmes de ton ou en demi-tons seulement, ceux-ci expérimentent et font écho de l'importance de la notation en micro-intervalles, de la proximité de l'harmonie et du timbre, ainsi que de la sensation de fusion qui est recherchée par les compositeurs spectraux. Les élèves réalisent alors eux-mêmes des séquences musicales dans la zone maquette en s'inspirant de pièces étudiées, séquences dont la qualité est une preuve de la compréhension de ces concepts, perceptivement pertinents et musicalement riches. Parmi les œuvres ayant fait l'objet de ce type d'expérience, on trouve notamment Partiels de Grisey, Désintégrations de Murail, ou encore Le plein du vide de Xu Yi, cette année au programme du baccalauréat. Ce principe pédagogique de recomposition, que nous avons déjà évoqué précédemment, permet ainsi une réappropriation de l'écoute des pièces. La figure 25 montre un exemple de document Musique Lab Maquette créé par un élève au cours d'un atelier autour de la pièce de Xu Yi, Le plein du vide.

Figure 25 • Exemple de travail réalisé par un élève dans Musique Lab Maquette. 8.3. Un premier bilanSelon ces quelques expériences, Musique Lab Maquette s'est montré un outil d'enseignement musical pertinent sous différents points de vue. De manière générale, on pourra évoquer un impact sur la compréhension et la mémorisation des concepts : associer un geste, une action (par exemple faire glisser un objet sur un opérateur), à une explication théorique permet une meilleure acquisition des notions étudiées. Cette action associe en effet la mémoire habituellement sollicitée dans une explication orale à une mémoire tactile, physique : il faut agir pour construire un matériau, ou un raisonnement. Le document de travail et ses fonctionnalités s’avèrent par ailleurs un efficace « établi musical » permettant de conserver de semaine en semaine un état d’avancement. De cette façon, un enseignant peut facilement avoir accès à une représentation du degré de confusion ou au contraire de maîtrise dans les différentes étapes par lesquelles sont passés les élèves pour atteindre un résultat. Afin d’éviter les pièges posés par la facilité avec laquelle une certaine complexité musicale pourrait être élaborée sans forcément être comprise, un effort a été fait pour multiplier les opérateurs faisant des choses relativement « simples » plutôt que des opérateurs complexes assortis d’une multitude de paramètres. En conséquence, chaque construction constitue une démarche progressive, qui nécessite un support pédagogique d'autant plus présent. Il apparaît ainsi primordial avec Musique Lab 2 de fournir à l'utilisateur des scénarios et situations préétablies et à explorer afin d'initier une interaction autonome. Cette remarque est valable pour les élèves comme pour les enseignants, pour lesquels l'appropriation de l'environnement peut se révéler délicate dans une première approche. Les supports de cours élaborés et fournis en complément des applications pourront alors être personnalisés par les enseignants selon des orientations pédagogiques ou des niveaux de connaissances musicales visés, et partagés entre enseignants ou distribués aux élèves. 9. ConclusionDans cet article, nous avons présenté une réalisation dans le domaine des outils informatiques dédiés à l'enseignement musical, basée sur des concepts d'écriture et de composition. Cette approche originale est permise par le potentiel et les représentations d'un environnement de calcul initialement dédié à la composition ; les interfaces et protocoles mis en place dans l'application ayant pour objectif de détourner cette orientation pour produire un outil d'apprentissage et de compréhension. Dans Musique Lab Maquette se retrouvent certaines notions importantes et caractéristiques des micromondes, notamment avec l'idée de programmation de processus (musicaux), de combinaison de ces processus, à partir d'un ensemble restreint de structures et d'éléments fonctionnels. Musique Lab Maquette (et l'ensemble des logiciels Musique Lab 2) vise avant tout une utilisation en classe, c'est-à-dire en complément d'une interaction avec un professeur. Celui-ci pourra l'utiliser pour la démonstration des concepts musicaux et des mécanismes de la composition, ainsi que pour des expériences pédagogiques autour de ces concepts et d'œuvres musicales. Les trois positions adoptées dans Musique Lab Maquette, que nous avons essayées de souligner, tendent à reconstituer une attitude compositionnelle dont l'approche expérimentale et interactive est susceptible de stimuler intérêt et créativité de la part des élèves des classes de musique. Nous avons également relevé l'importance et la nécessité de mettre des scénarios pédagogiques, ou ensemble d'activités et de problèmes proposés, à disposition des utilisateurs. Ainsi, les développements à venir dans ce projet devraient élargir son champ d'application, par la création de nouveaux opérateurs et objets musicaux, mais également s'attacher à produire et favoriser les échanges de documents et de supports de cours. Un projet de réalisation d'explorations interactive de pièces musicales du répertoire à l'aide des outils Musique Lab 2 (Musique Lab Maquette, mais aussi Musique Lab Audio et Musique Lab Annotation) est également envisagé. 10. RemerciementsLes auteurs souhaitent remercier Grégoire Lorieux, Charlotte Truchet et Carlos Agon pour leur participation, ainsi que les professeurs ayant contribué à l'élaboration de ce projet. BIBLIOGRAPHIEAGON C. (1994). Kant: Une critique de la quantification pure. Mémoire de DEA d'Informatique. Université de Paris XI, France. AGON C. (1998). OpenMusic: Un Langage Visuel pour la Composition Assistée par Ordinateur. Thèse de Doctorat. Université Pierre et Marie Curie (Paris VI), France. AGON C., ASSAYAG G., DELERUE O., RUEDA C. (1998). Objects, Time and Constraints in OpenMusic. Proceedings of the International Computer Music Conference, Ann Arbor, USA, pp. 406-415. AGON C. (2004). Langages de programmation pour la composition musicale. Habilitation à Diriger des Recherches, Université Pierre et Marie Curie (Paris VI), France. ANDREATTA M. (2004). On group-theoretical methods applied to music: some compositional and implementational aspects. In Mazzola et al. (Eds) Perspectives in Mathematical and Computational Music Theory, Electronic Publishing Osnabrück, pp.169-193. ASSAYAG G. (1993). CAO : vers la partition potentielle. In Les Cahiers de l'IRCAM : La Composition Assistée par Ordinateur, pp. 13-41. ASSAYAG G., AGON C., FINEBERG J., HANAPPE P. (1997). Problèmes de notation dans la composition assistée par ordinateur. Actes des rencontres musicales pluridisciplinaires, Musique et Notation. Lyon, France. ASSAYAG G., RUEDA C., LAURSON M., AGON C., DELERUE O. (1999). Computer Assisted Composition at Ircam: PatchWork & OpenMusic. Computer Music Journal, Vol. 23 n°3, pp. 59-72. ASSAYAG G., BEJERANO G., DUBNOV S., LARTILLOT O. (2001) Automatic modeling of musical style. Actes des 8èmes Journées d'Informatique Musicale, Bourges, France, pp. 113-119. BRESSON J., AGON C., ASSAYAG G. (2005). OpenMusic 5: A Cross-Platform Release of the Computer-Aided Composition Environment. Proceedings of the 10th Brazilian Symposium on Computer Music, Belo Horizonte, Brazil, pp. 1-12. BRESSON J. (2006). Sound Processing in OpenMusic. Proceedings of the 9th International Conference on Digital Audio Effects DAFX'06, Montreal, Canada, pp. 325-330. BRESSON J., AGON C. (2006). Temporal Control over Sound Synthesis Processes. Proceedings of the Sound and Music Computing Conference SMC'06, Marseille, France, pp.67-76. CAPPONI B., LABORDE J. M. (1998) Actes de l'Université d'été : Cabri-géomètre, de l'ordinateur à la calculatrice. De nouveaux outils pour l'enseignement de la géométrie. DANNENBERG R., DESAIN P., HONING H. (1997). Programming Language Design for Music. In Roads C. et al. (Eds) Musical Signal Processing, Swets and Zeitlinger, pp. 271-315. DESAIN P., HONING H. (1988). LOCO: A Composition Microworld in Logo. Computer Music Journal, Vol. 12 n°3, pp. 30-42. DOVAL B., RODET X. (1991). Estimation of Fundamental Frequency of Musical Sound Signals. Proceedings of the IEEE International Conference on Acoustics, Speech and Signal Processing ICASSP, Toronto, Canada, pp. 3657-3660. GUÉDY F. (2006). Musique Lab 2, un environnement pour la pédagogie musicale. L'Inouï, Vol. 2, Ircam – Editions Léo Scheer, pp. 149-153. HANNAPE P., ASSAYAG G. (1998). Intégration des représentations temps/fréquence et des représentations musicales symboliques. In Chemiller M., Pachet F. (Eds) Recherches et applications en informatique musicale, Hermes, France, pp. 199-207. HONING H. (1993). A microworld approach to the formalization of musical knowledge. Computer and the Humanities, 27, pp. 41-47. KICZALES G., DES RIVIERES J., BOBROW D. G. (1991). The Art of the Metaobject Protocol, MIT Press. MACAULAY R. J., QUATIERI T. F. (1986). Speech analysis/synthesis based on a sinusoidal representation. IEEE Transactions on Acoustics, Speech and Signal Processing, Vol. 34 n°4, pp. 744-754. PUIG V., GUÉDY F., FINGERHUT M., SERRIèRE F., BRESSON J., ZELLER O. (2005). Musique Lab 2: A Three Level Approach for Music Education at School. Procceedings of the International Computer Music Conference, Barcelona, Spain, pp. 419-422. SCHOONDERWALDT E., HANSEN K., ASKENFELT A. (2004). IMUTUS - an interactive system for learning to play a musical instrument. Proceedings of the International Conference of Interactive Computer Aided Learning (ICL), Villach, Austria. STEELE G. L. (1998). Common LISP The language, second edition, Digital Press, USA. XENAKIS I. (1981). Musiques Formelles. Stock Musique, France. Sites Internet- Site internet du projet européen i-Maestro : http://www.i-maestro.net/ - JIM'07 : Journées d'Informatique Musicale 2007 : http://www.grame.fr/jim07/ - Site internet Musique Lab de l'IRCAM : http://musiquelab.ircam.fr - EducNet – Portail Internet Education Musicale et Technologies de l'Information de la Création et de la Communication : http://www.educnet.education.fr/musique/

| ||||

Référence de l'article :Jean Bresson, Fabrice Guédy, Gérard Assayag, Musique Lab Maquette : approche interactive des processus compositionnels pour la pédagogie musicale, Revue STICEF, Volume 13, 2006, ISSN : 1764-7223, mis en ligne le 30/01/2007, http://sticef.org |