Sciences et Technologies

Sciences et Technologies de l´Information et

de la Communication pour

l´Éducation et la Formation

Volume 25, 2018

Article de recherche

Numéro Spécial

Sélection de la conférence

EIAH 2017

Suivre l’engagement des apprenants dans l’activité de construction de cartes mentales

![]() RÉSUMÉ : Notre

travail a pour objectif d’aider les enseignants à suivre

l’engagement des apprenants pendant des activités de construction

de cartes mentales. Les cartes mentales sont utilisées pour aider les

apprenants à organiser les contenus étudiés en classe.

Étant donnée la complexité des cartes, les enseignants ont

besoin d’outils qui assistent la compréhension des cartes produites

et de leur processus de construction. Nous avons défini avec des

enseignants un ensemble d’indicateurs d’engagement, reposant sur les

traces d’interaction des apprenants. Ces indicateurs ont été

implémentés dans un tableau de bord à destination des

enseignants. Cet article présente la première version du tableau

de bord implémenté, sa conception, son implémentation et

les résultats d’une évaluation sur les aspects

d’utilisabilité et d’utilité.

RÉSUMÉ : Notre

travail a pour objectif d’aider les enseignants à suivre

l’engagement des apprenants pendant des activités de construction

de cartes mentales. Les cartes mentales sont utilisées pour aider les

apprenants à organiser les contenus étudiés en classe.

Étant donnée la complexité des cartes, les enseignants ont

besoin d’outils qui assistent la compréhension des cartes produites

et de leur processus de construction. Nous avons défini avec des

enseignants un ensemble d’indicateurs d’engagement, reposant sur les

traces d’interaction des apprenants. Ces indicateurs ont été

implémentés dans un tableau de bord à destination des

enseignants. Cet article présente la première version du tableau

de bord implémenté, sa conception, son implémentation et

les résultats d’une évaluation sur les aspects

d’utilisabilité et d’utilité.

![]() MOTS CLÉS : Engagement,

tableau de bord, carte mentale, visualisation, traces d’interaction,

xAPI.

MOTS CLÉS : Engagement,

tableau de bord, carte mentale, visualisation, traces d’interaction,

xAPI.

![]() ABSTRACT : Our

work aims at helping teachers to monitor learners’ engagement during mind

mapping activities. Teachers use mind maps to make students organize topics and

learn contents. To assess these mind maps, teachers need tools to understand

students’ choices during construction. In collaboration with teachers we

have defined a set of indicators based upon learners’ interaction traces.

Those indicators have been implemented in a dashboard dedicated to teachers. In

this paper, we introduce the first version of the dashboard and describe its

design, implementation, and the results of an evaluation based on usability and

utility aspects.

ABSTRACT : Our

work aims at helping teachers to monitor learners’ engagement during mind

mapping activities. Teachers use mind maps to make students organize topics and

learn contents. To assess these mind maps, teachers need tools to understand

students’ choices during construction. In collaboration with teachers we

have defined a set of indicators based upon learners’ interaction traces.

Those indicators have been implemented in a dashboard dedicated to teachers. In

this paper, we introduce the first version of the dashboard and describe its

design, implementation, and the results of an evaluation based on usability and

utility aspects.

![]() KEYWORDS : Engagement,

dashboard, mind mapping, visualization, interaction traces, xAPI.

KEYWORDS : Engagement,

dashboard, mind mapping, visualization, interaction traces, xAPI.

1. Introduction

L’utilisation de cartes mentales et de cartes conceptuelles en classe est une pratique de plus en plus répandue (Eppler, 2006). Ce type d’exercice permet aux élèves de mettre en place des stratégies personnelles d’apprentissage en élaborant et en organisant les contenus étudiés. Les enseignants considèrent que la richesse d’expression offerte aux élèves qui élaborent des cartes mentales est un des points forts de cet outil. Cette richesse devient cependant un défi lorsqu’ils doivent interpréter et évaluer les productions des élèves. Comme les exercices demandés n’ont pas de solution unique, comprendre les processus de construction de chaque carte mentale devient précieux. C’est de plus dans ces processus de construction que les enseignants peuvent trouver des réponses sur les choix particuliers ayant conduit les élèves à construire telle ou telle carte finale.

L’objectif de notre travail est de proposer aux enseignants des indicateurs qui reflètent la manière dont les apprenants s’engagent tout au long de l’activité de construction de cartes mentales. Il s’agit de fournir aux enseignants des éléments soutenant une éventuelle intervention. De tels éléments ne peuvent être déterminés uniquement à partir de la carte finale, l’engagement des apprenants ayant lieu tout au long du processus de construction de la carte. Nous proposons d’aborder l’engagement dans ses dimensions comportementale et cognitive (Fredricks et al., 2004). Les indicateurs d’engagement comportemental traduisent entre autres la manière dont les apprenants utilisent un outil (p. ex. nombre et types d’actions), alors que les indicateurs d’engagement cognitif reflètent le processus de construction des cartes mentales (p. ex. création et suppression de nœuds et liens). La construction des indicateurs s’appuie sur les traces d’activité collectées lors de l’utilisation de l’outil de construction de cartes mentales.

Dans cet article nous répondons à deux questions de recherche :

- Quels indicateurs permettent le suivi de l’engagement lors de la construction de cartes mentales ?

- Comment représenter ces indicateurs dans un tableau de bord ?

Nous proposons différents indicateurs pour le suivi de l’engagement des apprenants que nous avons définis à partir d’entretiens avec les enseignants, ainsi qu’un tableau de bord construit à partir des traces d’activité des élèves. Une première évaluation de ces indicateurs et du tableau de bord a été réalisée.

La première section de l’article est dédiée à la présentation des cartes mentales comme support pour la construction de connaissances, aux propositions qui ont été faites pour les évaluer, à la notion d’engagement scolaire, et à une revue des tableaux de bord présentant des indicateurs d’engagement. La deuxième section est consacrée à la démarche de conception que nous avons utilisée pour définir les différents indicateurs et concevoir leurs visualisations. La troisième section présente nos propositions d’indicateurs, le tableau de bord développé et l’architecture d’implémentation choisie. La dernière section décrit la démarche suivie pour valider notre tableau de bord. Les résultats de cette validation sont présentés et discutés en vue du travail futur.

2. État de l’art

2.1. Évaluation des cartes mentales

2.1.1. Les cartes mentales

Les cartes mentales sont des listes de mots structurées et organisées en arborescence pour représenter une idée, un concept, un projet, un plan (Buzan et al., 2012). Les cartes conceptuelles sont des schémas utilisés pour organiser et représenter des relations entre des concepts (Novak et Cañas, 2007). Malgré ces différences, ces deux types de diagrammes ont en commun la représentation graphique de relations, au lieu de descriptions verbales ou écrites (Davies, 2011). Généralement, les éléments représentant des idées ou des concepts sont identifiés comme des « nœuds » et les relations entre ceux-ci comme des « liens ». Dans le travail présenté ici, nous utilisons un outil de construction de cartes mentales appelé Renkan (https://www.iri.centrepompidou.fr/outils/renkan/). Cet outil permet de construire des graphes dans un navigateur et d’y intégrer facilement des ressources issues du Web. Renkan a été développé par l’IRI (Institut de Recherche et d’Innovation du Centre Pompidou), un des partenaires du projet de recherche MétaÉducation qui finance notre travail.

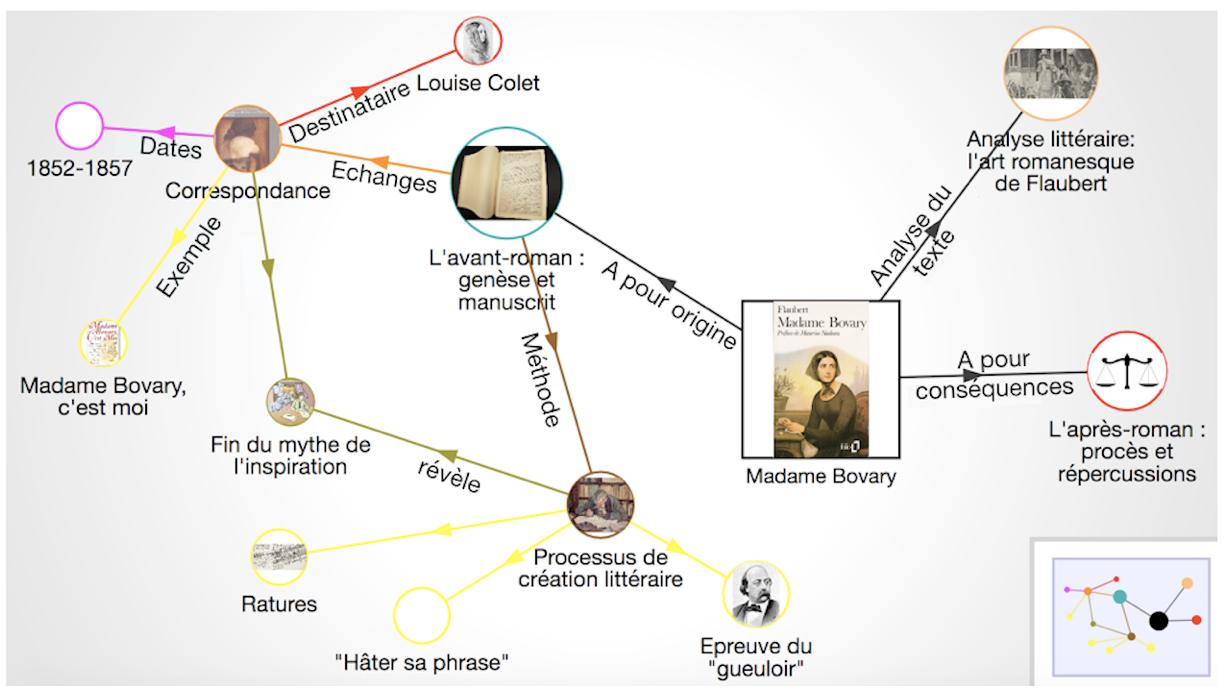

La figure 1 présente un exemple de carte mentale construite avec Renkan sur le sujet « Madame Bovary ». Les images qui apparaissent dans certains nœuds correspondent à des ressources Web associées : par exemple, le nœud carré « Madame Bovary » est associé à une image de la couverture du livre ; le nœud « L’avant-roman : genèse et manuscrit », à gauche, présente l’image d’un livre ouvert ; le nœud « L’après-roman : procès et répercussions », à droite, est illustré par l’image d’une balance. Les liens peuvent être nommés et dirigés pour spécifier la relation entre les nœuds : par exemple, le lien « A pour origine » met en relation les nœuds « Madame Bovary » et « L’avant-roman : genèse et manuscrit ». Renkan permet de créer des cartes mentales sans structure imposée, par exemple une arborescence top-down ou en allant de gauche à droite. Les nœuds et liens peuvent être créés à volonté, figurant des réseaux ou des relations hiérarchiques selon les choix de l’utilisateur.

Figure 1 • Exemple d'une carte mentale construite avec l'outil Renkan sur le sujet « Madame Bovary »

2.1.2. Les outils d’évaluation des cartes mentales

Plusieurs propositions ont été faites afin d’évaluer les cartes mentales produites par les apprenants, parmi lesquelles nous pouvons distinguer des solutions manuelles et des solutions automatisées. Les premières consistent à calculer des indicateurs à partir de l’inspection des cartes mentales finales. Ainsi, McClure et Bell évaluent les cartes mentales à partir d’indicateurs tels que la fréquence et la moyenne de propositions par type, et la fréquence et la moyenne de liens par type présents sur la carte finale (McClure et Bell, 1990). Une proposition est définie par les auteurs comme deux nœuds connectés par un lien, et son type par les domaines associés à ces nœuds (p. ex. « science », « technologie » et « société »). Les types de liens sont : hiérarchique, descriptif et de causalité. D’autres auteurs ont élaboré des systèmes de notation à partir d’indicateurs basés sur la structure (Cañas et al., 2006) et sur des aspects sémantiques de la carte finale (Miller et Cañas, 2008). Parmi les indicateurs de structure nous avons la longueur des intitulés des nœuds et le nombre de niveaux de hiérarchie. Parmi ceux basés sur la sémantique de la carte nous avons la pertinence des concepts et leur complétude, ainsi que la justesse des propositions. L’évaluation de ces indicateurs permet d’assigner une note finale à la carte qui correspond à son niveau de qualité (p. ex. très haut, haut, intermédiaire, bas, très bas, non évalué). Ces propositions d’évaluation sont basées uniquement sur les cartes finales, et les calculs d’indicateurs à la main rendent leur application difficile en conditions réelles lorsque le nombre d’apprenants est important.

Cmapanalysis (Cañas et al., 2013) est un outil informatique qui calcule des indicateurs de structure à partir de fichiers produits avec le logiciel de construction de cartes mentales CmapTools. Cmapanalysis permet d’obtenir des indicateurs tels que le nombre de concepts (i.e. nombre de nœuds), le nombre de liens nommés, le nombre de liens d’un concept, ainsi que de réaliser des comparaisons entre les propositions présentes dans la carte et celles attendues à partir d’une liste de propositions prédéterminée. Les auteurs définissent ici une proposition comme une paire de nœuds connectés par un lien nommé. Cette solution est envisageable pour des classes entières d’apprenants, mais reste limitée à l’analyse des cartes finales.

Ces modes d’évaluation sont basés sur les cartes finales et ont par ailleurs été conçus pour des cartes strictement hiérarchiques.

2.2. L’engagement scolaire et les stratégies d’apprentissage

Les approches conceptuelles existantes fournissent des définitions variées de la notion d’engagement scolaire, tour à tour compris comme effort, intérêt, persistance, motivation ou encore stratégie d’apprentissage (Molinari et al., 2016).

Nous choisissons d’associer notre étude aux travaux des chercheurs qui considèrent l’engagement des apprenants selon trois dimensions complémentaires : motivationnelle, comportementale et cognitive (Fredricks et al., 2004), (Linnenbrick et Pintrich, 2003).

L’engagement motivationnel correspond à l’intérêt, l’affect et la valeur perçue par les étudiants lorsqu’ils réalisent des tâches d’apprentissage (Linnenbrick et Pintrich, 2003). Plusieurs travaux ont montré comment les émotions (positives ou négatives) impactent le processus d’apprentissage (Pekrun et al., 2002), (Zeidner, 2007). Nous ne considérons pas cette dimension de l’engagement dans la suite de notre étude.

L’engagement comportemental fait référence aux comportements observables, aux actions de l’apprenant répondant à une tâche scolaire, et à sa conduite positive, telle que sa participation à des activités collectives extrascolaires (Fredricks et al., 2004). Dans des activités de construction de cartes, accéder à la carte, prendre du temps pour la construire et définir des nœuds et liens représentant des idées et leurs associations sont autant d’actions traduisant un engagement comportemental.

L’engagement cognitif est quant à lui lié à la mise en place de stratégies d’apprentissage. Ces stratégies peuvent être cognitives, d’auto-régulation, ou de gestion de ressources (Pintrich, 1999). Les stratégies cognitives d’élaboration et d’organisation comme la sélection des idées principales, la synthèse, l’organisation spatiale et logique des notes prises, et l’élaboration de cartes mentales ou conceptuelles exigent une réflexion approfondie, favorisant le traitement des contenus pédagogiques chez l’apprenant (Linnenbrick et Pintrich, 2003). Nous pensons que les actions effectuées lors de la composition d’une carte mentale et associées à leur temporalité peuvent être considérées comme des révélateurs de l’engagement cognitif de l’apprenant.

Les travaux sur les outils d’évaluation des cartes mentales (cf. 2.1.2) s’intéressent à l’évaluation des cartes finales sans prendre en compte leur dynamique de construction, et aucun de ces travaux ne se réfère au suivi de l’engagement des créateurs des cartes. Nous pensons que des indicateurs obtenus de façon automatique à partir des processus de construction et mis à disposition via des visualisations, peuvent compléter et enrichir les indicateurs issus des cartes finales, et assister les enseignants dans le suivi et l’évaluation des cartes de leurs élèves. Dans la section suivante, nous présentons différents travaux proposant des tableaux de bord orientés évaluation de l’engagement des apprenants à l’aide d’indicateurs obtenus à partir des traces d’activités pédagogiques.

2.3. Tableaux de bord des activités d’apprentissage pour évaluer l’engagement

De nombreux travaux de recherche proposent des visualisations de l’engagement comportemental des apprenants à partir de leurs traces d’interaction. Le tableau de bord du cours Signals de Purdue (Arnold et Pistilli, 2012) présente par exemple des indicateurs de risque avec des codes couleur obtenus à partir des actions des apprenants et de leurs résultats académiques ; Data Wranglers (Clow, 2014) présente les visites sur des forums, pages, wikis, et tests en cours ; GLASS (Leony et al., 2012) propose des indicateurs de fréquence d’actions par groupe de travail et par type d’activité ; VISEN (Yousuf et Conlan, 2015) présente des indicateurs construits à partir de clics, durées, et des résultats de tests ; enfin le tableau de bord défini par Santos, Govaerts, Verbert et Duval montre le temps passé sur des activités (p. ex. par outil utilisé, par étudiant en comparaison avec la moyenne) (Santos et al., 2012). Ces indicateurs et leurs visualisations restent au niveau des actions décrivant l’engagement comportemental des apprenants, mais ne sont pas suffisants pour permettre de comprendre pourquoi les apprenants se sont engagés ou non dans des activités, et la manière dont ils ont obtenu leurs résultats.

D’autres propositions orientées comportement exploitent des techniques de visualisation afin de favoriser l’exploration des actions des apprenants. SAM (Govaerts et al., 2012) représente les informations avec plusieurs types de visualisation (lignes de temps, coordonnées parallèles) permettant d’y découvrir des détails sur ce que font les apprenants afin d’améliorer l’awareness des enseignants et des mêmes étudiants. Cependant, ces représentations restent des résultats de calculs globaux (p. ex. temps dédié aux activités pendant une période, ressources utilisées) trop limités pour expliquer les actions. Mastery Grids (Loboda et al., 2014) présente une grille avec les thèmes d’étude et les ressources associées. L’accomplissement des activités peut être appréhendé par thème et par sous-thème selon un code couleur et via l’interaction avec la grille. Une ligne de temps indique la semaine actuelle du cours, mais ne permet pas de savoir précisément quand les apprenants ont effectué leurs actions. L’aspect cognitif de l’engagement n’est pas abordé, ni les stratégies utilisées par les apprenants au cours de la réalisation des activités pédagogiques.

D’autres approches appliquent des techniques de fouille de données et des analyses statistiques sur les traces d’interaction des apprenants afin de visualiser des typologies de comportement. Desmarais et Lemieux présentent des visualisations de séquences d’activités en fonction des types de comportement identifiés (Desmarais et Lemieux, 2013). Anderson, Huttenlocher, Kleinberg et Leskovec représentent le pourcentage d’apprenants par profil de comportement dans le temps (p. ex. ceux qui regardent les lectures, ceux qui résolvent les exercices, ceux qui ont la même proportion entre lecture et résolution d’exercices, ceux qui téléchargent les cours, ceux qui ne font que s’enregistrer dans le cours) (Anderson et al., 2014), tandis que Coffrin, Corrin, Barba et Kennedy construisent des séquences d’états représentant les transitions entre les ressources et les contenus pédagogiques (Coffrin et al., 2014). Les utilisateurs de tels systèmes doivent avoir des compétences en analyse et en traitement des données, car les visualisations des résultats ne sont pas générées automatiquement.

En résumé, les tableaux de bord proposent généralement des indicateurs de participation permettant de décrire le comportement des élèves. Ces indicateurs peuvent cependant difficilement expliquer ces comportements, et encore moins l’effort cognitif ou les stratégies d’apprentissage mises en place. De plus, la plupart des travaux qui s’intéressent à estimer l’engagement cognitif utilisent des techniques d’observation et des questionnaires auto-rapportés (Fredricks et al., 2004) et ne proposent pas une mise en relation de ces indicateurs avec ceux de l’engagement comportemental permettant de favoriser la compréhension des actions et des résultats des apprenants.

3. Démarche de conception

Nous avons suivi une démarche de conception itérative, au cours de laquelle les enseignants ont été invités à participer activement à la définition des indicateurs et du tableau de bord. Dans cette section, nous présentons les entretiens semi-dirigés que nous avons conduits à l’aide de maquettes d’interface pour définir les indicateurs et leur représentation.

3.1. Entretiens préliminaires avec les enseignants

3.1.1. Participants et procédure

Nous avons mené une première série d’entretiens auprès de 5 enseignants ayant déjà utilisé des cartes mentales dans leurs pratiques pédagogiques et ayant participé à un premier atelier au cours duquel nous avons présenté l’outil Renkan. Ces enseignants de collèges et lycées étaient spécialisés dans les matières suivantes : histoire et géographie (2 enseignants), sciences et technologies du management et de la gestion (1), arts plastiques (1), et sciences de la vie et de la terre (1). Les établissements des enseignants participaient en tant que terrain d’expérimentation au projet MétaÉducation.

L’objectif des entretiens préliminaires a porté particulièrement sur l’identification des usages des cartes mentales en classe, et sur les attentes en termes de suivi et d’évaluation des apprenants lors des exercices de construction des cartes.

Les enseignants ont répondu à un ensemble de questions sur l’intérêt pédagogique d’utiliser les cartes mentales avec leurs élèves. Pour les aider à se mettre en situation, nous avons soumis à discussion un scénario d’usage de cartes mentales en classe. Nous avons pris des notes et enregistré les réponses des enseignants.

3.1.2. Résultats

Nous avons identifié trois principaux usages de cartes mentales à partir de ces entretiens préliminaires :

- 1) comme bilan pour synthétiser un chapitre étudié en classe ;

- 2) comme exercice avant et après l’étude d’un chapitre en classe afin de réorganiser, compléter et, si besoin, corriger des idées anticipées ;

- 3) comme support pour présenter à l’oral la synthèse d’un chapitre étudié en classe.

Les enseignants ont précisé qu’ils donnaient aux élèves la même consigne et que le même thème était imposé.

Le premier usage des cartes mentales est le plus fréquent. Les élèves peuvent créer la carte au cours d’une séance sur un chapitre étudié en classe, en la reprenant au cours de plusieurs séances si besoin. La carte finale est le rendu du travail de l’élève et elle doit refléter la synthèse du chapitre. Dans le deuxième cas, l’enseignant demande à ses élèves de construire une carte mentale sur un chapitre qui sera étudié plus tard afin de déterminer leurs connaissances a priori sur le sujet, la carte sera enrichie une fois le chapitre terminé. Cet exercice suscite aussi chez les élèves une réflexion sur leurs propres connaissances. Le troisième usage des cartes consiste à les utiliser comme un support pour réaliser des présentations orales sur un sujet spécifique. La présentation orale permet de vérifier la compréhension du sujet par les élèves. Les deux premiers usages nous intéressent plus particulièrement parce qu’ils mettent en œuvre la construction et l’évaluation des cartes mentales. Le troisième cas a été écarté, car c’est la présentation orale qui est l’objet de l’évaluation.

Les enseignants soulignent leur difficulté à comprendre pourquoi certaines cartes construites par les apprenants ne proposent pas de représentations cohérentes du sujet d’étude. Ils ont également remarqué le temps considérable qu’ils prennent pour les interpréter et les évaluer. La difficulté à interpréter les cartes mentales a par exemple été comparée par un enseignant à la difficulté à apprendre une nouvelle langue. Cet enseignant a défini les cartes mentales comme « un mode de communication qui est plus compliqué à comprendre qu’à produire ».

Plusieurs enseignants ont plus particulièrement fait état d’un manque d’indices permettant d’identifier rapidement les élèves qui ont eu des difficultés pendant la construction de la carte. Des comportements pouvant indiquer de telles difficultés ont notamment été proposés, tels que des démarrages tardifs, des nœuds et des liens hors sujet en grande quantité, des hésitations et des tâtonnements (identifiables par la création, la suppression et la recréation de nœuds sans aboutir), ou bien l’absence de relations établies entre les idées (beaucoup de nœuds qui restent isolés).

Nous avons proposé, à partir de ces retours, des maquettes d’indicateurs sur la construction des cartes mentales des élèves en vue d’aider les enseignants dans la phase d’évaluation.

3.2. Maquettes et visualisations d’indicateurs

3.2.1. Participants et procédure

Les cinq enseignants qui ont participé aux entretiens préliminaires ont été invités à donner leurs avis face à des maquettes numériques représentant des indicateurs de suivi sur la construction de cartes mentales. L’objectif de la discussion sur les maquettes était d’identifier la nature des indicateurs pertinents, leurs possibles visualisations, et de faire évoluer les propositions jugées les plus parlantes par les enseignants.

Les enseignants devaient regarder et commenter les maquettes en se projetant sur leurs usages. L’objectif de cette technique a été de connaître les ressentis et les premières pensées au vu des informations proposées sur les maquettes. Les enseignants étaient libres de s’exprimer et de dire à tout moment ce qu’ils ne comprenaient pas ou ce qu’ils trouvaient parlant et utile. Les discussions ont été enregistrées. Les résultats de ces analyses sont présentés dans la section suivante.

3.2.2. Résultats

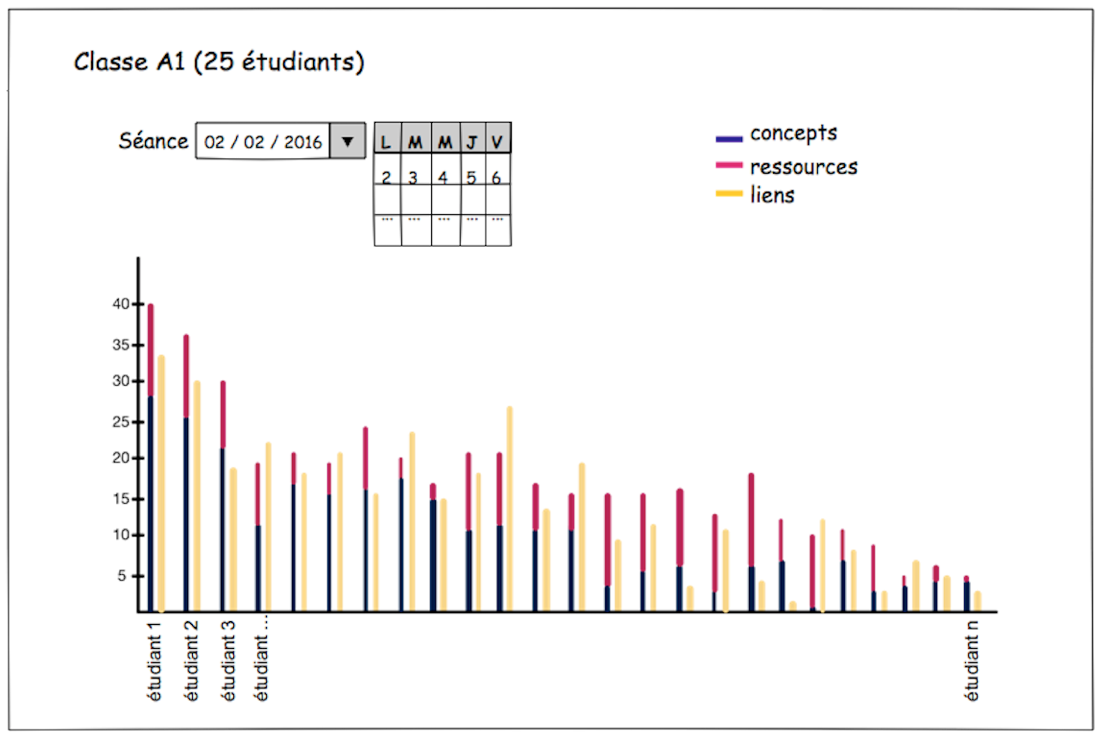

Nous avions considéré différents indicateurs de l’engagement comportemental de l’apprenant : le nombre d’éléments (i.e. nœuds et/ou liens) de la carte finale, le nombre de nœuds avec des médias ou ressources Web associées, et le nombre d’actions (création, suppression, modification, déplacement) réalisées sur les éléments. La figure 2 présente pour chaque élève de la classe, sous la forme de diagrammes en barres empilées, les nombres :

- 1) de nœuds sans ressources Web associées (nommés « concepts » sur l’image),

- 2) de nœuds avec des ressources Web associées (« ressources »),

- 3) de liens sur la carte finale.

Ces barres empilées permettent de mettre en avant la proportion de nœuds sans et de nœuds avec ressources Web associées. Les couleurs identifient ces deux types d’éléments, ainsi que les liens présents dans la carte finale. Les élèves sont présentés par ordre décroissant du nombre total d’éléments (i.e. concepts, ressources et liens) de leur carte finale. Notre intention était d’étudier si ce type de visualisation pourrait aider les enseignants à positionner les élèves les uns par rapport aux autres.

Figure 2 • Maquette d’indicateurs présentant l'ensemble de la classe avec des détails pour chaque élève : nombre de concepts, ressources et liens

Les enseignants se sont montrés intéressés par cette visualisation : « Cela permet de faire un classement par nature des tâches et leur ampleur », « Ça permet de voir le niveau de l’élève ». Certains ont même demandé à avoir des informations contextuelles de la classe sur une autre visualisation qui présentait seulement ses valeurs cumulatives : « Peut-être plus intéressant de voir un élève par rapport aux autres. Ça permettrait de se rendre compte si un élève n’a rien fait ou vraiment beaucoup, cela par rapport à la norme collective ça aura plus de pertinence ».

D’autres indicateurs sur la manipulation de la structure de la carte mentale (i.e. les nœuds et les liens) ont également été proposés en ajoutant des informations sur la temporalité des actions. De tels indicateurs sont en relation avec l’organisation des idées contenues dans la carte et permettent de suivre l’engagement cognitif des apprenants.

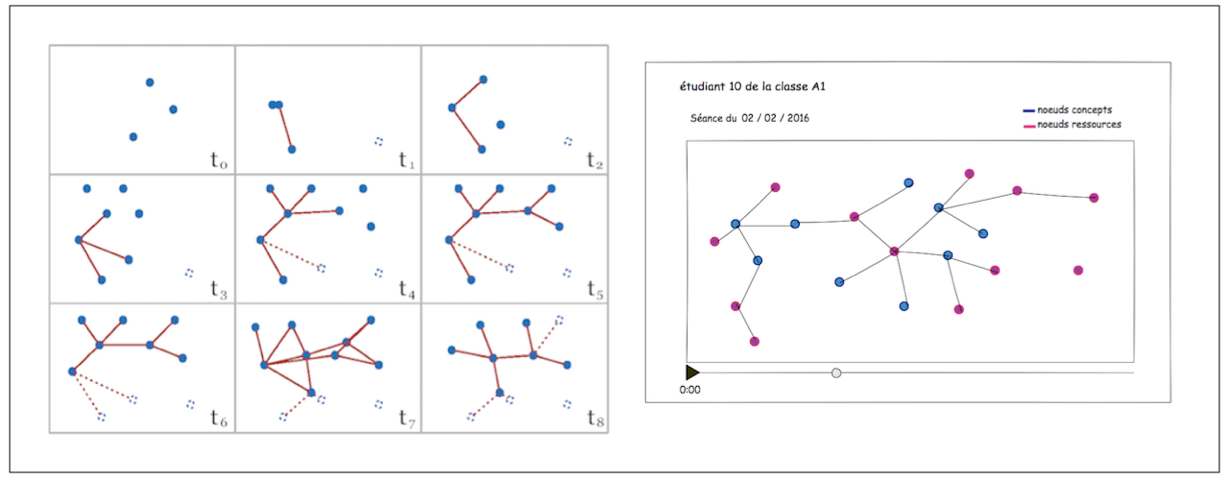

La figure 3 présente deux alternatives de visualisation proposées pour représenter la manipulation dans le temps de la structure d’une carte mentale par un élève (suivi de l’engagement cognitif). La visualisation contenant des Small Multiples (à gauche) offre une vue d’ensemble. Cependant, elle a suscité des questions parmi les enseignants, par rapport au choix des instants (t). Ils ont signalé la difficulté à les choisir et leur impact sur la perte ou la prise en compte d’informations du processus de construction des cartes. La visualisation dynamique pour rejouer la carte (à droite) a été jugée la plus pertinente.

Figure 3 • Deux maquettes proposées pour visualiser l’évolution de la structuration de la carte mentale par l'élève dans le temps

Les premiers entretiens avec les enseignants sur les usages pédagogiques des cartes mentales et leurs avis sur les maquettes d’indicateurs proposés nous ont permis de cibler les informations intéressantes pour leurs tâches de suivi et d’évaluation de l’engagement. Les enseignants ont mentionné la difficulté à évaluer ce type d’activité, étant donné qu’il n’existe pas une solution unique de carte mentale face à un sujet demandé ; plusieurs propositions de cartes produites peuvent être jugées également valides. Ils ont évoqué la notion de « norme collective » comme niveau de repère pour l’identification d’étudiants potentiellement en avance ou en difficulté. La discussion avec les enseignants autour des maquettes a également mis en évidence l’importance de disposer de plusieurs niveaux de représentation pour le suivi par les indicateurs : tout le groupe, avec le détail de chaque élève, et individuel pour un seul élève. Seuls des élèves présentant des caractéristiques particulières, repérées à partir de visualisations au niveau groupe, seraient examinés en détail par les enseignants via d’autres visualisations. D’autre part, le niveau de représentation de la classe a été considéré intéressant mais pas prioritaire.

Une proposition d’indicateurs, à partir des résultats des entretiens, a été mise à disposition sur un prototype de tableau de bord. La définition des indicateurs et l’implémentation du prototype sont décrites dans la section suivante.

4. Résultats – proposition

4.1. Définition d’indicateurs

Nous proposons au final de décrire l’activité d’un élève sur une carte mentale au moyen de cinq indicateurs. Leur définition et des exemples se trouvent dans le tableau 1.

Nous proposons d’enrichir cet ensemble d’indicateurs avec deux représentations des actions pour élaborer la carte mentale associée à leur temporalité. Ces représentations sont : 1) l’évolution, 2) le rejouage de la construction de la carte mentale. L’évolution de la construction de la carte affiche le nombre d’éléments (i.e. nœuds et liens) présents dans la carte depuis sa création, comme une courbe sur un plan à deux dimensions. L’axe horizontal correspond au temps, et l’axe vertical au nombre d’éléments. Cette représentation offre un aperçu rapide des tendances d’activité (p. ex. beaucoup d’éléments au début et puis une forte décroissance). Le rejouage de la construction de la carte prend la forme d’une vidéo des actions (i.e. création, suppression, modification et déplacement) réalisées sur les nœuds et liens de la carte mentale depuis sa création. Les actions sont ainsi présentées en conservant l’ordre chronologique de leur réalisation.

Tableau 1 • Indicateurs proposés pour le suivi et l’évaluation de l’engagement

|

Indicateur |

Description |

Exemple |

|

Nombre d’actions |

Nombre total d’actions réalisées sur les nœuds et liens en prenant en compte les actions de type création, suppression, modification et déplacement. |

9 actions de création, 2 de suppression, et 1 de modification lors de l’élaboration de la carte, font un total de 12 actions correspondant à la valeur de l’indicateur. |

|

Nombre de nœuds |

Nombre total de nœuds de la carte mentale finale. |

Si la carte finale contient 23 nœuds, telle sera la valeur de l’indicateur. |

|

Clarté de la démarche |

Ratio entre le nombre d’actions de suppression et le nombre d’actions de création de nœuds et de liens pendant la construction de la carte mentale. |

Si l’élève réalise 12 actions de suppression sur les éléments de la carte, et 20 actions de création, la valeur de l’indicateur sera de 12/20 = 0.6. |

|

Liens par nœud |

Moyenne des degrés calculés pour chacun des nœuds qui forment la carte mentale finale. Le degré d’un nœud correspond au nombre de liens sortant ou entrant. |

Une carte avec 8 nœuds dont les degrés sont : 1, 1, 3, 3, 2, 2, 2, et 2, aura comme valeur de l’indicateur (1 + 1 + 3 + 3 + 2 + 2 + 2 + 2) / 8 = 2. |

|

Médias ou

|

Nombre et liste des ressources Web intégrées dans la carte mentale finale. Une ressource Web peut être associée à un élément de la carte (nœud ou lien) via son URL. Un élément de la carte peut être associé à une seule ressource Web, et donc à une seule URL. |

La valeur de 4 pour cet indicateur indique qu’il y a 4 éléments de la carte (soient nœuds ou liens) avec une URL associée. En plus du nombre d’URLs associés, la liste de ces URLs cliquables pour aller aux sources Web. |

Les indicateurs proposés dans le tableau 1 nous permettent de comprendre différents aspects de la production d’une carte mentale. Les indicateurs « nombre d’actions », « nombre de nœuds », « clarté de la démarche », le nombre de « médias ou ressources associées » et la représentation de l’évolution de la construction donnent des informations importantes sur le comportement de l’apprenant. Le « nombre de nœuds » permet d’estimer la complexité de la carte mentale et peut fournir des indices d’un comportement plutôt actif ou passif du créateur de la carte. Le nombre de « médias ou ressources associées » (ressources Web intégrées) peut donner des pistes sur l’engagement comportemental, en considérant que l’élève a entrepris des actions de recherche, puis d’association des ressources à des éléments de la carte.

D’autre part, les indicateurs « liens par nœud », la liste de « médias ou ressources associées », et le « rejouage de la carte mentale » mettent en avant des informations sur l’engagement cognitif de l’élève. Parmi ceux-ci, seul l’indicateur « liens par nœud » est un nombre ; il nous donne des indications sur la connectivité de la carte, par exemple si la carte constitue un tout connexe, ou plutôt un ensemble d’éléments isolés. Lorsque la carte est bien connectée, il est possible que ce soit parce que l’élève a fait des efforts pour établir des relations entre ses idées (représentées par les nœuds dans la carte). La possibilité d’accéder aux URLs des ressources Web intégrées via la liste de « médias ou ressources associées » peut permettre de juger la pertinence des ressources et de voir si l’élève était engagé cognitivement. Finalement, le « rejouage de la carte mentale » peut mettre en évidence des comportements récurrents (p. ex. création, puis suppression et recréation) qui donnent des indices sur une démarche par tâtonnement ou au contraire planifiée, ainsi que des possibles stratégies de construction mises en place (p. ex. création de liens au fur et à mesure de la création de nœuds, ou création de la plupart des nœuds puis leurs liens).

Pour aider à l’identification de valeurs d’indicateurs radicalement différentes du reste de la classe, nous les avons regroupées en trois groupes : valeurs proches de la moyenne, valeurs plutôt éloignées de la moyenne, et valeurs très éloignées de la moyenne. Pour chacun des indicateurs proposés nous avons converti les valeurs en z-scores (z) (Kreyszig, 2007) permettant de distinguer leurs écarts par rapport aux valeurs moyennes. Nous avons pu constituer nos trois groupes en séparant les (z) ainsi obtenus par seuils (0<|z |<1, 1<|z |<2 et 2<|z |).

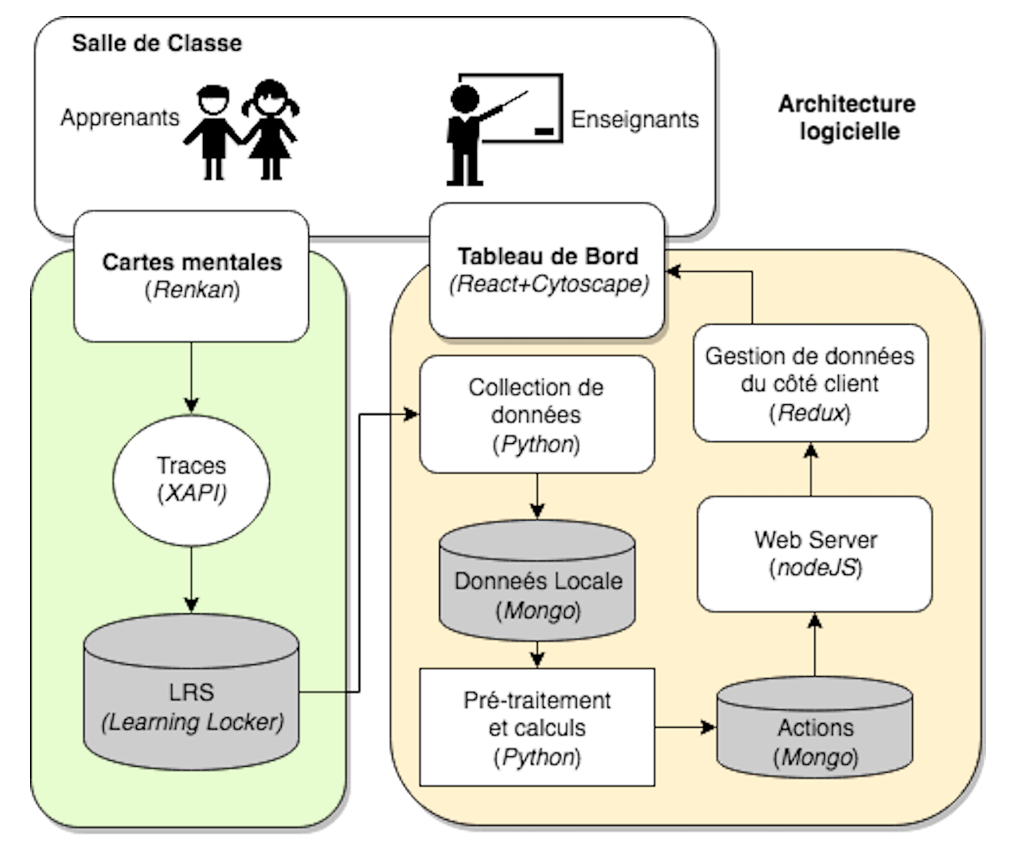

4.2. Architecture logicielle

La figure 4 présente le flux de données depuis la collecte des actions des élèves sur l’outil Renkan jusqu’à l’obtention de la visualisation des indicateurs proposés. Chacune des actions réalisées lors de l’utilisation de Renkan est enregistrée dans une base de stockage de traces, le Learning Record Store (LRS) Learning Locker (https://learninglocker.net/), selon le standard xAPI (https://xapi.com/) aussi nommé TinCan API, accessible ensuite depuis un service web. Les actions des apprenants stockées selon le standard xAPI contiennent les verbes CREATE, UPDATE, DELETE, VIEW, et MOVE. Toutes les données des élèves participants ont été anonymisées.

Figure 4 • Flux de données depuis la collecte de traces jusqu'à la visualisation des indicateurs sur le tableau de bord

L’extraction des traces collectées se fait depuis une autre machine grâce au logiciel xapi-client développé en Python pour ce projet. xapi-client permet d’une part d’obtenir les traces à intervalles réguliers et, d’autre part, d’effectuer un ensemble de prétraitements nécessaires pour la navigation temporelle dans les graphes créés par les élèves :

- extraction des informations depuis le format xAPI,

- reconstruction des états successifs des cartes de graphes depuis leur création,

- identification des différentes actions effectuées,

- stockage des données ainsi pré-traitées.

Une application Web client-serveur permet de produire le système de visualisation du tableau de bord lui-même. Le serveur utilisant NodeJS calcule les indicateurs d’après les données produites par xapi-client, avant de les servir via une API sous la forme de données JSON. Des listes des classes et des élèves par classe sont ainsi rendues disponibles, ainsi que l’ensemble des états des réseaux navigables depuis l’interface. Le standard xAPI nous a permis d’obtenir un format unifié et standardisé de données prêt pour le traitement des traces d’interaction apprenant.

4.3. Visualisation des indicateurs - tableau de bord

Nous avons retenu deux niveaux de représentation pour notre tableau de bord : le premier est à l’échelle de la classe avec les détails de chaque élève, le second montre les données d’un seul élève.

Figure 5 • Interface du tableau de bord (A) : vue de l’ensemble de la classe

Au centre du tableau de bord (cf. figure 5) se trouve une liste des élèves contenant les différents indicateurs en colonnes. Chaque indicateur est présenté dans un cercle contenant au centre sa valeur et en fond une couleur bleue dont l’intensité correspond à son appartenance aux groupes de z-score. Le bleu plus clair montre les éléments proches de la moyenne, et l’intensité augmente en s’éloignant de la moyenne. L’usage de ces couleurs doit permettre aux enseignants d’identifier rapidement les apprenants ayant des comportements très différents des autres. Les filtres permettent de trier les colonnes par ordre croissant ou décroissant.

En cliquant sur l’icône en forme d’œil sur la deuxième colonne du tableau, l’utilisateur peut accéder à un volet contenant les détails de chaque carte (cf. figure 6).

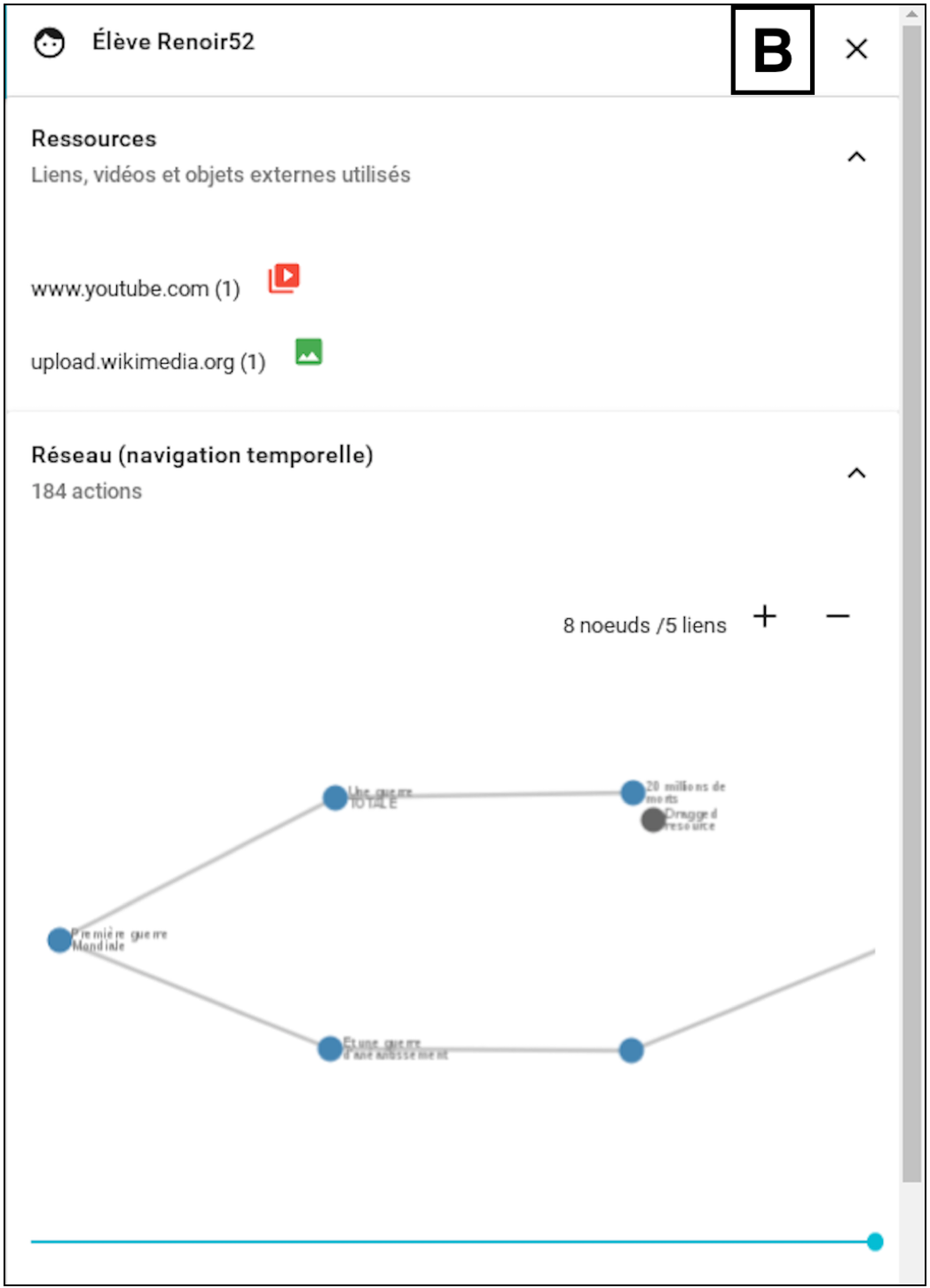

Figure 6 • Interface du tableau de bord (B) : vue d'un élève

La partie supérieure de ce volet contient l’ensemble des ressources Web ajoutées par l’apprenant. On peut accéder directement à chaque ressource en cliquant sur son URL. La partie inférieure permet de rejouer le processus de construction, grâce à une navigation temporelle dans une version simplifiée de la carte en glissant le bouton (slider) sur la ligne temporelle horizontale de rejouage. Les informations telles que les valeurs du nombre de nœuds et du nombre de liens sur la représentation simplifiée de la carte mentale changent en fonction de la position du bouton de navigation temporelle.

5. Évaluation du tableau de bord

Nous avons réalisé une série d’entretiens semi-dirigés avec des enseignants afin d’évaluer le tableau de bord proposé. L’évaluation a été réalisée sur deux aspects : l’utilisabilité de l’interface du tableau de bord et l’utilité des informations mises à disposition sous la forme d’indicateurs. Cette section présente la description de la méthode suivie ainsi que nos premiers résultats.

5.1. Méthode

5.1.1. Participants

Nous avons conduit les entretiens avec trois enseignants, dont deux ayant participé aux entretiens préliminaires (cf. 3.1) et exerçant au niveau lycée. Le troisième enseignant utilise fréquemment des cartes mentales construites sur ordinateur dans ses activités pédagogiques, et exerce au niveau universitaire. Le fait d’inclure ces deux profils d’enseignants dans cette étude d’évaluation permet d’identifier des usages potentiels sur différents terrains.

5.1.2. Matériel

Nous avons construit une grille d’entretien constituée de 21 questions (cf. Annexe) à partir de nos critères d’évaluation : utilisabilité du tableau de bord et utilité des indicateurs. La grille prévoyait des colonnes pour la prise de notes.

Un logiciel de capture vidéo de l’écran et un logiciel d’enregistrement de la voix ont été utilisés pour garder l’intégralité des discussions. Un service de partage d’écran a été également utilisé, permettant de voir les actions réalisées par l’enseignant sur le tableau de bord.

5.1.3. Procédure

Les entretiens ont été réalisés par téléphone, pendant environ une heure. Les logiciels d’enregistrement étaient disponibles depuis le lancement de l’appel.

Nous avons commencé par demander aux enseignants de répondre à un ensemble de questions pour évaluer l’utilisabilité de l’interface, puis nous avons posé des questions concernant l’utilité des informations proposées sous la forme d’indicateurs. Ensuite, nous avons posé des questions générales sur le design de l’interface et, pour finir, nous avons invité les participants à nous transmettre toute remarque ou commentaire sur l’entretien ou l’étude.

Pour l’aspect utilisabilité, les enseignants devaient manipuler et réaliser des tâches simples sur l’interface pour trouver les réponses (p. ex. dire combien d’élèves ont associé plus d’un média dans leur carte, identifier les élèves qui n’ont jamais supprimé de nœuds ou de liens lors de la construction de leur carte, ou bien ceux qui en ont beaucoup supprimés). Ensuite, ils devaient identifier les indicateurs les plus difficiles à comprendre et les raisons des incompréhensions. Pour l’aspect utilité, les enseignants devaient répondre à d’autres questions afin d’identifier les modifications qu’ils jugeaient nécessaires sur chacun des indicateurs pour envisager de s’en servir dans un tableau de bord (p. ex. informations jugées accessoires, informations attendues mais manquantes). Les enseignants ont répondu également à des questions concernant la lisibilité et l’organisation des informations sur l’interface pour nous faire un retour sur le design du tableau de bord. Les questions posées étaient ouvertes et permettaient aux interviewés de s’exprimer à tout moment pour préciser ou enrichir leurs réponses. Pour conclure, les enseignants ont ajouté des commentaires à leur guise sur des points spécifiques, ou sur des aspects généraux tels que l’usage du tableau de bord.

5.2. Résultats

Avec cette première évaluation, nous avons pu confronter notre proposition de tableau de bord et identifier certaines pistes d’amélioration.

5.2.1. Utilisabilité du tableau de bord

Les moyens d’interaction proposés sur le tableau d’indicateurs de la fenêtre principale ont permis d’explorer facilement les informations disponibles (p. ex. ordonner les élèves par identifiant ou par indicateur, voir les cartes mentales simplifiées).

La fenêtre principale du tableau de bord qui présente les indicateurs des élèves dans le contexte de la classe présente majoritairement des données sous la forme de nombres (i.e. « nombre d’actions », « nombre de nœuds », « clarté de la démarche », « liens par nœud », et le nombre de « médias ou ressources associées ») (cf. 4.1). Lors des entretiens d’évaluation, les enseignants ont eu du mal à se faire une idée de la construction de la carte à partir de ces nombres et ont exprimé la difficulté de s’y limiter : « les indicateurs chiffrés dépendent de la carte, c’est très difficile d’utiliser que des indicateurs chiffrés, il faut regarder le réseau qui a été créé ». Nous retenons donc l’importance de combiner les indicateurs quantitatifs avec un autre type de représentation pour faire ressortir des aspects qualitatifs qui sont plus faciles à utiliser par les enseignants.

Les indicateurs qui sont obtenus à partir de comptages se sont avérés intuitifs pour effectuer des comparaisons. Par contre, les indicateurs représentant des ratios ont été plus difficiles à interpréter. L’indicateur « clarté de la démarche » a été jugé ambigu, sa légende suggérant déjà une interprétation : « clarté de la démarche [...] il y a déjà un début d’évaluation en construction, et d’évaluation de comment le contenu est mis en forme. Sauf que l’on ne sait pas, nous, ce qui est pris en compte pour calculer cette clarté de la démarche [...] ». Des suggestions de légende, telles que « Rapport entre nombre de suppressions et de créations » et « Pourcentage de suppressions », ont été proposées par les enseignants. Toutefois cet indicateur n’a finalement pas été jugé très pertinent.

Le choix de couleurs mettant en évidence les groupes formés à partir des z-scores doit être retravaillé car les enseignants ont eu du mal à les identifier et à les interpréter. Parfois les couleurs les plus foncées ont été comprises comme celles du groupe ayant « le mieux réussi », et parfois cette interprétation a été associée aux couleurs les plus claires.

D’autre part, l’intérêt de présenter deux niveaux d’informations (individu et groupe avec le détail de chaque élève) a été confirmé. L’organisation spatiale de l’information dans le tableau de bord n’a pas suscité de remarques importantes. Les enseignants ont néanmoins précisé le besoin de pouvoir accéder à l’état final de la carte depuis le tableau de bord, via une image ou même un lien afin de comparer le processus de construction avec le résultat final obtenu. Ils ont également exprimé le besoin de tutoriels explicatifs concernant à la fois la prise en main du tableau de bord et les calculs des indicateurs.

5.2.2. Utilité des indicateurs

Nous présentons dans cette partie les retours obtenus sur l’utilité des indicateurs du tableau de bord.

Les enseignants ont jugé plus utile de présenter le nombre d’actions sur les nœuds et sur les liens séparément qu’ensemble. Ils ont précisé par exemple, que le travail de création de nœuds et de liens n’a pas le même objectif ni ne demande le même effort cognitif : « ... je pense pas qu’on puisse mélanger les nœuds et les liens en fait. [...] Quand ils [les élèves] commencent ils vont créer un ou deux nœuds avec un titre, après pour eux la difficulté c’est pas de trouver, c’est pas [de] créer le nœud en fait qui est dur, c’est de construire les liens, c’est là où ils ont plus de mal. »

Certains enseignants ont exprimé le besoin de compléter le nombre de nœuds par des informations sur le contenu de nœuds : « Ici il n’y a que de la quantité et l’enseignant s’intéresse qu’à la qualité ». Des informations telles que les noms des nœuds sont demandées, car elles pourraient être utiles pour juger la compréhension des élèves.

Les enseignants ont eu du mal à se servir de l’indicateur de clarté de la démarche, car celui-ci peut prendre en compte des suppressions intentionnelles des élèves qui ne sont pas forcément des indices d’un manque de clarté de la construction. Ils ont même trouvé naturel qu’un élève ajuste sa carte en supprimant et en recréant des éléments pour améliorer sa présentation : « ... ils peuvent supprimer un nœud tout simplement parce qu’ils l’ont pas fait comme ils voulaient et donc ils veulent le refaire pour que la forme corresponde à ce qu’ils veulent. C’est pas sûr que ce soit, comment dire, hyper significatif ». Un exemple d’usage vécu avec des élèves a été donné pour expliquer la non utilité de cet indicateur : « Il y en a plein [des élèves] par exemple qui voyaient pas qu’il y avait un rapport entre [...] le service militaire, l’armée et les droits politiques donc il y en a plein qui ne faisaient pas de flèche (de lien) [...]. Donc c’est plus intéressant de compter dans la production finale le nombre de liens plutôt que de voir le ratio entre ce qui crée et ce qui supprime. Parce que les élèves ils aiment bien que ce soit joli, donc ils vont beaucoup s’attacher à la forme en fait, avec des couleurs, faire des formes originales ».

Certains ont considéré l’indicateur de liens par nœud utile et d’autres ont hésité à l’évaluer à cause de difficultés pour le comprendre. Par exemple, un enseignant a été surpris de voir que deux cartes avec le même nombre de nœuds et le même nombre de liens pouvaient avoir des valeurs différentes pour l’indicateur. L’enseignant pensait que le calcul de l’indicateur « liens par nœud » était un simple ratio (voir le calcul et un exemple sur le tableau 1). Nous pensons qu’il faut retravailler cet indicateur pour le rendre plus intuitif.

L’indicateur représentant les médias ou ressources associées a été jugé utile par les enseignants. La possibilité d’accéder à la source via l’URL a été bien appréciée pour permettre une évaluation du contenu de la carte : « Permettre d’aller vers la source c’est une valeur ajoutée ! ».

L’intention de présenter l’activité de l’élève (i.e. le nombre d’actions sur les éléments de la carte) pendant toute la durée de construction de la carte à la manière d’une évolution a été appréciée. Malheureusement les informations manquantes sur les axes du graphe l’ont rendu inutile. Ce type d’indicateur et sa représentation en fonction de la ligne du temps seront retenus afin de mettre en évidence l’aspect dynamique de la construction de la carte mentale.

Les enseignants ont trouvé majoritairement que le rejouage de la construction de la carte mentale était une représentation utile et intéressante. Cela permet de voir « dans quel ordre les choses se sont construites, car ce n’est pas forcément linaire » et de « rejouer le cheminement ». Un enseignant a même exprimé qu’il serait utile de mettre à disposition des élèves cette visualisation : « pour les élèves, ce serait intéressant de voir comment ils ont fait pour susciter leur réflexion ».

5.2.3. Bilan des retours

En résumé, la plupart des indicateurs ont été considérés utiles pour le suivi de l’engagement des élèves dans la construction de la carte finale. Cependant, plusieurs indicateurs peuvent être améliorés, car ils manquent d’informations importantes (i.e. ajout des intitulés des nœuds dans « nombre de nœuds », ajout des noms des axes dans le graphe « évolution »), ou devraient être présentés différemment (i.e. séparation d’actions sur nœuds et liens dans « nombre d’actions »), ou encore nécessitent d’être plus explicites pour faciliter leur compréhension (i.e. « liens par nœud »). L’indicateur « clarté de la démarche » devrait être supprimé et/ou remplacé car jugé non utile. D’autre part, l’indicateur « médias ou ressources associées » et le « rejouage de la carte mentale » sont à conserver dans une nouvelle version du tableau de bord, car ils ont été jugés utiles. Au-delà de l’aide à l’identification des élèves en difficulté (objectif premier des indicateurs), un enseignant a suggéré que le tableau de bord puisse être utilisé pour l’évaluation des cartes mentales des élèves.

6. Conclusion et perspectives

Nos travaux visent à construire des outils permettant le suivi de l’engagement des apprenants durant la construction de cartes mentales lors d’activités pédagogiques en classe. Nous nous sommes intéressés aux dimensions cognitives et comportementales de l’engagement afin de réaliser un tableau de bord pour les enseignants. L’étape préliminaire de conception du tableau de bord s’est déroulée lors d’ateliers qui nous ont permis de collecter des informations sur l’usage pédagogique des cartes mentales et sur leur évaluation par les enseignants. Nous avons ensuite proposé différentes maquettes de visualisation pour comprendre les problèmes soulevés par la représentation des cartes. Nous avons alors défini différents indicateurs construits à partir des traces collectées lors de l’usage en classe. Nous avons également réalisé une première version du tableau de bord enseignant, lequel présente les indicateurs pour chaque élève, et permet notamment de rejouer la construction de chaque carte étape par étape. Les entretiens d’évaluation auprès des enseignants nous ont permis d’identifier les aspects positifs de la première proposition du tableau de bord, et ceux qui devront être améliorés pour une nouvelle version.

Notre travail en cours est lié à la conception et à la réalisation de la seconde version de notre prototype, qui devrait inclure de nouveaux indicateurs à partir d’une étude plus approfondie des théories sur l’engagement dans les dimensions comportementale et cognitive, et à partir des résultats de la première évaluation de notre prototype. Les nouveaux indicateurs devront être liés à la qualité de la carte mentale à deux niveaux de représentation : une vue générale de la classe, afin de favoriser l’identification d’élèves en difficulté, et une vue individuelle de l’élève fournissant des informations plus détaillées. Il est à noter que les actuelles représentations des indicateurs de la vue générale de la classe devront être enrichies par d’autres plus qualitatives, afin de faciliter le travail des enseignants. Des indicateurs tels que les ressources Web intégrées dans une carte (avec l’accès à leur source) et la représentation de la vidéo qui permet le rejouage de la construction seront repris et améliorés. Le manque de temps des enseignants pour l’analyse des indicateurs est un aspect déterminant pour le suivi des apprenants. La nouvelle version du tableau de bord devra permettre d’identifier en temps réel les élèves en difficulté, ainsi que d’analyser a posteriori plus en détail les processus de construction pour des élèves particuliers. La possibilité de suivre les actions des élèves en temps réel permettrait de réaliser des interventions aux moments pertinents de la construction. Les analyses a posteriori seraient envisagées pour des cas particuliers repérées lors du suivi en temps réel.

Remerciements

Ce travail de recherche est réalisé dans le cadre du projet MétaÉducation qui est financé par le programme « Investissements d’Avenir » du gouvernement français. Nous remercions particulièrement les enseignants et les élèves qui ont participé à nos études de terrain.

À

propos des auteurs

À

propos des auteurs

Rubiela CARRILLO est doctorante en Informatique à l’Université Claude Bernard Lyon 1 depuis 2015 et membre du laboratoire LIRIS, équipe SICAL. Ses recherches portent sur les Environnements informatiques pour l’apprentissage humain (EIAH) et les Interactions homme-machine (IHM). Elle a obtenu le diplôme de master en Informatique, spécialité « Interfaces homme-machine », à Polytech Nice en 2011 et le diplôme de master en Sciences humaines et sociales, spécialité « Ergonomie cognitive et sociologie des usages des technologies de l’information et de la communication », à l’Université de Nice – Sophia Antipolis en 2012.

Adresse : INSA de Lyon, Bâtiment Blaise Pascal, 7 avenue Jean Capelle, 69621 Villeurbanne Cedex, France

Courriel : rubiela.carrillo-rozo@liris.cnrs.fr

Toile : http://rubielacarrillo.info

Yannick PRIÉ est Professeur en Informatique à Polytech Nantes, Université de Nantes, depuis 2012. Il est membre du laboratoire LS2N, équipe DUKe. Ses travaux de recherche portent sur les interactions homme-machine, la visualisation d’information, les outils d’interprétation et d'analyse de données et de documents, appliqués à des domaines d'application variés, tels que le travail intellectuel, les EIAH. L’interdisciplinarité est privilégiée dans tous ses projets de recherche.

Adresse : Université de Nantes, Polytech Nantes, Rue Christian Pauc, BP50609, 44306 Nantes cedex 3, France

Courriel : yannick.prie@univ-nantes.fr

Toile : http://yannickprie.net/

Leslie GUILLAUME est diplômée en sciences cognitives. Son expertise porte sur l'expérience utilisateur autour du développement de nouveaux outils, principalement en lien avec l'éducation. Après une expérience dans une startup spécialisée en robotique, elle a rejoint différentes équipes dans des laboratoires de recherche telle que EducTice à l'Institut Français de l'Education de l'ENS de Lyon, sur un projet de conception et d'études de situations d'apprentissage mettant en jeu des objets matériels et virtuels connectés au sein d'un dispositif de réalité mixte. Elle a rejoint en 2017 l'équipe SICAL du LIRIS sur le projet MétaÉducation.

Adresse : Institut Français de l'Education, École Normale Supérieure de Lyon, 19 allée de Fontenay BP 17424, 69347 Lyon Cedex 07, France

Courriel : leslie.guillaume@ens-lyon.fr

Élise LAVOUÉ est Maître de Conférences HDR en Informatique à l’IAE Lyon, Université Jean Moulin Lyon 3, depuis 2009 et membre du laboratoire LIRIS, équipe SICAL. Ses travaux de recherche concernent la conception d’environnements informatiques pour l’apprentissage humain (EIAH) réflexifs et engageants comme support à l’auto-régulation des apprenants, notamment par la conception de tableaux de bord. Elle est auteure ou co-auteure de plus de 70 publications dans les domaines des EIAH, Learning Analytics et IHM. Elle a obtenu son HDR en novembre 2016 après avoir été Professeure Invitée à l’Université McGill pendant 8 mois. Elle a été responsable de l’organisation de la conférence européenne ECTEL 2016 et co-présidente du comité de programme en 2017.

Adresse : Université Jean Moulin Lyon 3, IAE Lyon, 6, cours Albert Thomas BP 8242, 69355 Lyon Cedex 08, France

Courriel : elise.lavoue@univ-lyon3.fr

Toile : http://liris.cnrs.fr/elise.lavoue/

REFERENCES

Anderson, A., Huttenlocher, D., Kleinberg, J. et Leskovec, J. (2014). Engaging with Massive Online Courses. Dans Proceedings of the 23rd International Conference on World Wide Web (p. 687–698). New York, NY : ACM. Disponible sur Internet.

Arnold, K. E. et Pistilli, M. D. (2012). Course signals at Purdue: Using learning analytics to increase student success. Dans Proceedings of the 2nd International Conference on Learning Analytics And Knowledge (p. 267–270). New York, NY : ACM. Disponible sur Internet

Buzan, B., Buzan, T. et Bouvier, M. (2012). Mind map, dessine-moi l’intelligence. Paris, France : Eyrolles.

Cañas, A. J., Novak, J. D., Miller, N. L., Collado, C., Rodríguez, M., Concepción, M., ... Peña, L. (2006). Confiabilidad de una taxonomía topológica para mapas conceptuales. Dans Proceedings of the 2nd International Conference on Concept Mapping. Disponible sur Internet

Cañas, A. J., Bunch, L., Novak, J. D. et Reiska, P. (2013). Cmapanalysis: an extensible concept map analysis tool. Journal for Educators, Teachers and Trainers, 4(1), 36-46. Disponible sur Internet

Clow, D. (2014). Data wranglers: Human interpreters to help close the feedback loop. Dans Proceedings of the Fourth International Conference on Learning Analytics And Knowledge (p. 49–53). New York, NY : ACM. Disponible sur Internet

Coffrin, C., Corrin, L., de Barba, P. et Kennedy, G. (2014). Visualizing patterns of student engagement and performance in MOOCs. Dans Proceedings of the Fourth International Conference on Learning Analytics And Knowledge (LAK’14) (p. 83–92). New York, NY : ACM. Disponible sur Internet

Davies, M. (2011). Concept mapping, mind mapping and argument mapping: what are the differences and do they matter? Higher Education, 62(3), 279-301. Disponible sur Internet

Desmarais, M. C. et Lemieux, F. (2013). Clustering and visualizing study state sequences. Dans Proceedings of the 6th Conference on Educational Data Mining (EDM 2013) (p. 224-227).

Eppler, M. J. (2006). A comparison between concept maps, mind maps, conceptual diagrams, and visual metaphors as complementary tools for knowledge construction and sharing. Information Visualization, 5(3), 202-210. Disponible sur Internet

Fredricks, J. A., Blumenfeld, P. C. et Paris, A. H. (2004). School engagement: Potential of the concept, state of the evidence. Review of Educational Research, 74(1), 59-109. Disponible sur Internet

Govaerts, S., Verbert, K., Duval, E. et Pardo, A. (2012). The student activity meter for awareness and self-reflection. Dans CHI ’12 Extended Abstracts on Human Factors in Computing Systems (p. 869–884). New York, NY : ACM. Disponible sur Internet

Kreyszig, E. (2007). Advanced engineering mathematics. John Wiley & Sons.

Leony, D., Pardo, A., de la Fuente Valentín, L., de Castro, D. S. et Kloos, C. D. (2012). GLASS: A learning analytics visualization tool. Dans Proceedings of the 2nd International Conference on Learning Analytics and Knowledge (p. 162–163). New York, NY : ACM. Disponible sur Internet

Linnenbrink, E. A. et Pintrich, P. R. (2003). The role of self-efficacy beliefs instudent engagement and learning intheclassroom. Reading & Writing Quarterly, 19(2), 119-137. Disponible sur Internet

Loboda, T. D., Guerra, J., Hosseini, R. et Brusilovsky, P. (2014). Mastery grids: An open-source social educational progress visualization. Dans Proceedings of the 2014 Conference on Innovation & Technology in Computer Science Education (p. 357–357). New York, NY : ACM. Disponible sur Internet

McClure, J. R. et Bell, P. E. (1990). Effects of an Environmental Education-Related STS Approach Instruction on Cognitive Structures of Preservice Science Teachers (rapport, Pennsylvania State University). Disponible sur Internet

Miller, N. L. et Cañas, A. J. (2008). A semantic scoring rubric for concept maps: design and reliability. Dans Proceedings of the Third International Conference on Concept Mapping, Tallinn, Estonia & Helsinki, Finland. Disponible sur Internet

Molinari, G., Poellhuber, B., Heutte, J., Lavoué, E., Widmer, D. S. et Caron, P.-A. (2016). L’engagement et la persistance dans les dispositifs de formation en ligne : regards croisés. Distances et médiations des savoirs, 13. Disponible sur Internet

Novak, J. D. et Cañas, A. J. (2007). Theoretical origins of concept maps, how to construct them, and uses in education. Reflecting Education, 3(1), 29-42. Disponible sur Internet

Pekrun, R., Goetz, T., Titz, W. et Perry, R. P. (2002). Academic emotions in students’ self-regulated learning and achievement: A program of qualitative and quantitative research. Educational Psychologist, 37(2), 91-105. Disponible sur Internet

Pintrich, P. R. (1999). The role of motivation in promoting and sustaining self-regulated learning. International Journal of Educational Research, 31(6), 459-470. Disponible sur Internet

Santos, J. L., Govaerts, S., Verbert, K. et Duval, E. (2012). Goal-oriented visualizations of activity tracking: A case study with engineering students. Dans Proceedings of the 2nd International Conference on Learning Analytics And Knowledge (p. 143–152). New York, NY : ACM. Disponible sur Internet

Yousuf, B. et Conlan, O. (2015). VisEN: Motivating learner engagement through explorable visual narratives. Dans G. Conole, T. Klobučar, C. Rensing, J. Konert et E. Lavoué (dir.), Design for Teaching and Learning in a Networked World (LCNS, vol. 9307, p. 367-380). Cham, Suisse : Springer International Publishing. Disponible sur Internet

Zeidner, M. (2007). Chapter 10 - Test anxiety in educational contexts: Concepts, findings, and future directions. Dans P. A. Schutz et R. Pekrun (dir.), Emotion in Education (p. 165-184). Burlington, MA : Academic Press. Disponible sur Internet

ANNEXE

Grille d'entretien pour évaluer l'utilisabilité et l'utilité du prototype de tableau de bord

|

Utilisabilité de l’interface du tableau de bord proposé |

||

|

1 |

Quelle version du tableau de bord êtes-vous en train d’utiliser ? (Rta : 0.07) |

|

|

2 |

Après ordonner les élèves par identifiant, Pourriez-vous dire le nombre d’actions réalisées par le 3ème élève de la liste ? (Rta : 93) |

|

|

3 |

Les indicateurs sont affichés sur des cercles à 3 couleurs

représentant 3 groupes. Les groupes ont été définis

à partir de la proximité des valeurs des indicateurs par rapport

à la norme collective.

|

|

|

4 |

Combien d’élèves n’ont jamais supprimé un élément (nœud ou lien) de la carte mentale qu’ils ont construite ? (Rta : 8 élèves : ceux qui n’ont pas de valeurs de l’indicateur “Clarté de la démarche” car le numérateur du ratio est toujours “zéro”) |

|

|

5 |

Combien d’élèves ont associé seulement deux ressources externes dans la carte mentale ? (Rta : seulement 1 élève - Élève Renoir52) |

|

|

6 |

Combien d’élèves ont construit une carte dont la moyenne de liaisons de ses nœuds a été de 2 liens ? (Rta : 1 élève : Élève Renoir53) |

|

|

7 |

Seriez-vous en capacité de décrire à quoi correspond chacun des indicateurs après regarder le tableau de bord ? |

|

|

8 |

Quels sont les indicateurs les plus difficiles à comprendre ? Pourquoi ? |

|

|

9 |

Quelles modifications feriez-vous au niveau des légendes sur l’interface ? |

|

|

10 |

Quelles informations regarderiez-vous principalement pour faire de comparaisons entre vos élèves ? Quoi voudriez-vous comparer ? |

|

|

Explorant l’interface, pourriez-vous me dire sur l’élève « Élève Renoir19 » : |

||

|

11 |

La durée pour construire sa carte mentale ? (Rta : début : 13:24, fin : 13:52) |

|

|

12 |

Combien de nœuds et combien de liens sont présents dans la carte finale ? (Rta : 6 nœuds et 4 liens) |

|

|

13 |

Combien de nœuds n’ont pas été liés au graphe de la carte par aucun lien ? (Rta : 1 seul nœud) |

|

|

Explorant la carte de l’élève « Elève Renoir40 », pourriez-vous me dire : |

||

|

14 |

Le nombre d’actions qu’il a réalisées pour construire sa carte ? (Rta : 142 actions) |

|

|

15 |

Les sites Web qu’il a consultés pour construire sa carte ? (Rta : upload.wikimedia.org, i.huffpost.com, www.francetvinfo.fr, et img.over-blog.com) |

|

|

|

||

|

16 |

Trouvez-vous utiles les indicateurs proposés dans le tableau de bord ? Quels indicateurs changeriez-vous ? pourquoi ? |

|

|

17 |

Quelles informations attendiez-vous voir sur le tableau de bord et vous ont manqué ? |

|

|

Questions générales et débriefing |

||

|

De façon générale comment trouvez-vous l’interface du tableau de bord ? |

||

|

18 |

en termes de lisibilité des informations affichées ? |

|

|

19 |

en termes de l’organisation des informations présentées ? |

|

|

20 |

en termes de la compréhension des indicateurs présentés ? |

|

|

21 |

Voulez-vous ajouter d’autres commentaires par rapport à l’interface ou à l’entretien qu’on vient de réaliser ? |

|

Rubiela CARRILLO, Yannick PRIÉ, Leslie GUILLAUME, Élise LAVOUÉ , Suivre l’engagement des apprenants dans l’activité de construction de cartes mentales, Revue STICEF, Volume 25, numéro 1, 2018, DOI:10.23709/sticef.25.1.5, ISSN : 1764-7223, mis en ligne le 22/11/2018, http://sticef.org

© Revue Sciences et Technologies de l´Information et de la Communication pour l´Éducation et la Formation