Sciences et Technologies

Sciences et Technologies de l´Information et

de la Communication pour

l´Éducation et la Formation

Volume 21, 2014

Article de recherche

Rendre compte au tuteur des effets de ses interventions à l’aide de méta-indicateurs

Aina LEKIRA, Christophe DESPRÉS, Pierre JACOBONI, Dominique PY (LIUM – Le Mans)

![]() RÉSUMÉ : Dans

cet article, nous étudions la question du soutien à apporter au

tuteur en situation de tutorat médiatisé. Notre objectif est de

fournir au tuteur des informations sur les effets de ses interventions

auprès des apprenants. Pour cela, nous proposons une approche

fondée sur les indicateurs, en introduisant la notion de

méta-indicateur. La particularité des méta-indicateurs est

de suivre l’évolution des valeurs des indicateurs. Afin

d’évaluer notre proposition, nous avons cherché à

mesurer l’impact des informations fournies au tuteur par les

méta-indicateurs, à la fois, sur l’activité du tuteur

et sur celle de l’apprenant. Nous avons, ainsi, réalisé des

expérimentations en contexte écologique dans le domaine de

l’apprentissage de la programmation orientée objet. Les

résultats tendent à montrer une amélioration des effets des

interventions du tuteur et un impact bénéfique sur

l’activité des apprenants.

RÉSUMÉ : Dans

cet article, nous étudions la question du soutien à apporter au

tuteur en situation de tutorat médiatisé. Notre objectif est de

fournir au tuteur des informations sur les effets de ses interventions

auprès des apprenants. Pour cela, nous proposons une approche

fondée sur les indicateurs, en introduisant la notion de

méta-indicateur. La particularité des méta-indicateurs est

de suivre l’évolution des valeurs des indicateurs. Afin

d’évaluer notre proposition, nous avons cherché à

mesurer l’impact des informations fournies au tuteur par les

méta-indicateurs, à la fois, sur l’activité du tuteur

et sur celle de l’apprenant. Nous avons, ainsi, réalisé des

expérimentations en contexte écologique dans le domaine de

l’apprentissage de la programmation orientée objet. Les

résultats tendent à montrer une amélioration des effets des

interventions du tuteur et un impact bénéfique sur

l’activité des apprenants.

![]() MOTS CLÉS : tutorat,

effet des interventions, indicateurs.

MOTS CLÉS : tutorat,

effet des interventions, indicateurs.

![]() ABSTRACT : In

this paper, we study how to support a human tutor who regulates the

learner’s activity, in the framework of mediated tutoring. Our goal is to

provide the tutor with informations about the effect of his/her interventions.

To achieve this, we propose an indicator-based approach and introduce the notion

of meta-indicator. The distinguishing feature of meta-indicators is that they

follow the evolution of indicators’ values. In order to evaluate our

proposal, we have tried to measure the impact of the information provided by

meta-indicators, both on tutor activity and learner activity. We have conducted

experiments, in ecological context, in the domain of object-oriented

programming. The results suggest an improvement of the effects of tutoring

interventions and a positive impact on learners’ activity.

ABSTRACT : In

this paper, we study how to support a human tutor who regulates the

learner’s activity, in the framework of mediated tutoring. Our goal is to

provide the tutor with informations about the effect of his/her interventions.

To achieve this, we propose an indicator-based approach and introduce the notion

of meta-indicator. The distinguishing feature of meta-indicators is that they

follow the evolution of indicators’ values. In order to evaluate our

proposal, we have tried to measure the impact of the information provided by

meta-indicators, both on tutor activity and learner activity. We have conducted

experiments, in ecological context, in the domain of object-oriented

programming. The results suggest an improvement of the effects of tutoring

interventions and a positive impact on learners’ activity.

![]() KEYWORDS : tutoring,

effects of interventions, indicators

KEYWORDS : tutoring,

effects of interventions, indicators

1. Introduction

En situation d’apprentissage, le tuteur est celui qui suit, assiste et conseille l’apprenant. Il joue un rôle fondamental puisqu’il veille au bon déroulement du processus d’apprentissage à travers la régulation de l’activité de l’apprenant.

Nous nous intéressons aux situations dans lesquelles l’activité de tutorat est partiellement ou totalement instrumentée et où le tuteur accompagne un groupe d’apprenants dans la réalisation de leurs activités au travers d’un dispositif informatique. Dans ces situations, le tuteur a besoin de percevoir l’activité de l’apprenant afin d’adapter au mieux ses actions tutorales. Les travaux de recherche qui se sont intéressés à ce problème ont abouti à la réalisation d’outils permettant de visualiser un certain nombre d’indicateurs, témoins de l’activité de l’apprenant. Ces indicateurs donnent des informations relatives à l’apprenant telles que sa progression ou son état d’avancement (Guéraud et al., 2009) ; (France et al., 2007), son profil (Lefèvre, 2009), ses performances (Mazza et Dimitrova, 2007), son parcours (Després, 2001), sa production (Delorme et Loosli, 2006) ou son style d’apprentissage (Bousbia et al., 2009). L’intérêt des indicateurs réside dans le fait qu’ils fournissent des informations pédagogiquement pertinentes. Ils réduisent ainsi le temps que le tuteur passe à visualiser le travail accompli par chaque apprenant (Labat, 2002).

Certains systèmes donnent au tuteur la possibilité, après avoir observé l’activité de l’apprenant, d’intervenir en entrant en communication avec lui (Després, 2001). Ces interventions tutorales sont de nature différente et les auteurs abondent en catégorisation à ce sujet puisqu’elles peuvent être relatives à des questions d’évaluation, d’organisation, de gestion etc. Elles dépendent des rôles et des fonctions du tuteur et du dispositif de formation mis en place (Glikman, 2011). Les travaux qui abordent ce thème présentent différentes classifications des interventions tutorales en fonction de l’accompagnement que le tuteur réalise auprès de l’apprenant (Lebel, 1993) (Garrot, 2008) ; (Quintin, 2008) ; (Denis, 2003) ; (Guillaume, 2009) ; (Glikman, 2011). Une intervention du tuteur peut viser à attirer l’attention de l’apprenant sur un point précis, à corriger une erreur survenue dans l’activité de l’apprenant ou encore à expliquer une notion à l’apprenant.

Cependant, la plupart des environnements de tutorat médiatisé ne donnent au tuteur aucune information concernant les répercussions de son intervention. Le tuteur doit, lorsque le système le permet, aller chercher lui-même cette information ou la déduire en examinant l’historique de l’activité de l’apprenant ou ses productions. Cette charge supplémentaire devient trop importante lorsqu’il encadre plusieurs apprenants.

Notre objectif est de pallier ce manque d’information en fournissant au tuteur un retour sur les effets de ses interventions afin qu’il puisse évaluer ses stratégies de remédiation (Denis, 2003) et les ajuster (Zimmermann, 2000) ; (Capa-Aydin et al., 2009) si besoin en intervenant de nouveau.

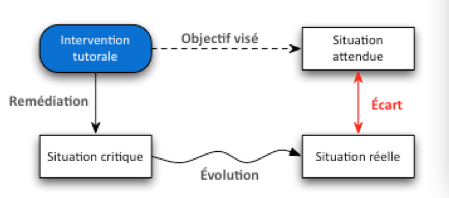

L’atteinte de notre objectif nécessite une mesure des effets des interventions du tuteur. Dans le cadre de notre travail, nous nous limitions aux situations où le tuteur intervient avec une intention de remédiation sur une situation qui ne correspond pas aux attendus pédagogiques. Cela traduit généralement l’existence d’un problème ou d’une difficulté dans la réalisation de l’activité de l’apprenant.

De notre point de vue, mesurer les effets d’une intervention tutorale consiste donc à comparer ce qui s’est réellement passé à ce qui est souhaité par le tuteur. Pour effectuer cette mesure, il est nécessaire d’identifier d’une part, l’effet escompté de l’intervention et d’autre part, les conséquences réellement observées. Il convient donc de répondre aux deux questions de recherche suivantes : comment identifier la situation attendue par le tuteur ? Comment identifier les conséquences de son intervention ?

Pour répondre à ces questions, nous proposons d’exploiter les indicateurs issus de l’analyse de la trace d’activité de l’apprenant et d’observer leur évolution dans le temps.

Après une présentation de la notion d’indicateur en section 2, nous détaillons notre proposition, basée sur le concept de méta-indicateur, en section 3. La section 4 est consacrée à une mise en œuvre de ces méta-indicateurs dans le domaine de la programmation objet. Enfin, nous décrivons les expérimentations conduites en milieu écologique et analysons leurs résultats en section 5.

2. Les indicateurs

Le réseau d’excellence européen Kaléidoscope a effectué un travail fédérateur dans le domaine des indicateurs, notamment via les projets ICALTS (Interaction and Collaboration Analysis supporting Teachers and Students Self-regulation) (Dimitracopoulou et al., 2004) ; (Harrer et al., 2004) (Jermann et Dimitracopoulou, 2004), IA (Dimitracopoulou et al., 2005) et DPULS (DPULS, 2005). Nous nous appuyons sur les résultats issus de ces travaux.

Un indicateur est défini comme « un observable signifiant sur le plan pédagogique, calculé ou établi à l’aide d’observés, et témoignant de la qualité de l’interaction, de l’activité et de l’apprentissage dans un EIAH » (Choquet et Iksal, 2007). Un indicateur possède plusieurs attributs tels que son nom, sa valeur, sa forme (numérique, littérale ou graphique), le concept qui caractérise l’aspect de l’interaction que représente l’indicateur, l’objectif visé par l’indicateur, le moment de l’utilisation de l’indicateur, les utilisateurs finaux de l’indicateur, etc. (Dimitracopoulou et al., 2004) ; (Dimitracopoulou et al., 2005).

Les travaux issus des projets ICALTS et IA (Dimitracopoulou et al., 2004) ; (Dimitracopoulou et al., 2005) introduisent également la notion d’indicateur calibré. Un indicateur est qualifié de « calibré » lorsque, parmi les valeurs qu’il peut prendre, certaines sont jugées conformes aux attendus pédagogiques et d’autres non. Ces indicateurs possèdent donc un « domaine de validité » défini comme l’ensemble des valeurs conformes.

La figure 1 donne un exemple d’un indicateur calibré appelé « équilibre entre la conversation et l’action » qui mesure, dans le cadre d’une activité collaborative, le rapport entre le temps passé par deux apprenants à communiquer entre eux et le temps passé à effectuer des actions pour réaliser l’activité. Cet indicateur est répertorié dans (Dimitracopoulou et al., 2004).

Figure 1 • Indicateur « Conversation and Action

Balance »

Pour répondre aux questions de recherche énoncées dans la section précédente, nous nous appuyons sur cette notion d’indicateur calibré. Nous nous intéressons aux interventions du tuteur en réaction à des situations où les attendus pédagogiques ne sont pas atteints. Ces situations sont caractérisées par le fait qu’au moins un indicateur prend une valeur qui n’appartient pas à son domaine de validité.

3. Rendre compte des effets des interventions du tuteur à l’aide de méta-indicateurs

Nous nous plaçons dans le cadre d’un environnement de tutorat médiatisé avec des indicateurs calibrés et considérons les situations où le tuteur intervient parce que les attendus pédagogiques ne sont pas atteints. Ces interventions consistent en un échange entre le tuteur et l’apprenant par des moyens de communication textuels ou audio. Au cours de cet échange, le tuteur peut par exemple rappeler des notions de cours, signaler une erreur ou un oubli, etc.

Notre objectif consiste à mesurer automatiquement les effets de l’intervention tutorale. Cela consiste à estimer l’écart entre la situation attendue et la situation réelle (cf. Figure 2). Pour estimer l’écart, il nous faut donc déterminer la situation attendue et la situation réelle. Il nous faut également identifier ce qui a poussé le tuteur à intervenir, puisque identifier la situation attendue implique de savoir la raison pour laquelle le tuteur est intervenu. Pour cela, nous nous appuyons sur les indicateurs calibrés et nous définissons une « situation critique » comme une situation dans laquelle au moins l’un des indicateurs prend une valeur qui n’appartient pas à son domaine de validité. La situation attendue est celle où les indicateurs à l’origine de l’intervention ont retrouvé une valeur conforme et retournent dans leurs domaines de validité. L’écart peut être mesuré en calculant la différence entre les valeurs d’indicateurs attendues et les valeurs réellement observées.

Figure 2 • Situations caractéristiques

3.1. Indicateurs et domaine de validité

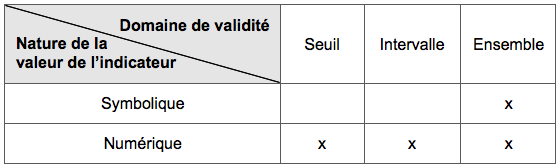

Nous considérons des indicateurs calibrés dont les valeurs peuvent aussi bien être numériques que symboliques. La plupart des travaux de recherche, notamment ceux du réseau Kaléidoscope, portent sur des indicateurs dont le domaine de validité est un ensemble de valeurs. Cependant, lorsqu’un indicateur prend des valeurs numériques, il peut aussi être utile de représenter son domaine de validité comme l’ensemble des valeurs supérieures ou inférieures à une valeur donnée (un seuil) ou bien comme l’ensemble des valeurs comprises entre deux bornes (un intervalle). Le tableau 1 récapitule les types de domaines de validité possibles selon la nature de la valeur de l’indicateur.

Tableau 1 • Domaines de validité possibles pour un indicateur en fonction de la nature de sa valeur

Le tableau 2 présente des exemples d’indicateurs correspondant à chaque type de domaine de validité, avec leurs valeurs de validité.

Tableau 2 • Exemples d’indicateurs de chaque type de domaine de validité

3.2. Méta-indicateurs

Afin de mesurer l’effet d’une intervention, nous devons suivre l’évolution de la valeur des indicateurs pédagogiques à l’origine de cette intervention. Nous proposons pour cela de créer des indicateurs dont le but est de rendre compte de cette évolution. Pour cela, nous introduisons la notion de méta-indicateur, que nous définissons comme un indicateur portant sur des indicateurs pédagogiques. Un méta-indicateur prend des valeurs symboliques qui indiquent le succès, l’échec ou l’effet mitigé d’une intervention tutorale, selon que les indicateurs qui l’ont motivée ont évolué positivement ou non depuis l’intervention.

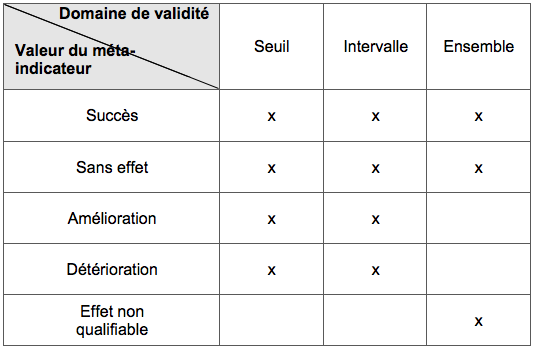

Lorsqu’une intervention tutorale est motivée par un seul indicateur, trois cas sont possibles :

- si l’indicateur a pris une nouvelle valeur appartenant à son domaine de validité, le méta-indicateur vaut Succès

- si la valeur de l’indicateur est restée identique depuis l’intervention, le méta-indicateur vaut Sans effet ;

- enfin, si la valeur de l’indicateur a évolué depuis l’intervention, mais que la nouvelle valeur n’appartient pas au domaine de validité, la valeur du méta-indicateur dépend du type de domaine de validité de l’indicateur. Si ce domaine est de type seuil ou intervalle, il est possible de distinguer deux cas selon que la nouvelle valeur de l’indicateur est plus proche (Amélioration) ou plus éloignée (Détérioration) du domaine de validité que l’ancienne valeur. Si ce domaine est de type valeur ou ensemble, il n’est pas possible de qualifier l’évolution et le méta-indicateur vaut simplement Effet non qualifiable.

Le tableau 3 récapitule les valeurs que peut prendre un méta-indicateur en fonction du type du domaine de validité de l’indicateur dont il suit l’évolution.

Tableau 3 • Valeurs possibles pour un méta-indicateur en fonction de son domaine de validité

3.3. Calcul des méta-indicateurs

Cette section détaille la manière dont est calculé un méta-indicateur en fonction du type de domaine de validité de l’indicateur qui a entraîné l’intervention.

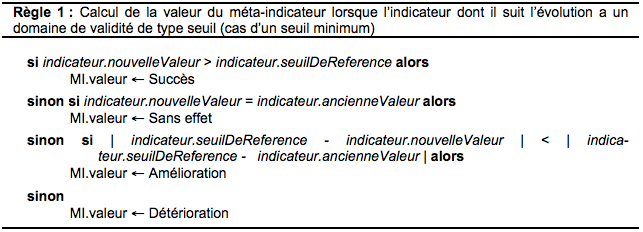

3.3.1. Indicateurs avec un domaine de validité de type seuil

Lorsque le domaine de validité de l’indicateur est exprimé par un seuil, il faut déterminer si la nouvelle valeur de l’indicateur est au delà (respectivement en deçà) du seuil.

Le calcul du méta-indicateur se fait comme décrit dans la règle 1, pour un seuil représentant un minimum.

3.3.2. Indicateurs avec un domaine de validité de type intervalle

Lorsque le domaine de validité de l’indicateur est exprimé par un intervalle, il faut déterminer si la nouvelle valeur de l’indicateur appartient à cet intervalle.

Le calcul du méta-indicateur se fait comme décrit dans la règle 2.

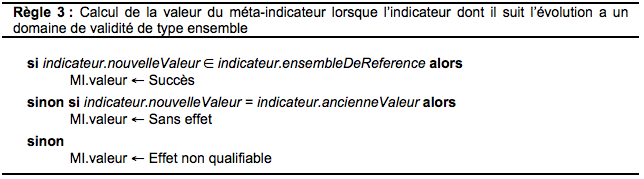

3.3.3. Indicateurs avec un domaine de validité de type ensemble

Lorsque le domaine de validité de l’indicateur est exprimé par un ensemble, il suffit de déterminer si la nouvelle valeur de l’indicateur appartient à cet ensemble pour déterminer la valeur du méta-indicateur.

Le calcul du méta-indicateur se fait comme décrit dans la règle 3.

3.4. Mesure des effets d’une intervention tutorale

déclenchée par plusieurs indicateurs

Les sections précédentes décrivent le calcul de méta-indicateurs attachés à une intervention déclenchée par un indicateur unique. Or, une intervention tutorale peut être déclenchée par plusieurs indicateurs. Dans ce cas, il est nécessaire de suivre l’évolution de chacun de ces indicateurs pour pouvoir déterminer la valeur du méta-indicateur.

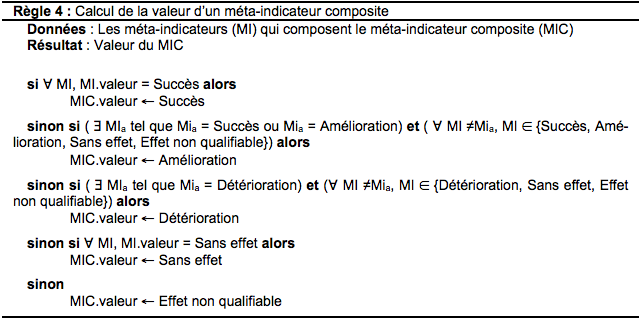

Pour traiter ce cas, nous introduisons un indicateur que nous qualifions de méta-indicateur composite (MIC) car il est composé de plusieurs méta-indicateurs. Chacun de ces méta-indicateurs suit l’évolution de l’un des indicateurs à l’origine de l’intervention. La valeur du MIC est déduite des valeurs de tous les méta-indicateurs qui le composent. Cinq cas sont possibles :

- si tous les méta-indicateurs valent Succès, le MIC vaut Succès et l’intervention est considérée comme effective ;

- si au moins l’un des méta-indicateurs vaut Amélioration ou Succès et si tous les autres prennent leur valeur dans {Succès, Amélioration, Sans effet, Effet non qualifiable} alors le MIC vaut Amélioration et l’intervention est considérée comme ayant eu un effet positif ;

- si au moins l’un des méta-indicateurs vaut Détérioration et si tous les autres prennent leur valeur dans {Détérioration, Sans effet, Effet non qualifiable} alors le MIC vaut Détérioration et l’intervention est considérée comme ayant eu un effet négatif ;

- si tous les méta-indicateurs qui composent le MIC valent Sans effet alors le MIC vaut Sans effet et l’intervention est considérée comme n’ayant eu aucun effet ;

- dans tous les autres cas, le MIC vaut Effet non qualifiable et l’intervention est considérée comme ayant eu un effet mitigé ;

La règle 4 décrit le calcul de la valeur du MIC. Les données d’entrée sont les valeurs des méta-indicateurs qui composent le MIC. En sortie, la règle fournit la valeur du MIC.

4. Mise en œuvre

Afin de démontrer la faisabilité de notre proposition, nous l’avons opérationnalisée dans le cadre de l’apprentissage de la programmation orientée objet. Pour cela, nous avons utilisé HOP3X [HOP3X, 2010], un EIAH tracé, développé au LIUM (Laboratoire d’Informatique de l’Université du Maine). Nous avons identifié et modélisé un ensemble d’indicateurs calibrés à partir de besoins d’observation exprimés par les enseignants. Ces indicateurs ont été implantés dans l’environnement, ainsi que les méta-indicateurs. Enfin, différents outils et fonctionnalités ont été ajoutés à l’environnement pour permettre au tuteur de visualiser les indicateurs et les méta-indicateurs.

4.1. L’environnement HOP3X

L’environnement HOP3X permet au tuteur de suivre en temps réel l’activité individuelle de programmation de plusieurs apprenants. HOP3X est constitué d’un serveur (HOP3X-SERVEUR) et de deux clients : le client étudiant (HOP3X-ÉTUDIANT) et le client enseignant (HOP3X-ENSEIGNANT).

HOP3X-SERVEUR assure la collecte et la sauvegarde des traces d’interaction des participants à la session d’apprentissage. Les traces sauvegardées sont celles de l’activité de l’apprenant à travers toutes les actions qu’il effectue pour réaliser son activité (ex : création d’un fichier, insertion d’un texte, compilation, etc.) mais également celles de l’activité du tuteur à travers ses interventions.

HOP3X-ÉTUDIANT permet à l’apprenant de réaliser une activité de travaux pratiques. L’interface de l’environnement HOP3X-ÉTUDIANT présente l’énoncé pédagogique sous forme d’une succession de questions et de consignes se rapportant à ces questions. L’apprenant peut écrire un programme dans un langage supporté par Hop3x (Java, C, Ruby, NXC, etc.), compiler et exécuter son programme.

HOP3X-ENSEIGNANT permet au tuteur de suivre en temps réel l’activité de chaque apprenant.

4.2. Les activités pédagogiques

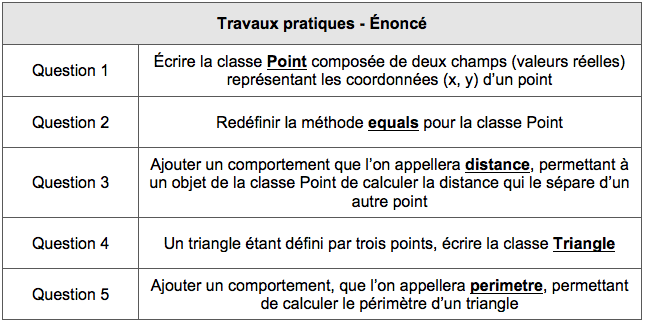

Nous nous sommes intéressés à la première séance de travaux pratiques liée à l’unité d’enseignement « Programmation Orientée Objet et Java », dispensée aux étudiants de troisième année de Licence Informatique à l’université du Maine.

L’énoncé du TP comporte douze questions. Les concepts à mettre en œuvre à travers cet énoncé concernent les classes, les méthodes, les instances, les messages, l’encapsulation et le polymorphisme. Le tableau 4 donne un exemple des questions à traiter.

Tableau 4 • Exemples de questions du TP

4.3. Identification, définition et modélisation des indicateurs

Les indicateurs pédagogiques utilisés dans HOP3X ont été identifiés et définis à partir des besoins d’observation issus des énoncés présentés dans la section précédente et des objectifs d’activité, puis ils ont été modélisés et implantés dans l’environnement.

Les besoins d’observation ont été identifiés à partir de deux sources : l’équipe pédagogique et un corpus de traces.

D’une part, l’équipe pédagogique a exprimé ses attendus pédagogiques à partir des objectifs de l’activité et des énoncés. Elle en a déduit ses besoins d’observation et les a répartis en trois catégories : doit faire (ce que l’étudiant doit impérativement inclure dans sa production), devrait penser à faire (ce que l’étudiant devrait, idéalement, inclure dans sa production) et ne doit pas faire (les erreurs typiques).

D’autre part, nous avons constitué un corpus de traces issus d’expérimentations en contexte écologique sur l’énoncé présenté dans la section précédente. Ce corpus nous a permis d’extraire, après analyse, des besoins d’observations liés aux difficultés des apprenants. Ce travail a permis d’enrichir les besoins d’observation de la catégorie « ne doit pas faire » avec les erreurs les plus fréquemment observées.

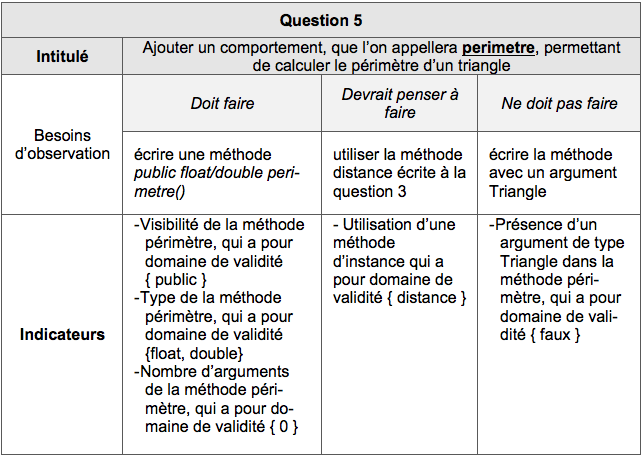

L’identification et la définition des indicateurs s’appuient sur la catégorisation des besoins d’observation. Ainsi, pour la catégorie doit faire ou devrait faire, un besoin d’observation peut entraîner l’identification et la définition d’un ou plusieurs indicateurs. Concernant la catégorie ne doit pas faire, deux cas peuvent se présenter. Lorsque le besoin d’observation identifié est la négation d’un autre besoin d’observation de la catégorie doit faire ou devrait penser à faire, il n’est pas nécessaire de créer un indicateur supplémentaire. Dans les autres cas, un indicateur est déduit du besoin d’observation.

Nous illustrons ces trois cas sur l’exemple de la question 5 du TP dans le tableau 5.

Au total, 71 indicateurs ont été définis pour le TP.

Tableau 5 • Exemples d’indicateurs définis à partir de besoins d’observation

Pour modéliser les indicateurs, le choix s’est porté sur le méta-langage générique UTL (Choquet et Iksal, 2007), lequel est associé à un calculateur d’indicateurs utilisant le langage DCL4UTL (Pham Thi Ngoc, 2011). En effet, UTL permet la description de données nécessaires à l’analyse des traces, indépendamment du langage de scénarisation et du format de représentation des différentes traces (Choquet et Iksal, 2007). Il permet également de définir des besoins d’observation et de spécifier les moyens techniques pour acquérir les données à observer. Un indicateur est décrit en détaillant les données nécessaires à son obtention ainsi que l’usage qui va en être fait.

UTL permet la description d’indicateurs selon trois facettes : DEFINING, GETTING et USING. La facette DEFINING concerne la modélisation du besoin d’observation et la facette GETTING, la modélisation du moyen d’observation. La facette USING concerne l’utilisation faite de la donnée observée. Concrètement, pour modéliser les indicateurs, nous avons utilisé un éditeur disponible en ligne (EditeurUTL, 2012) et permettant de décrire les indicateurs UTL à partir des trois facettes conformément au modèle d’information d’un indicateur établi dans (Choquet et Iksal, 2007).

4.4. Outils et fonctionnalités destinés au tuteur

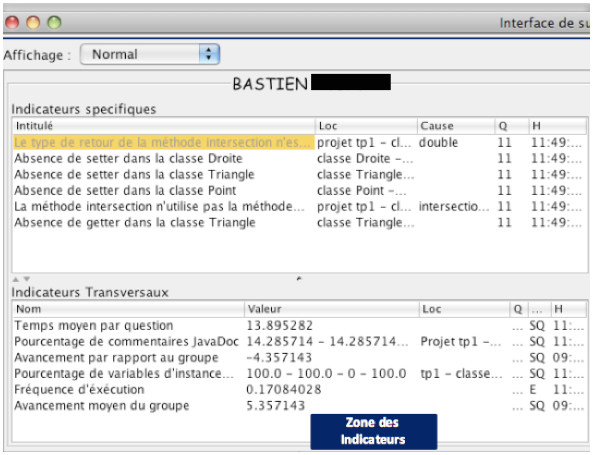

Pour que le tuteur puisse visualiser les indicateurs liés à l’activité de l’apprenant et les méta-indicateurs liés à ses interventions, nous avons enrichi le client HOP3X-ENSEIGNANT en lui ajoutant deux espaces : l’espace indicateurs et l’espace interventions.

4.4.1. L’espace indicateurs

Afin de réguler l’activité d’un apprenant, le tuteur a besoin de visualiser les indicateurs le concernant et d’intervenir si nécessaire. L’espace indicateurs est ainsi constitué de :

- la zone dans laquelle sont affichés les indicateurs. Pour ne pas encombrer cette zone, seuls les indicateurs dont la valeur est hors du domaine de validité sont affichés.

- la zone de communication qui offre au tuteur les outils pour intervenir en mode texte ou en mode audio auprès de l’apprenant. Lorsque le tuteur intervient, il peut sélectionner au préalable le ou les indicateurs qui motivent son intervention (Lekira et al., 2011). Dans ce cas, l’intervention est liée aux indicateurs qui l’ont déclenchée et un méta-indicateur est automatiquement créé.

- la zone d’alerte qui informe le tuteur en permanence de l’apparition de situations critiques dans l’activité d’un apprenant autre que celui qu’il est en train d’observer. En effet, pendant que le tuteur suit un apprenant particulier, des situations critiques peuvent apparaître chez d’autres apprenants.

Figure 3 • Zone des indicateurs dans

HOP3X-ENSEIGNANT

4.4.2. L’espace interventions

L’espace interventions permet de visualiser les interventions précédentes et d’estimer leur effectivité, grâce aux méta-indicateurs. Un code couleur aide le tuteur à identifier rapidement les effets réels de son intervention : vert pour les interventions effectives, rouge pour les interventions n’ayant pas eu d’effet (ou un effet négatif) et orange pour toutes les autres (effet mitigé ou positif).

Lorsqu’une intervention n’a pas été effective, le tuteur a la possibilité de ré-intervenir en sélectionnant cette intervention via l’interface. Cette action a pour effet de lier la nouvelle intervention à l’intervention sélectionnée. Une ré-intervention est considérée comme une intervention qui porte sur la même situation critique que la première intervention effectuée, appelée intervention initiale.

Par ailleurs, le tuteur peut visualiser l’historique de l’intervention. Pour cela, il a accès au détail de l’intervention initiale et des ré-interventions ainsi qu’à l’historique des valeurs du méta-indicateur et de l’évolution des indicateurs.

Figure 4 • Zone des interventions dans

HOP3X-ENSEIGNANT

4.4.3. Exemple de séquence d’intervention

Nous donnons un exemple de séquence d’interventions en nous appuyant sur la question 1 présentée dans le tableau 4. L’apprenant doit écrire une classe Point comportant deux variables d’instance représentant les coordonnées réelles x et y d’un point. Afin de respecter le principe d’encapsulation, la visibilité de ces deux variables doit être « private ».

Dans un premier temps, l’étudiant déclare ces variables avec une visibilité « public » :

public float x,y ;

Le tuteur sélectionne l’indicateur « Visibilité des variables d’instance » de la question 1 et envoie un message texte à l’étudiant : « Ta classe Point ne respecte pas le principe d’encapsulation car tes variables d’instance sont publiques ». L’étudiant réagit en supprimant le modificateur « public ».

float x,y ;

Quelques minutes plus tard, le tuteur constate, grâce au méta-indicateur, que son intervention n’a pas eu l’effet escompté. Il ré-intervient donc en envoyant un second message à l’étudiant : « Il ne suffit pas que tes variables ne soient pas publiques, il faut les protéger ». A ce moment, l’étudiant ajoute le modificateur « private ».

private float x,y ;

L’intervention est désormais considérée comme effective et le méta-indicateur associé vaut succès.

5. Expérimentations et évaluation

L’hypothèse à la base de notre travail est que les informations fournies par les méta-indicateurs permettent au tuteur d’intervenir plus efficacement. Afin de vérifier cette hypothèse, nous avons conduit deux séries d’expérimentations, l’une avec méta-indicateurs et l’autre sans, et nous avons analysé leurs résultats. Les données recueillies ont été comparées afin de déterminer, d’une part, si les méta-indicateurs améliorent le taux de succès des interventions du tuteur et, d’autre part, si cette amélioration de l’efficacité du tuteur a un impact positif sur l’activité et les productions des apprenants (Lekira et al., 2012).

5.1. Protocole et données recueillies

La première expérimentation a impliqué deux tuteurs et trente-six étudiants de licence informatique à l’université du Maine. La deuxième expérimentation a impliqué quarante-cinq étudiants de licence informatique à l’université du Maine et quatre tuteurs dont deux ayant participé à la première. Chaque séance a duré trois heures.

Par la suite, nous appellerons « groupe I » le groupe ayant participé à l’expérimentation où les tuteurs avaient uniquement à leur disposition les indicateurs et « groupe IMI » le groupe ayant participé à l’expérimentation où les tuteurs avaient à leur disposition les indicateurs et les méta-indicateurs.

Aux cours de ces expérimentations, toutes les traces d’activité des apprenants et des tuteurs ont été recueillies. Pour la suite de l’analyse, nous exploitons principalement :

- les valeurs successives prises par les indicateurs et méta-indicateurs aux cours des sessions, pour chaque apprenant ;

- les interventions des tuteurs et leur objet (indicateurs à l’origine de l’intervention).

Au total, 216 interventions ont été effectuées dans le groupe I et 267 dans le groupe IMI.

5.2. Effet des méta-indicateurs sur les interventions des tuteurs

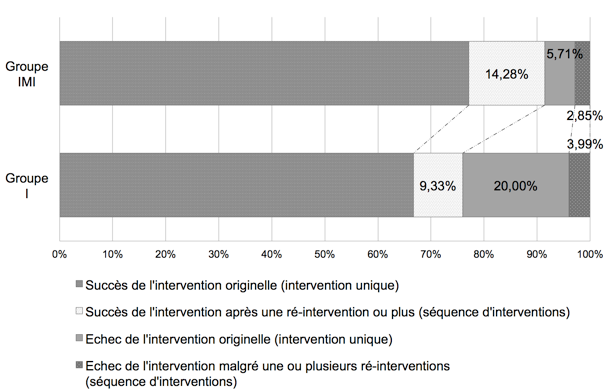

Afin de mesurer l’apport des méta-indicateurs sur l’activité du tuteur, nous distinguons deux catégories d’interventions : les interventions uniques et les séquences d’interventions. Une intervention unique est exclusivement composée de l’intervention initiale. Une séquence d’interventions est une série d’interventions ayant le même objet (le même ensemble d’indicateurs), composée de l’intervention initiale et des ré-interventions qui lui succèdent. Cette définition ne tient pas compte de la durée entre deux interventions consécutives, mais uniquement de l’objet de l’intervention ; autrement dit nous considérons que deux interventions font partie de la même séquence dès lors qu’elles ont exactement le même objet, quel que soit le laps de temps qui les sépare. Une séquence d’interventions est un succès, si au terme de la séquence, elle a eu l’effet escompté et que l’apprenant finit par résoudre le problème pour lequel le tuteur est intervenu.

Dans le groupe IMI, nous considérons qu’il y a ré-intervention lorsque le tuteur intervient en sélectionnant l’une de ses interventions qui n’a pas réussi. Dans le groupe I, où les tuteurs ne disposaient pas des méta-indicateurs, nous considérons que lorsqu’un tuteur intervient plusieurs fois de suite en sélectionnant exactement le même ensemble d’indicateurs, il s’agit d’une séquence d’interventions ayant le même objet.

Les méta-indicateurs fournissent au tuteur des informations sur le résultat de ses interventions. En cas d’échec, ils rappellent au tuteur qu’un apprenant n’a toujours pas résolu une situation critique sur laquelle il était intervenu. Le tuteur est ainsi incité à ré-intervenir. Par conséquent, nous pouvons supposer que fournir au tuteur des informations sur les effets de ses interventions à travers les méta-indicateurs va augmenter le taux global d’interventions effectives (hypothèse Ha) et que cette augmentation est due à l’accroissement du nombre d’interventions effectives du fait des ré-interventions (hypothèse Hb).

Figure 5 • Répartition des interventions tutorales

pour les deux groupes

Comme le montre la figure 5, 75,99% (66,66% + 9,33%) de toutes les interventions (nous tenons compte à la fois des interventions uniques et des séquences d’interventions) ont eu du succès pour le groupe I. Pour le groupe IMI, ce taux est de 91,42% (77,14% + 14,28%). Ces chiffres montrent une hausse de 15,43 points du taux global d’interventions réussies.

Cette différence est statistiquement significative. Pour le vérifier, nous avons utilisé un test de comparaison de proportion (z-test). Pour un risque d’erreur α=5%, avec l’hypothèse H0 : p1 ≥p2 et H1 : p1<p2, T=6,43 > u0,95 = 1,64.

Ce résultat valide notre hypothèse Ha: fournir au tuteur des informations sur les effets de ses interventions à travers les méta-indicateurs augmente le taux global d’interventions effectives.

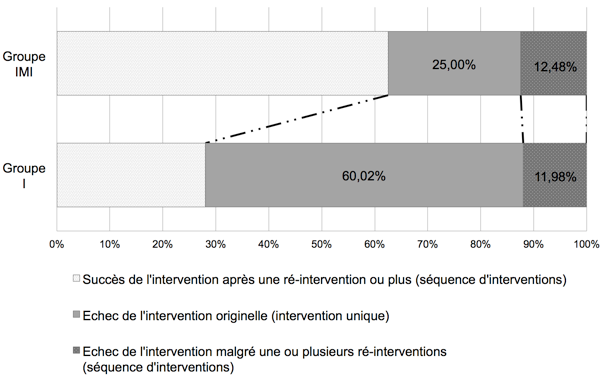

Considérons maintenant l’hypothèse Hb : l’augmentation du taux global d’interventions effectives est due aux ré-interventions. Comme nous nous intéressons ici à l’impact des ré-interventions sur l’augmentation du taux d’interventions effectives, nous écartons les interventions qui ont été effectives du premier coup afin de ne prendre en compte que les cas où les interventions initiales ont échoué (cf. Figure 6).

On observe tout d’abord que le taux de ré-intervention augmente : il passe de 39,98% (28% + 11,98%) dans le groupe I à 75% (62,52% + 12,48%) dans le groupe IMI. Plus précisément, c’est la proportion de séquences d’interventions réussies qui augmente (elle passe de 28% à 62,52%), tandis que la proportion de séquences d’intervention qui échouent reste stable. D’autre part, la proportion d’interventions uniques qui échouent décroit dans les mêmes proportions : elle passe de 60,02% à 25%. Nous interprétons ces évolutions symétriques comme une conséquence directe de la présence des méta-indicateurs. Lorsqu’une intervention initiale échoue, le méta-indicateur rappelle au tuteur que la situation critique n’a pas été résolue et l’incite à ré-intervenir, plusieurs fois si nécessaire, jusqu’à ce que le problème soit surmonté. Les méta-indicateurs ont donc pour effet de réduire le taux d’interventions uniques sans effet, et d’augmenter d’autant le taux de séquences d’interventions réussies. Ce résultat valide ainsi l’hypothèse Hb..

Figure 6 • Répartition des ré-interventions

tutorales pour les deux groupes

Par ailleurs, une observation, qui conforte nos hypothèses, concerne le temps de réaction du tuteur entre deux interventions. Ce temps diminue lorsque le tuteur a des méta-indicateurs à sa disposition. En effet, nous avons constaté que le temps entre l’intervention initiale et les ré-interventions qui y sont liées est de 34 minutes en moyenne pour le groupe I (entre 7 minutes et 120 minutes) tandis qu’il est de 13 minutes seulement pour le groupe IMI (entre 2 et 34 minutes).

5.3. Effets des méta-indicateurs sur l’activité de l’apprenant

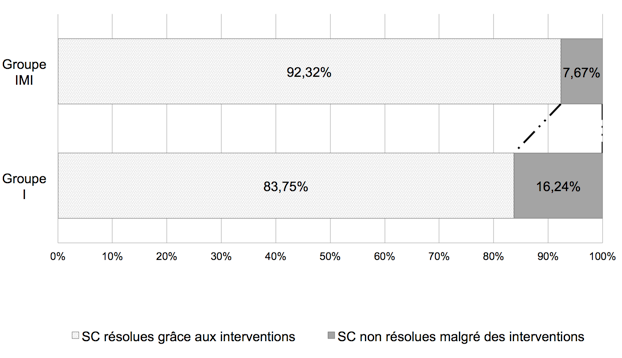

Afin de déterminer si l’amélioration du taux de réussite des interventions du tuteur a un impact positif sur l’activité de l’apprenant, nous examinons si les apprenants résolvent mieux les situations critiques auxquelles ils sont confrontés lorsque le tuteur dispose des méta-indicateurs.

Parmi toutes les situations critiques rencontrées, certaines évoluent positivement, c’est-à-dire que les valeurs des indicateurs sont redevenues conformes à la fin de la session. Par ailleurs, certaines situations critiques sont résolues sans intervention du tuteur, lorsque l’étudiant s’auto-corrige. Pour pouvoir mesurer l’impact de l’amélioration du taux de réussite des interventions du tuteur sur l’activité de l’apprenant, nous nous intéressons aux situations critiques qui ont fait l’objet d’une intervention tutorale. Les deux groupes sont homogènes si l’on considère le nombre de situations critiques apparues par session: en moyenne, par étudiant, il y en a eu 16,85 pour le groupe I et 16,79 pour le groupe IMI.

Figure 7 • Répartition des situations critiques

pour les deux groupes

La figure 7 montre la distribution des situations critiques qui ont fait l’objet d’une intervention tutorale en fonction de leur résolution à la fin de la session. Le taux de résolution passe de 83,74% à 92,32% entre le groupe I et le groupe IMI. Cette augmentation est probablement due aux interventions effectives, dont le nombre a augmenté avec l’introduction des méta-indicateurs (cf. section précédente). La différence est statistiquement significative (T = 4,95).

Cependant, pour le groupe IMI, il y a 7,67 % de situations critiques non résolues malgré une intervention tutorale. Cette catégorie correspond aux interventions auprès d’apprenants qui avaient de très grandes difficultés en programmation.

Ces résultats tendent à prouver que l’introduction des méta-indicateurs, qui induisent une meilleure réussite des interventions tutorales, a un impact positif sur les productions des apprenants car ils ont mieux surmonté leurs difficultés lorsque les tuteurs avaient un feedback sur leurs interventions.

6. Conclusion

Dans cet article, nous nous sommes intéressés à rendre compte des effets des interventions du tuteur lorsque cette intervention concerne une remédiation. Afin de fournir cette information au tuteur, nous nous sommes appuyés sur les indicateurs calibrés. Nous avons introduit la notion de méta-indicateurs : une variable qui permet de mesurer les effets d’une intervention tutorale en assurant le suivi des indicateurs concernés. Le calcul de la valeur d’un méta-indicateur repose sur les valeurs et le domaine de validité des indicateurs à l’origine de l’intervention.

Afin d’opérationnaliser et de montrer la faisabilité de notre proposition, celle-ci a été mise en œuvre dans le domaine de la programmation orientée objet à travers l’EIAH HOP3X. Nous avons ainsi mené différentes expérimentations dont l’objectif était d’observer dans l’usage l’impact des méta-indicateurs sur l’activité du tuteur et sur celle de l’apprenant. Les résultats de ces expérimentations ont montré que de telles informations amélioraient le taux de réussite des interventions du tuteur. Par ailleurs, cette amélioration tend à avoir un effet positif sur l’activité et les productions de l’apprenant puisque ce dernier résout mieux les situations critiques auxquelles il est confronté lorsque le tuteur dispose de retours sur les effets de ses interventions.

Nous avons proposé quatre règles de calcul des méta-indicateurs. Dans ces règles, il n’est fait référence ni au domaine d’apprentissage, ni au type d’activité, ni à l’EIAH utilisé. Pour le calcul d’un méta-indicateur, il n’est tenu compte que du domaine de validité des indicateurs dont il suit l’évolution. De ce fait ces méthodes de calcul sont génériques et notre proposition peut s’appliquer à n’importe quel EIAH disposant d’indicateurs calibrés avec un domaine de validité. Par conséquent, il est possible de réutiliser notre proposition, dans le cadre de son champ d’application qui recouvre les EIAH disposant d’indicateurs calibrés avec un domaine de validité, en implémentant les méthodes de calcul génériques des méta-indicateurs, en concevant une interface de visualisation de ces méta-indicateurs et en mettant en place un système qui permet de lier les indicateurs calibrés aux interventions tutorales.

Une perspective ouverte par ce travail concerne la capitalisation de l’expérience du tuteur. L’objectif est de réutiliser les interventions tutorales et notamment, les interventions effectives. Pour cela, nous proposons de suggérer au tuteur des interventions effectives lorsqu’il se retrouve devant une situation critique similaire à une autre déjà traitée efficacement.

BIBLIOGRAPHIE

Bousbia N., Labat J.-M., Rebai R. et Balla A. (2009). « Indicators for deducting the learner’s learning style: case of the navigation typology indicator ». Proceedings of the 9th IEEE International Conference on Advanced Learning Technologies (ICALT’09), p. 485-389.

Choquet C., Iksal S. (2007). « Modélisation et construction de traces d'utilisation d'une activité d'apprentissage: une approche langage pour la ré-ingénierie d'un EIAH ». Revue Sciences et Technologies de l´Information et de la Communication pour l´Éducation et la Formation, Vol. 14. Disponible sur internet : http://sticef.univ-lemans.fr/num/vol2007/14-choquet/sticef_2007_choquet_14.htm (consulté le 8 juillet 2013).

Capa-Aydin Y., Sungur S. et Uzuntiryaki E. (2009). « Teacher self-regulation: examining a multidimensional construct ». Educational Psychology, Vol. 29 n°3, p. 345-356.

Delorme F. et Loosli G. (2006). « Un outil générique pour l’analyse automatique et la visualisation de productions d’apprenants ». Actes du colloque international sur les Technologies de l’Information et de la Communication pour les Enseignements d’ingénieur et dans l’industrie (TICE’06).

Denis B. (2003). « Quels rôles et quelle formation pour les tuteurs intervenant dans des dispositifs de formation à distance ? ». Distance et savoirs, Vol.1 n°1, p.19-46.

Després Ch. (2001). Modélisation et conception d’un environnement de suivi pédagogique synchrone d’activités d’apprentissage à distance. Thèse de l’université du Maine, Le Mans.

Dimitracopoulou A., Martinez A., Dimitriadis Y., Morch A., Ludvigsen S., Harrer A., Hoppe U., Barros B., Verdejo F., Hulshof C., Jong de T., Fesakis G.and Petrou A., Lund K., Baker M., Jermann P., Dillenbourg P., Kollias V. et Vosniadou S. (2004). State of the art on interaction analysis : interaction analysis indicators. Délivrable D26.1 du JEIRP (Jointly Executed Integrated Research Project) ICALTS (Interaction and Collaboration Analysis Supporting Teachers' and Students' Self-regulation) du réseau européen Kaleidoscope.

Dimitracopoulou A., Kollias V., Harrer A., Martinez A., Petrou A., Dimitriadis Y., Antonio J., Bollen L., Wichmann A. (2005). State of the art on interaction analysis. Délivrable D.31.1 du JEIRP (Jointly Executed Integrated Research Project) IA (Supporting Participants in Technology-based Learning Activities) du réseau européen Kaléidoscope.

DPULS (2005). DPULS: Design Patterns for recording and analysing Usages of Learning Systems. Rapport technique du réseau européen Kaléidoscope.

Editeur UTL (2012). http://eiah.univ-lemans.fr/UTL/UTL.xml

France L., Héraud J.-M., Marty J.-C. et Caron T. (2007). « Visualisation et régulation de l’activité des apprenants dans un EIAH tracé ». Actes de la conférence Environnements Informatiques pour l’Apprentissage Humain (EIAH’07), Lausanne, Suisse.

Garrot E. (2008). Plateforme support à l’interconnexion de communauté de pratiques. Application au tutorat avec TE-CAP. Thèse de doctorat, Institut National des Sciences Appliquées (INSA), Lyon.

Glikman V. (2011). « Tuteur à distance : une fonction, un métier, une identité ? ». Le tutorat en formation à distance, Bruxelles, Éditions De Boeck, coll. « Perspectives en éducation et formation » p. 137-158.

Guéraud V., Adam J., Pernin J., Calvary G. et David J. (2004). « L'exploitation d'objets pédagogiques interactifs à distance : le projet FORMID ». Revue Sciences et Technologies de l´Information et de la Communication pour l´Éducation et la Formation, vol. 11. Disponible sur internet : http://sticef.univ-lemans.fr/num/vol2004/gueraud-03/sticef_2004_gueraud_03.htm (consulté le 8 juillet 2013).

Guéraud V., Adam J., Lejeune A., Mandran N., Vézian N. et Dubois M. (2009). « Expérimentation d'un environnement flexible pour la supervision de travaux pratiques basés sur des simulations ». Acte de la conférence Environnements Informatiques pour l'Apprentissage Humain (EIAH’09), Le Mans, France, p. 279-286.

Guillaume N. (2009). « Un modèle d’animation : vision synthétique des fonctions tutorales ». Tutorales, la revue de t@d, la communauté de pratiques des tuteurs à distance, No 2, p. 7-17.

Harrer A., Barros B., Bollen L., Dimitracopoulo A., Fesakis G., Hulshof C., Kollias V., Malzahn N., Martinez A., Morch A. et Petrou A. (2004). Unified framework on interaction analysis. Délivrable D26.2.2 du JEIRP ICALTS du réseau européen Kaléidoscope.

Hop3x (2010). http://eiah.univ-lemans.fr/HOP3X/HOP3X.xml

Iksal S., Choquet C. et Pham Thi Ngoc D. (2010). « A generic modeling of indicator with UTL: the collaborative action function example ». 2nd International Conference on Computer Supported Education, Valencia, Spain, p. 114-119.

Jermann P. et Dimitracopoulo A. (2004). Future research directions. Délivrable D26.3 du JEIRP ICALTS du réseau européen Kaléidoscope.

Labat J.M. (2002). « EIAH : quel retour d'informations pour le tuteur ». Colloque International sur les Technologies de l'Information et de la Communication pour les Enseignements d'Ingénieurs et dans l'industrie (TICE’02), Lyon, France.

Lebel C. (1993). L’autonomie de l’étudiant à distance : représentations discursives de tuteurs. Thèse de l’université de Montréal, Canada.

Lefèvre M. (2009). Processus unifié pour la personnalisation des activités pédagogiques : méta-modèle, modèles et outils. Thèse de l’université de Lyon.

Lekira A. (2012). Rendre compte des effets des interventions du tuteur à travers une approche orientée indicateurs. Thèse de l’université du Maine, Le Mans, France.

Lekira A., Després C. et Jacoboni P. (2011). « Supporting the identification of teachers' intention through indicators ». 3rd International Conference on Computer Supported Education, Noordwijkerhout, Pays-Bas, Vol. 2, p. 111-116.

Lekira A., Després C., Jacoboni P. et Py D. (2012). « Supporting teachers to enhance teachers' and students' performance ». 12th IEEE International Conference on Advanced Learning Technologies, Rome, Italie.

Mazza R. et Dimitrova V. (2007). « Coursevis : a graphical student monitoring tool for facilitating instructors in web-based distance courses ». International Journal in Human-Computer Studies, Vol. 65 n°2, p. 125-139.

Pham Thi Ngoc D. (2011). Spécification et conception de services d’analyse de l’utilisation d’un environnement informatique pour l’apprentissage humain. Thèse de l’université du Maine, Le Mans.

Quintin J.-J. (2008). Accompagnement tutoral d’une formation collective via internet. Analyse des effets de cinq modalités d’intervention tutorale sur l’apprentissage en groupes restreints. Thèse de l’université de Mons-Hainaut (Belgique) et de l’université Stendhal Grenoble III (France).

Zimmerman B. (2000). « Attaining self-regulation: a social cognitive perspective ». Handbook of Self-regulation, p. 13-38.

À

propos des auteurs

À

propos des auteurs

Aina Lekira est docteur en informatique. Elle a soutenu une thèse en 2012 à l’université du Maine sur le thème du soutien à l’activité du tuteur à travers une approche orientée indicateurs.

Adresse : LIUM, Université du Maine, Avenue Messiaen, 72085 Le Mans Cedex 9

Courriel : aina.lekira@gmail.com

Christophe Després est Maître de Conférence en Informatique à l’Université du Maine. Chercheur au LIUM. Il est a l’initiative du projet Pédalo dont l’objectif est de fournir des outils et méthodes pour aider les acteurs de la formation à organiser leurs activités. Il a conçu et développé avec Pierre Jacoboni l’EIAH Hop3x.

Adresse : LIUM, Université du Maine, Avenue Messiaen, 72085 Le Mans Cedex 9

Courriel : Christophe.Despres@univ-lemans.fr

Pierre Jacoboni est Maître de Conférence en Informatique à l’Université du Maine. Chercheur au LIUM, membre de l’équipe Ingénierie des EIAH, Il s’interesse à la conception et a l’Instrumentation des activités des acteurs dans les EIAH. Il est à l’origine du projet Hop3x, un EIAH conçu et développé avec Christophe Després.

Adresse : LIUM, Université du Maine, Avenue Messiaen, 72085 Le Mans Cedex 9

Courriel : Pierre.Jacoboni@univ-lemans.fr

Dominique Py est professeure en informatique à l’Université du Maine depuis 2003. Elle a soutenu une habilitation à diriger des recherches en 2001, à l’université de Rennes I. Elle effectue actuellement sa recherche au Laboratoire d’Informatique de l’Université du Maine. Ses principaux centres d’intérêt sont la conception des EIAH et la modélisation de l’apprenant.

Adresse : LIUM, Université du Maine, Avenue Messiaen, 72085 Le Mans Cedex 9

Courriel : dominique.py@lium.univ-lemans.fr

Aina LEKIRA, Christophe DESPRÉS, Pierre JACOBONI, Dominique PY, Rendre compte au tuteur des effets de ses interventions à l’aide de méta-indicateurs , Revue STICEF, Volume 21, 2014, ISSN : 1764-7223, mis en ligne le 11/07/2014, http://sticef.org

© Revue Sciences et Technologies de l´Information et de la Communication pour l´Éducation et la Formation, 2014